Di seguito è descritta la semantica delle operazioni definite nell'interfaccia

XlaBuilder. In genere, queste operazioni mappano one-to-one alle operazioni definite

nell'interfaccia RPC in

xla_data.proto.

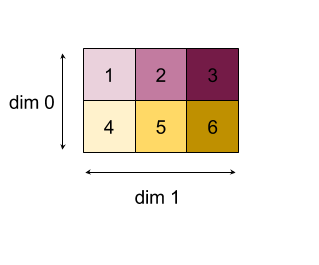

Una nota sulla nomenclatura: il tipo di dati generalizzato gestito da XLA è un array N-dimensionale contenente elementi di un tipo uniforme (ad esempio un numero in virgola mobile a 32 bit). In tutta la documentazione, array viene utilizzato per indicare un array di dimensioni arbitrarie. Per comodità, i casi speciali hanno nomi più specifici e familiari; ad esempio, un vettore è un array unidimensionale, mentre una matrice è un array bidimensionale.

AfterAll

Vedi anche

XlaBuilder::AfterAll.

AfterAll prende un numero variabile di token e produce un singolo token. I token

sono tipi primitivi che possono essere inseriti tra operazioni con effetti collaterali per

obbligare l'ordinamento. AfterAll può essere utilizzato come unione di token per ordinare un'operazione dopo un insieme di operazioni.

AfterAll(operands)

| Argomenti | Tipo | Semantica |

|---|---|---|

operands |

XlaOp |

numero variadico di token |

AllGather

Vedi anche

XlaBuilder::AllGather.

Esegue la concatenazione tra le repliche.

AllGather(operand, all_gather_dim, shard_count, replica_group_ids,

channel_id)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand

|

XlaOp

|

L'array da concatenare tra le repliche |

all_gather_dim |

int64 |

Dimensione di concatenazione |

replica_groups

|

vettore di vettori di

int64 |

I gruppi tra i quali viene eseguita la concatenazione |

channel_id

|

int64 facoltativo

|

ID canale facoltativo per la comunicazione tra moduli |

replica_groupsè un elenco di gruppi di repliche tra i quali viene eseguita la concatenazione (l'ID replica della replica attuale può essere recuperato utilizzandoReplicaId). L'ordine delle repliche in ogni gruppo determina l'ordine in cui si trovano i relativi input nel risultato.replica_groupsdeve essere vuoto (in questo caso tutte le repliche appartengono a un singolo gruppo, ordinate da0aN - 1) o contenere lo stesso numero di elementi del numero di repliche. Ad esempio,replica_groups = {0, 2}, {1, 3}esegue la concatenazione tra le repliche0e2e1e3.shard_countè la dimensione di ogni gruppo di repliche. Ne abbiamo bisogno nei casi in cuireplica_groupssono vuoti.channel_idviene utilizzato per la comunicazione tra moduli: solo le operazioniall-gathercon lo stessochannel_idpossono comunicare tra loro.

La forma di output è la forma di input con all_gather_dim moltiplicato per shard_count. Ad esempio, se ci sono due repliche e l'operando ha rispettivamente i valori [1.0, 2.5] e [3.0, 5.25] nelle due repliche, il valore di output di questa operazione in cui all_gather_dim è 0 sarà [1.0, 2.5, 3.0,

5.25] su entrambe le repliche.

AllReduce

Vedi anche

XlaBuilder::AllReduce.

Esegue un calcolo personalizzato tra le repliche.

AllReduce(operand, computation, replica_group_ids, channel_id)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand

|

XlaOp

|

un array o una tupla non vuota di array per ridurre le repliche |

computation |

XlaComputation |

Computing della riduzione |

replica_groups

|

vettore dei vettori di

int64 |

Gruppi tra i quali vengono eseguite le riduzioni |

channel_id

|

int64 facoltativo

|

ID canale facoltativo per le comunicazioni tra moduli |

- Quando

operandè una tupla di array, l'operazione all-reduce viene eseguita su ogni elemento della tupla. replica_groupsè un elenco di gruppi di repliche tra i quali viene eseguita la riduzione (l'ID replica della replica attuale può essere recuperato utilizzandoReplicaId).replica_groupsdeve essere vuoto (in questo caso tutte le repliche appartengono a un singolo gruppo) o contenere lo stesso numero di elementi delle repliche. Ad esempio,replica_groups = {0, 2}, {1, 3}esegue la riduzione tra le repliche0e2e1e3.channel_idviene utilizzato per la comunicazione tra moduli: solo le operazioni diall-reducecon lo stessochannel_idpossono comunicare tra loro.

La forma di output è uguale alla forma di input. Ad esempio, se ci sono due

repliche e l'operando ha il valore [1.0, 2.5] e [3.0, 5.25]

rispettivamente sulle due repliche, il valore di output di questa op e

del calcolo della somma sarà [4.0, 7.75] su entrambe le repliche. Se l'input è una tuple, anche l'output è una tuple.

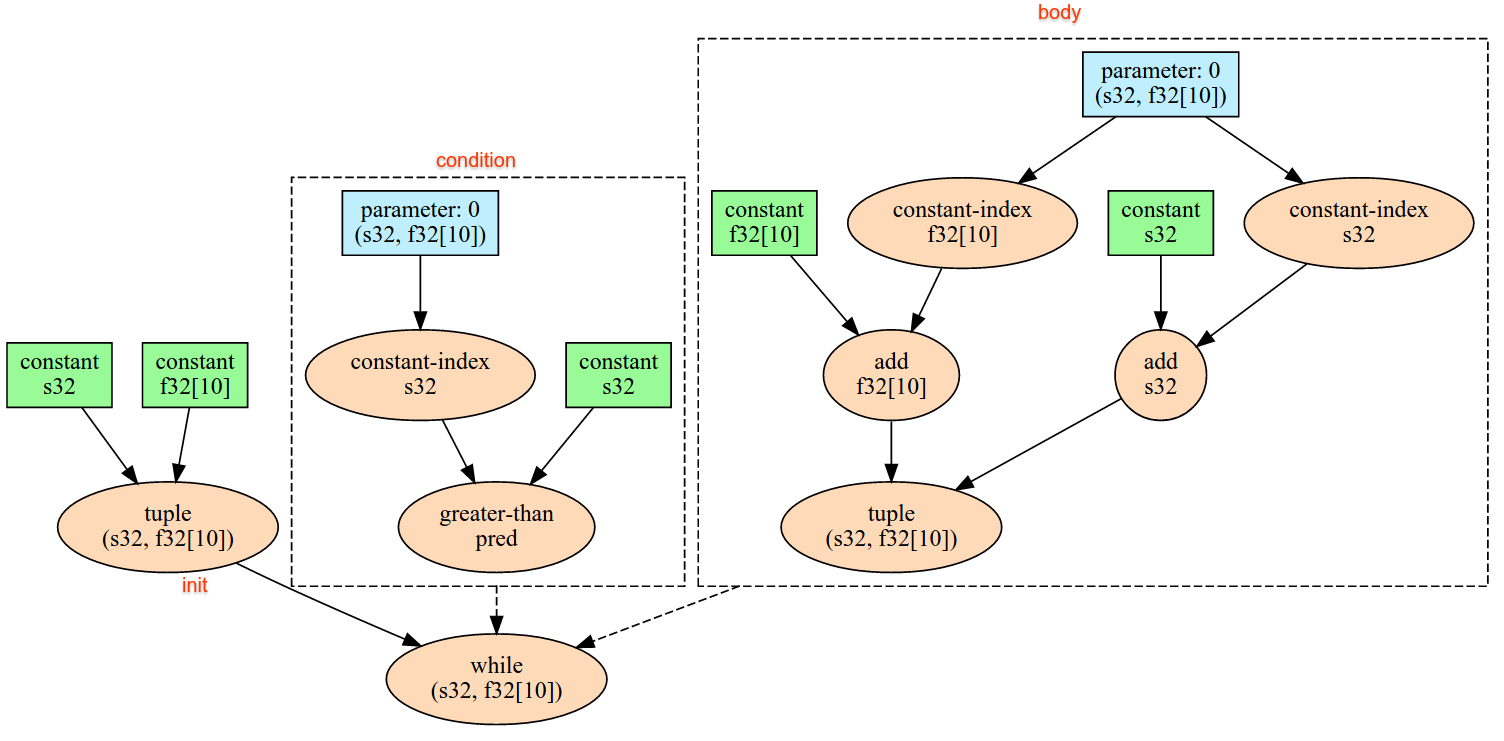

Il calcolo del risultato di AllReduce richiede un input per ogni replica, quindi se una replica esegue un nodo AllReduce più volte di un'altra, la replica precedente attenderà all'infinito. Poiché tutte le repliche eseguono lo stesso

programma, non ci sono molti modi per farlo accadere, ma è possibile quando

la condizione di un ciclo while dipende dai dati dell'infeed e i dati infed

inducono il ciclo while a eseguire più iterazioni su una replica rispetto a un'altra.

AllToAll

Vedi anche

XlaBuilder::AllToAll.

AllToAll è un'operazione collettiva che invia dati da tutti i core a tutti i core. È composta da due fasi:

- La fase a dispersione. Su ogni core, l'operando è suddiviso in

split_countblocchi lungo ilsplit_dimensionse i blocchi sono sparsi in tutti i core, ad esempio il blocco i-esimo viene inviato al core i-esi. - La fase di raccolta. Ogni core concatena i blocchi ricevuti lungo il

concat_dimension.

I core partecipanti possono essere configurati:

replica_groups: ogni ReplicaGroup contiene un elenco di ID replica che partecipano al calcolo (l'ID replica per la replica attuale può essere recuperato utilizzandoReplicaId). AllToAll verrà applicato all'interno di sottogruppi nell'ordine specificato. Ad esempio,replica_groups = { {1,2,3}, {4,5,0} }indica che verrà applicato un AllToAll all'interno delle repliche{1, 2, 3}e nella fase di raccolta e i blocchi ricevuti verranno concatenati nello stesso ordine di 1, 2, 3. Poi, un altro AllToAll verrà applicato all'interno delle repliche 4, 5, 0 e l'ordine di concatenazione sarà anche 4, 5, 0. Sereplica_groupsè vuoto, tutte le repliche appartengono a un gruppo, nell'ordine di concatenazione della loro apparizione.

Prerequisiti:

- La dimensione dell'operando su

split_dimensionè divisibile persplit_count. - La forma dell'operando non è una tupla.

AllToAll(operand, split_dimension, concat_dimension, split_count,

replica_groups)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

Array di input di n dimensioni |

split_dimension

|

int64

|

Un valore nell'intervallo [0,

n) che indica il nome della dimensione

in base alla quale viene suddiviso

l'operando |

concat_dimension

|

int64

|

Un valore nell'intervallo [0,

n) che indica la dimensione entlang der die Spalten aufgeteilt werden concatenati |

split_count

|

int64

|

Il numero di core che

partecipano a questa operazione. Se

replica_groups è vuoto, deve essere il numero di

repliche; in caso contrario, deve essere uguale al numero

di repliche in ogni gruppo. |

replica_groups

|

Vettore ReplicaGroup

|

Ogni gruppo contiene un elenco di ID replica. |

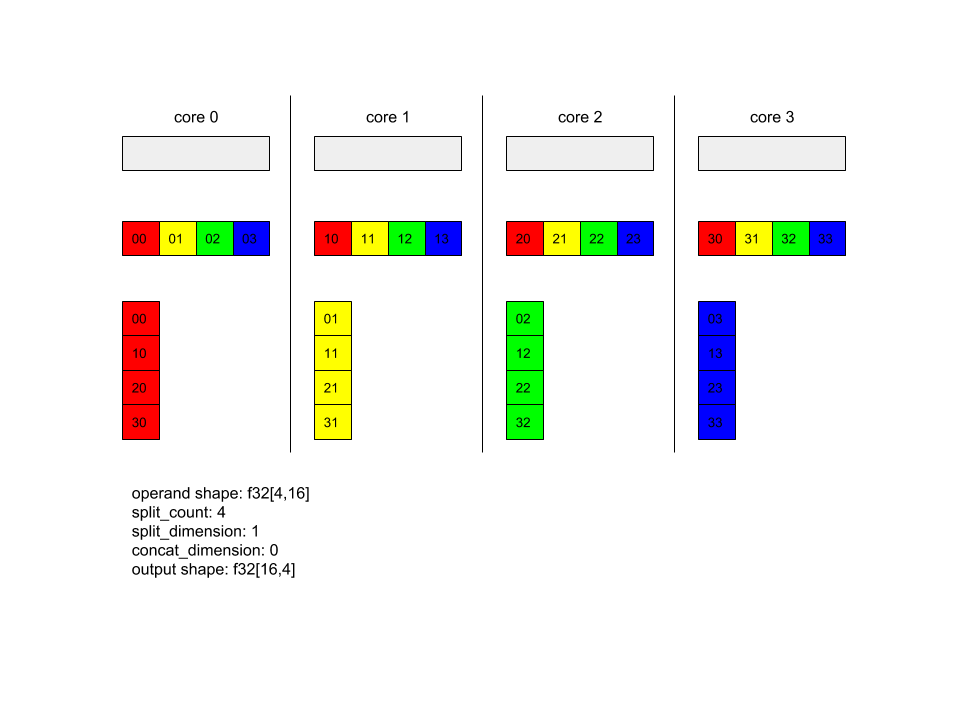

Di seguito è riportato un esempio di Alltoall.

XlaBuilder b("alltoall");

auto x = Parameter(&b, 0, ShapeUtil::MakeShape(F32, {4, 16}), "x");

AllToAll(x, /*split_dimension=*/1, /*concat_dimension=*/0, /*split_count=*/4);

In questo esempio, sono presenti 4 core che partecipano all'operazione Alltoall. Su ogni core, l'operando è suddiviso in 4 parti lungo la dimensione 0, quindi ogni parte ha la forma f32[4,4]. Le 4 parti sono distribuite su tutti i core. Poi ogni core concatena le parti ricevute lungo la dimensione 1, nell'ordine del core 0-4. Pertanto, l'output su ciascun core ha la forma f32[16,4].

BatchNormGrad

Consulta anche

XlaBuilder::BatchNormGrad

e l'articolo originale sulla normalizzazione batch

per una descrizione dettagliata dell'algoritmo.

Calcola i gradienti della norma batch.

BatchNormGrad(operand, scale, mean, variance, grad_output, epsilon, feature_index)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

Array n dimensionale da normalizzare (x) |

scale |

XlaOp |

1 array dimensionale () |

mean |

XlaOp |

Array unidimensionale () |

variance |

XlaOp |

Array unidimensionale () |

grad_output |

XlaOp |

Gradienti passati a BatchNormTraining () |

epsilon |

float |

Valore epsilon () |

feature_index |

int64 |

Indice della dimensione delle caratteristiche in operand |

Per ogni elemento nella dimensione delle funzionalità (feature_index è l'indice della dimensione delle funzionalità in operand), l'operazione calcola i gradienti rispetto a operand, offset e scale in tutte le altre dimensioni. feature_index deve essere un indice valido per la dimensione della funzionalità in operand.

I tre gradienti sono definiti dalle seguenti formule (supponendo un array di 4 dimensioni come operand e con indice di dimensione della funzionalità l, dimensione del batch m e dimensioni spaziali w e h):

Gli input mean e variance rappresentano i valori dei momenti nelle dimensioni di batch e

spaziali.

Il tipo di output è una tupla di tre handle:

| Output | Tipo | Semantica |

|---|---|---|

grad_operand

|

XlaOp

|

gradiente rispetto all'input operand () |

grad_scale

|

XlaOp

|

gradiente rispetto all'input scale () |

grad_offset

|

XlaOp

|

gradiente rispetto all'input offset() |

BatchNormInference

Vedi anche XlaBuilder::BatchNormInference e il documento originale sulla normalizzazione del batch per una descrizione dettagliata dell'algoritmo.

Normalizza un array su dimensioni batch e spaziali.

BatchNormInference(operand, scale, offset, mean, variance, epsilon, feature_index)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

Array n dimensionale da normalizzare |

scale |

XlaOp |

Array unidimensionale |

offset |

XlaOp |

1 array dimensionale |

mean |

XlaOp |

1 array dimensionale |

variance |

XlaOp |

Array unidimensionale |

epsilon |

float |

Valore epsilon |

feature_index |

int64 |

Indice della dimensione delle caratteristiche in operand |

Per ogni caratteristica nella dimensione della caratteristica (feature_index è l'indice della

dimensione della caratteristica in operand), l'operazione calcola la media e la varianza

in tutte le altre dimensioni e utilizza la media e la varianza per normalizzare

ogni elemento in operand. feature_index deve essere un indice valido per la dimensione

delle funzionalità in operand.

BatchNormInference è equivalente alla chiamata a BatchNormTraining senza calcolare mean e variance per ogni batch. Utilizza invece i valori inseriti mean e

variance come valori stimati. Lo scopo di questa operazione è ridurre

la latenza di inferenza, da cui deriva il nome BatchNormInference.

L'output è un array normalizzato n-dimensionale con la stessa forma dell'input operand.

BatchNormTraining

Consulta anche

XlaBuilder::BatchNormTraining

e the original batch normalization paper

per una descrizione dettagliata dell'algoritmo.

Normalizza un array su dimensioni batch e spaziali.

BatchNormTraining(operand, scale, offset, epsilon, feature_index)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

Array n dimensionale da normalizzare (x) |

scale |

XlaOp |

Array unidimensionale () |

offset |

XlaOp |

Array unidimensionale () |

epsilon |

float |

Valore epsilon () |

feature_index |

int64 |

Indice della dimensione della funzionalità in operand |

Per ogni caratteristica nella dimensione della caratteristica (feature_index è l'indice della

dimensione della caratteristica in operand), l'operazione calcola la media e la varianza

in tutte le altre dimensioni e utilizza la media e la varianza per normalizzare

ogni elemento in operand. feature_index deve essere un indice valido per la dimensione

delle funzionalità in operand.

L'algoritmo procede nel seguente modo per ogni batch in operand che contiene elementi m con w e h come dimensioni delle dimensioni spaziali (supponendo che operand sia un array a 4 dimensioni):

Calcola la media del batch per ogni caratteristica

lnella dimensione della caratteristica:Calcola la varianza del batch : $\sigma^2l=\frac{1}{mwh}\sum{i=1}^m\sum{j=1}^w\sum{k=1}^h (x_{ijkl} - \mu_l)^2$

Normalizza, scala e sposta:

Il valore epsilon, solitamente un numero piccolo, viene aggiunto per evitare errori di divisione per zero.

Il tipo di output è una tupla di tre XlaOp:

| Output | Tipo | Semantica |

|---|---|---|

output

|

XlaOp

|

Array n dimensionale con la stessa forma dell'input

operand (y) |

batch_mean |

XlaOp |

Array unidimensionale () |

batch_var |

XlaOp |

1 array dimensionale () |

batch_mean e batch_var sono i momenti calcolati nelle dimensioni del batch e

spaziali utilizzando le formule riportate sopra.

BitcastConvertType

Vedi anche

XlaBuilder::BitcastConvertType.

Analogamente a tf.bitcast in TensorFlow, esegue un'operazione di bitcast elemento per elemento da una forma di dati a una forma di destinazione. Le dimensioni di input e output devono essere uguali: ad esempio, gli elementi s32 diventano elementi f32 tramite la routine di trasmissione di bit e un elemento s32 diventa quattro elementi s8. Il bitcast è implementato come un trasferimento a livello basso, pertanto le macchine con rappresentazioni in virgola mobile diverse daranno risultati diversi.

BitcastConvertType(operand, new_element_type)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

array di tipo T con dimensioni D |

new_element_type |

PrimitiveType |

tipo U |

Le dimensioni dell'operando e della forma di destinazione devono corrispondere, ad eccezione dell'ultima dimensione che cambierà in base al rapporto delle dimensioni primitive prima e dopo la conversione.

I tipi di elementi di origine e di destinazione non devono essere tuple.

Conversione con trasmissione a bit in un tipo primitivo di larghezza diversa

L'istruzione HLO BitcastConvert supporta il caso in cui le dimensioni del tipo di elemento di output T' non siano uguali a quelle dell'elemento di input T. Poiché l'intera operazione è concettualmente un bitcast e non modifica i byte sottostanti, la forma dell'elemento di output deve cambiare. Per B = sizeof(T), B' =

sizeof(T'), esistono due casi possibili.

Innanzitutto, quando B > B', la forma di output riceve una nuova dimensione minore di dimensioneB/B'. Ad esempio:

f16[10,2]{1,0} %output = f16[10,2]{1,0} bitcast-convert(f32[10]{0} %input)

La regola rimane la stessa per gli scalari effettivi:

f16[2]{0} %output = f16[2]{0} bitcast-convert(f32[] %input)

In alternativa, per B' > B l'istruzione richiede che l'ultima dimensione logica

della forma di input sia uguale a B'/B e questa dimensione viene eliminata durante

la conversione:

f32[10]{0} %output = f32[10]{0} bitcast-convert(f16[10,2]{1,0} %input)

Tieni presente che le conversioni tra larghezze di bit diverse non sono elementari.

Trasmissione

Vedi anche

XlaBuilder::Broadcast.

Aggiunge dimensioni a un array duplicando i dati al suo interno.

Broadcast(operand, broadcast_sizes)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

L'array da duplicare |

broadcast_sizes |

ArraySlice<int64> |

Le dimensioni delle nuove dimensioni |

Le nuove dimensioni vengono inserite a sinistra, ovvero se broadcast_sizes ha valori {a0, ..., aN} e la forma dell'operando ha dimensioni {b0, ..., bM}, la forma dell'output avrà dimensioni {a0, ..., aN, b0, ..., bM}.

Il nuovo indice delle dimensioni in copie dell'operando, ad esempio

output[i0, ..., iN, j0, ..., jM] = operand[j0, ..., jM]

Ad esempio, se operand è un valore scalare f32 con valore 2.0f e

broadcast_sizes è {2, 3}, il risultato sarà un array con forma

f32[2, 3] e tutti i valori del risultato saranno 2.0f.

BroadcastInDim

Vedi anche

XlaBuilder::BroadcastInDim.

Espande le dimensioni e il ranking di un array duplicando i dati al suo interno.

BroadcastInDim(operand, out_dim_size, broadcast_dimensions)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

L'array da duplicare |

out_dim_size |

ArraySlice<int64> |

Le dimensioni della forma di destinazione |

broadcast_dimensions |

ArraySlice<int64> |

A quale dimensione nella forma target corrisponde ciascuna dimensione della forma dell'operando |

Simile a Pubblico, ma consente di aggiungere dimensioni in qualsiasi punto ed espandere le dimensioni esistenti con dimensione 1.

Il operand viene trasmesso alla forma descritta da out_dim_size.

broadcast_dimensions mappa le dimensioni di operand alle dimensioni della forma di destinazione, ovvero la i-esima dimensione dell'operando viene mappata alla i-esima dimensione di broadcast_dimension[i] della forma di output. Le dimensioni di

operand devono avere dimensioni pari a 1 o essere uguali alle dimensioni della dimensione nella forma

di output a cui sono mappate. Le dimensioni rimanenti vengono completate con dimensioni di dimensione 1. La trasmissione con dimensioni degenerate viene quindi trasmessa lungo queste dimensioni degenerate per raggiungere la forma di output. La semantica è descritta in dettaglio nella pagina relativa alla trasmissione.

Chiama

Vedi anche

XlaBuilder::Call.

Richiama un calcolo con gli argomenti specificati.

Call(computation, args...)

| Argomenti | Tipo | Semantica |

|---|---|---|

computation |

XlaComputation |

calcolo del tipo T_0, T_1, ..., T_{N-1} -> S con N parametri di tipo arbitrario |

args |

sequenza di N XlaOp |

N argomenti di tipo arbitrario |

L'arietà e i tipi di args devono corrispondere ai parametri di

computation. Non è consentito avere args.

Cholesky

Vedi anche

XlaBuilder::Cholesky.

Calcola la decomposizione di Cholesky di un batch di matrici definite positive simmetriche (ermetiche).

Cholesky(a, lower)

| Argomenti | Tipo | Semantica |

|---|---|---|

a |

XlaOp |

Un array di rango > 2 di tipo complesso o con virgola mobile. |

lower |

bool |

se utilizzare il triangolo superiore o inferiore di a. |

Se lower è true, calcola le matrici triangolari inferiori l in modo che . Se lower è false, calcola le matrici triangolari superiori u come

.

I dati di input vengono letti solo dal triangolo inferiore/superiore di a, a seconda del

valore di lower. I valori dell'altro triangolo vengono ignorati. I dati di output vengono

resi nello stesso triangolo; i valori nell'altro triangolo sono

definiti dall'implementazione e possono essere qualsiasi.

Se il ranking di a è maggiore di 2, a viene considerato come un gruppo di matrici,

in cui tutte le dimensioni tranne le 2 secondarie sono dimensioni batch.

Se a non è simmetrico (ermitario) e definito positivo, il risultato è definito dall'implementazione.

Morsetto

Vedi anche

XlaBuilder::Clamp.

Applica un limite superiore e inferiore a un operando.

Clamp(min, operand, max)

| Argomenti | Tipo | Semantica |

|---|---|---|

min |

XlaOp |

array di tipo T |

operand |

XlaOp |

array di tipo T |

max |

XlaOp |

array di tipo T |

Dato un operando e i valori minimo e massimo, restituisce l'operando se rientra

nelll'intervallo compreso tra il minimo e il massimo, altrimenti restituisce il valore minimo se

l'operando è al di sotto di questo intervallo o il valore massimo se

l'operando è al di sopra di questo

intervallo. Vale a dire clamp(a, x, b) = min(max(a, x), b).

Tutti e tre gli array devono avere la stessa forma. In alternativa, come forma limitata di trasmissione, min e/o max possono essere scalari di tipo T.

Esempio con scalari min e max:

let operand: s32[3] = {-1, 5, 9};

let min: s32 = 0;

let max: s32 = 6;

==>

Clamp(min, operand, max) = s32[3]{0, 5, 6};

Comprimi

Vedi anche

XlaBuilder::Collapse

e l'operazione tf.reshape.

Comprimi le dimensioni di un array in una sola dimensione.

Collapse(operand, dimensions)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

array di tipo T |

dimensions |

Vettore int64 |

sottoinsieme consecutivo in ordine delle dimensioni di T. |

La funzione Collassa sostituisce il sottoinsieme specificato delle dimensioni dell'operando con una singola dimensione. Gli argomenti di input sono un array arbitrario di tipo T e un

vettore costante in fase di compilazione di indici di dimensione. Gli indici delle dimensioni devono essere

un sottoinsieme consecutivo di dimensioni T

in ordine (numeri di dimensione da bassi ad alti). Pertanto, {0, 1, 2}, {0, 1} o {1, 2} sono tutti insiemi di dimensioni validi, ma

{1, 0} o {0, 2} non lo sono. Vengono sostituite da un'unica nuova dimensione, nella

stessa posizione nella sequenza di dimensioni di quelle che sostituiscono, con la nuova

dimensione uguale a quella del prodotto delle dimensioni originali. Il numero di dimensione più basso in dimensions è la dimensione con variazioni più lente (più importante) nel nido di loop che comprime queste dimensioni, mentre il numero di dimensione più alto è la dimensione con variazioni più rapide (meno importante). Consulta l'operatore tf.reshape se è necessario un ordinamento più generale del collasso.

Ad esempio, definisci v come un array di 24 elementi:

let v = f32[4x2x3] { { {10, 11, 12}, {15, 16, 17} },

{ {20, 21, 22}, {25, 26, 27} },

{ {30, 31, 32}, {35, 36, 37} },

{ {40, 41, 42}, {45, 46, 47} } };

// Collapse to a single dimension, leaving one dimension.

let v012 = Collapse(v, {0,1,2});

then v012 == f32[24] {10, 11, 12, 15, 16, 17,

20, 21, 22, 25, 26, 27,

30, 31, 32, 35, 36, 37,

40, 41, 42, 45, 46, 47};

// Collapse the two lower dimensions, leaving two dimensions.

let v01 = Collapse(v, {0,1});

then v01 == f32[4x6] { {10, 11, 12, 15, 16, 17},

{20, 21, 22, 25, 26, 27},

{30, 31, 32, 35, 36, 37},

{40, 41, 42, 45, 46, 47} };

// Collapse the two higher dimensions, leaving two dimensions.

let v12 = Collapse(v, {1,2});

then v12 == f32[8x3] { {10, 11, 12},

{15, 16, 17},

{20, 21, 22},

{25, 26, 27},

{30, 31, 32},

{35, 36, 37},

{40, 41, 42},

{45, 46, 47} };

CollectivePermute

Vedi anche

XlaBuilder::CollectivePermute.

CollectivePermute è un'operazione collettiva che invia e riceve dati incrociati.

CollectivePermute(operand, source_target_pairs)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

Array di input di n dimensioni |

source_target_pairs |

Vettore <int64, int64> |

Un elenco di coppie (source_replica_id, target_replica_id). Per ogni coppia, l'operando viene inviato dalla replica di origine alla replica di destinazione. |

Tieni presente che esistono le seguenti limitazioni per source_target_pair:

- Qualsiasi coppia non deve avere lo stesso ID replica di destinazione e non deve avere lo stesso ID replica di origine.

- Se un ID replica non è un target in nessuna coppia, l'output su quella replica è un tensore costituito da 0(0) con la stessa forma dell'input.

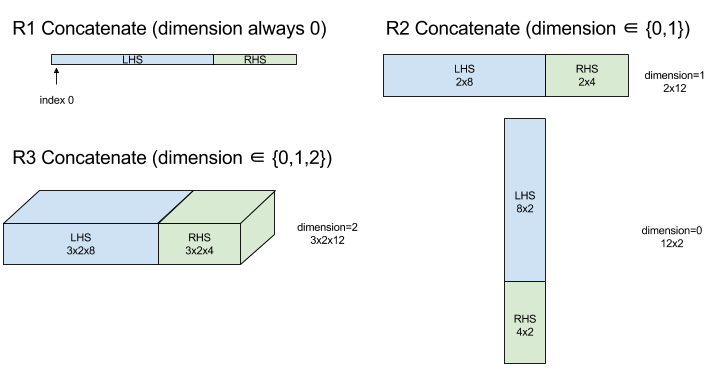

Concatena

Vedi anche

XlaBuilder::ConcatInDim.

Concatena crea un array da più operandi array. L'array ha lo stesso ranking di ciascuno degli operandi dell'array di input (che devono essere dello stesso ranking l'uno dell'altro) e contiene gli argomenti nell'ordine in cui sono stati specificati.

Concatenate(operands..., dimension)

| Argomenti | Tipo | Semantica |

|---|---|---|

operands |

sequenza di N XlaOp |

N matrici di tipo T con dimensioni [L0, L1, ...]. Richiede N >= 1. |

dimension |

int64 |

Un valore nell'intervallo [0, N) che assegna il nome alla dimensione da concatenare tra operands. |

Ad eccezione di dimension, tutte le dimensioni devono essere uguali. Questo accade perché XLA non supporta gli array "a maglie larghe". Tieni inoltre presente che i valori di rango 0

non possono essere concatenati (poiché è impossibile assegnare un nome alla dimensione in base alla quale avviene la concatenazione).

Esempio unidimensionale:

Concat({ {2, 3}, {4, 5}, {6, 7} }, 0)

>>> {2, 3, 4, 5, 6, 7}

Esempio 2D:

let a = {

{1, 2},

{3, 4},

{5, 6},

};

let b = {

{7, 8},

};

Concat({a, b}, 0)

>>> {

{1, 2},

{3, 4},

{5, 6},

{7, 8},

}

Diagramma:

Condizionale

Vedi anche

XlaBuilder::Conditional.

Conditional(pred, true_operand, true_computation, false_operand,

false_computation)

| Argomenti | Tipo | Semantica |

|---|---|---|

pred |

XlaOp |

Scalare di tipo PRED |

true_operand |

XlaOp |

Argomento di tipo |

true_computation |

XlaComputation |

XlaComputation di tipo |

false_operand |

XlaOp |

Argomento di tipo |

false_computation |

XlaComputation |

Calcolo Xla di tipo |

Esegue true_computation se pred è true, false_computation se pred

è false e restituisce il risultato.

true_computation deve accettare un singolo argomento di tipo e verrà invocato con true_operand, che deve essere dello stesso tipo. false_computation deve accettare un singolo argomento di tipo e verrà invocato con false_operand, che deve essere dello stesso tipo. Il tipo del valore restituito di true_computation e false_computation deve essere lo stesso.

Tieni presente che verrà eseguito solo uno tra true_computation e false_computation a seconda del valore di pred.

Conditional(branch_index, branch_computations, branch_operands)

| Argomenti | Tipo | Semantica |

|---|---|---|

branch_index |

XlaOp |

Scalare di tipo S32 |

branch_computations |

sequenza di N XlaComputation |

XlaComputations di tipo |

branch_operands |

sequenza di N XlaOp |

Argomenti di tipo |

Esegue branch_computations[branch_index] e restituisce il risultato. Se

branch_index è un S32 minore di 0 o maggiore o uguale a N, allora branch_computations[N-1]

viene eseguito come ramo predefinito.

Ogni branch_computations[b] deve accettare un singolo argomento di tipo e verrà invocato con branch_operands[b], che deve essere dello stesso tipo. Il

tipo del valore restituito di ogni branch_computations[b] deve essere lo stesso.

Tieni presente che verrà eseguita una sola delle branch_computations a seconda

del valore di branch_index.

Conv (convoluzione)

Vedi anche

XlaBuilder::Conv.

Come ConvWithGeneralPadding, ma il padding è specificato in modo abbreviato come SAME o VALID. Il padding UGUALE aggiunge zeri all'input (lhs) in modo che

l'output abbia la stessa forma dell'input se non si tiene conto del

passaggio. Il valore VALID padding indica semplicemente che non è presente alcun padding.

ConvWithGeneralPadding (convoluzione)

Vedi anche

XlaBuilder::ConvWithGeneralPadding.

Calcola una convezione del tipo utilizzato nelle reti neurali. Qui, una convoluzione può essere considerata come una finestra n-dimensionale che si sposta in un'area di base n-dimensionale e viene eseguito un calcolo per ogni posizione possibile della finestra.

| Argomenti | Tipo | Semantica |

|---|---|---|

lhs |

XlaOp |

array di input di rango n+2 |

rhs |

XlaOp |

array di rango n+2 di pesi del kernel |

window_strides |

ArraySlice<int64> |

array n-d di passi del kernel |

padding |

ArraySlice< pair<int64,int64>> |

Array n-dimensionale di spaziature interne (basso, alto) |

lhs_dilation |

ArraySlice<int64> |

Matrice del fattore di dilatazione n-d lhs |

rhs_dilation |

ArraySlice<int64> |

array del fattore di dilatazione n-d rhs |

feature_group_count |

int64 | il numero di gruppi di funzionalità |

batch_group_count |

int64 | il numero di gruppi batch |

Sia n il numero di dimensioni spaziali. L'argomento lhs è un array di rango n+2

che descrive l'area di base. Questo è chiamato input, anche se ovviamente anche il lato destro è un input. In una rete neurale, queste sono le attivazioni di input.

Le dimensioni n+2 sono, in questo ordine:

batch: ogni coordinata in questa dimensione rappresenta un input indipendente per il quale viene eseguita la convergenza.z/depth/features: a ogni posizione (y, x) nell'area di base è associato un vettore che viene inserito in questa dimensione.spatial_dims: descrive le dimensioni spazialinche definiscono l'area di base su cui si sposta la finestra.

L'argomento rhs è un array di rango n+2 che descrive il filtro/nucleo/finestra di convoluzione. Le dimensioni sono, in questo ordine:

output-z: la dimensionezdell'output.input-z: il valore di questa dimensione moltiplicato perfeature_group_countdeve essere uguale al valore della dimensionezin lhs.spatial_dims: descrive le dimensioni spazialinche definiscono la finestra n-d che si sposta sull'area di base.

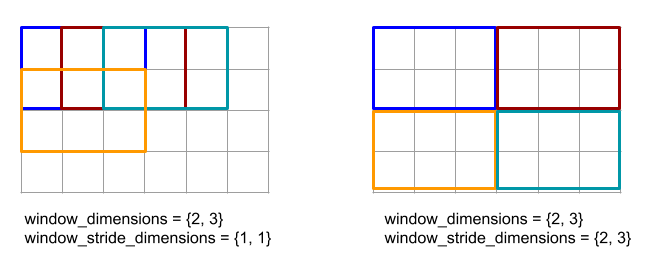

L'argomento window_strides specifica lo stride della finestra di convolvezione nelle dimensioni spaziali. Ad esempio, se lo stride nella prima dimensione spaziale è 3, la finestra può essere posizionata solo nelle coordinate in cui il primo indice spaziale è divisibile per 3.

L'argomento padding specifica la quantità di spaziatura interna pari a zero da applicare all'area di base. La quantità di spaziatura interna può essere negativa: il valore assoluto di spaziatura interna negativa indica il numero di elementi da rimuovere dalla dimensione specificata prima di eseguire la convoluzione. padding[0] specifica il padding per la dimensione y e padding[1] specifica il padding per la dimensione x. Ogni

coppia ha il padding basso come primo elemento e il padding alto come secondo

elemento. La spaziatura interna bassa viene applicata nella direzione degli indici inferiori, mentre la spaziatura interna alta viene applicata nella direzione degli indici più alti. Ad esempio, se padding[1] è (2,3), nella seconda dimensione spaziale verrà inserito un riempimento di 2 zeri a sinistra e di 3 zeri a destra. L'utilizzo della spaziatura interna equivale a inserire gli stessi valori zero nell'input (lhs) prima di eseguire la convoluzione.

Gli argomenti lhs_dilation e rhs_dilation specificano il fattore di dilatazione da applicare rispettivamente a lhs e rhs in ogni dimensione spaziale. Se il

coefficiente di dilatazione in una dimensione spaziale è d, tra ciascuna delle voci di quella dimensione vengono inseriti implicitamente d-1 spazi, aumentando le dimensioni dell' آرایه. I buchi vengono riempiti con un valore no-op, che per la convergenza significa zero.

La dilatazione del membro destro è chiamata anche convolvezione atrous. Per maggiori dettagli, consulta

tf.nn.atrous_conv2d. La dilatazione degli lhs è anche

detta convoluzione trasposta. Per maggiori dettagli, vedi tf.nn.conv2d_transpose.

L'argomento feature_group_count (valore predefinito 1) può essere utilizzato per le convoluzioni raggruppate. feature_group_count deve essere un divisore sia della dimensione della funzionalità di input sia di quella di output. Se feature_group_count è maggiore di 1, significa che concettualmente la dimensione delle funzionalità di input e di output e la dimensione delle funzionalità di output rhs sono suddivise equamente in molti gruppi feature_group_count, ciascuno costituito da una sottosezione consecutiva di funzionalità. La dimensione della funzionalità di input rhs deve essere uguale alla dimensione della funzionalità di input lhs divisa per feature_group_count (quindi ha già le dimensioni di un gruppo di funzionalità di input). I gruppi i vengono utilizzati insieme per calcolare

feature_group_count per molte convoluzioni separate. I risultati di queste convolute vengono concatenati nella dimensione della funzionalità di output.

Per la convoluzione in profondità, l'argomento feature_group_count verrebbe impostato sulla

dimensione della caratteristica di input e il filtro verrebbe rimodellato da

[filter_height, filter_width, in_channels, channel_multiplier] a

[filter_height, filter_width, 1, in_channels * channel_multiplier]. Per maggiori

dettagli, vedi tf.nn.depthwise_conv2d.

L'argomento batch_group_count (valore predefinito 1) può essere utilizzato per i filtri raggruppati durante la retropropagazione. batch_group_count deve essere un divisore della dimensione del batch lhs (input). Se batch_group_count è maggiore

di 1, significa che la dimensione del batch di output deve avere dimensioni input batch

/ batch_group_count. batch_group_count deve essere un divisore della dimensione della funzionalità di output.

La forma di output ha le seguenti dimensioni, in questo ordine:

batch: il valore di questa dimensione moltiplicato perbatch_group_countdeve essere uguale alle dimensioni della dimensionebatchin lhs.z: stessa dimensione dioutput-znel kernel (rhs).spatial_dims: un valore per ogni posizionamento valido della finestra convolzionale.

La figura sopra mostra come funziona il campo batch_group_count. In pratica, dividiamo ogni batch lhs in gruppi batch_group_count e facciamo lo stesso per le funzionalità di output. Poi, per ciascuno di questi gruppi, eseguiamo convezioni a coppie e concatenamo l'output lungo la dimensione della funzionalità di output. La semantica operativa di tutte le altre dimensioni (caratteristica e spaziale) rimane la stessa.

I posizionamenti validi della finestra convoluzionale sono determinati dalle strisce e dalle dimensioni della superficie di base dopo la spaziatura interna.

Per descrivere il funzionamento di una convoluzione, considera una convoluzione 2D e scegli alcune coordinate batch, z, y e x fisse nell'output. (y,x) rappresenta la posizione di un angolo della finestra all'interno della superficie di base (ad esempio, l'angolo in alto a sinistra, a seconda di come interpreti le dimensioni spaziali). Ora abbiamo una finestra 2D, presa dall'area di base, in cui ogni punto 2D è associato a un vettore 1D, quindi otteniamo una casella 3D. Dal kernel convoluzionale, dopo aver corretto

la coordinata di output z, abbiamo anche un riquadro 3D. Le due scatole hanno le stesse dimensioni, quindi possiamo prendere la somma dei prodotti elementari tra le due scatole (in modo simile a un prodotto scalare). Questo è il valore di output.

Tieni presente che se output-z è ad esempio 5, ogni posizione della finestra produce 5 valori nell'output nella dimensione z dell'output. Questi valori differiscono in base alla parte del kernel di convoluzione utilizzata: esiste una casella 3D separata di valori utilizzata per ogni coordinata output-z. Quindi puoi considerarlo come 5 convolute separate con un filtro diverso per ciascuna.

Ecco lo pseudo-codice per una convoluzione 2D con spaziatura interna e passo:

for (b, oz, oy, ox) { // output coordinates

value = 0;

for (iz, ky, kx) { // kernel coordinates and input z

iy = oy*stride_y + ky - pad_low_y;

ix = ox*stride_x + kx - pad_low_x;

if ((iy, ix) inside the base area considered without padding) {

value += input(b, iz, iy, ix) * kernel(oz, iz, ky, kx);

}

}

output(b, oz, oy, ox) = value;

}

ConvertElementType

Vedi anche

XlaBuilder::ConvertElementType.

Analogamente a un static_cast elemento per elemento in C++, esegue un'operazione di conversione elemento per elemento da una forma di dati a una forma di destinazione. Le dimensioni devono essere corrispondenti e la conversione deve essere basata sugli elementi; ad esempio, gli elementi s32 diventano elementi f32 tramite una routine di conversione da s32 a f32.

ConvertElementType(operand, new_element_type)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

array di tipo T con dimensioni D |

new_element_type |

PrimitiveType |

digita U |

Le dimensioni dell'operando e della forma di destinazione devono corrispondere. I tipi di elementi di origine e di destinazione non devono essere tuple.

Una conversione da T=s32 a U=f32 eseguirà una routine di conversione da intero a virgola mobile

come arrotondamento al più vicino alla situazione uguale.

let a: s32[3] = {0, 1, 2};

let b: f32[3] = convert(a, f32);

then b == f32[3]{0.0, 1.0, 2.0}

CrossReplicaSum

Esegue AllReduce con il calcolo della somma.

CustomCall

Vedi anche

XlaBuilder::CustomCall.

Chiama una funzione fornita dall'utente all'interno di un calcolo.

CustomCall(target_name, args..., shape)

| Argomenti | Tipo | Semantica |

|---|---|---|

target_name |

string |

Nome della funzione. Verrà emessa un'istruzione di chiamata che ha come target il nome del simbolo. |

args |

sequenza di N XlaOp |

N argomenti di tipo arbitrario, che verranno passati alla funzione. |

shape |

Shape |

Forma di output della funzione |

La firma della funzione è la stessa, indipendentemente dall'arità o dal tipo di argomenti:

extern "C" void target_name(void* out, void** in);

Ad esempio, se CustomCall viene utilizzata come segue:

let x = f32[2] {1,2};

let y = f32[2x3] { {10, 20, 30}, {40, 50, 60} };

CustomCall("myfunc", {x, y}, f32[3x3])

Ecco un esempio di implementazione di myfunc:

extern "C" void myfunc(void* out, void** in) {

float (&x)[2] = *static_cast<float(*)[2]>(in[0]);

float (&y)[2][3] = *static_cast<float(*)[2][3]>(in[1]);

EXPECT_EQ(1, x[0]);

EXPECT_EQ(2, x[1]);

EXPECT_EQ(10, y[0][0]);

EXPECT_EQ(20, y[0][1]);

EXPECT_EQ(30, y[0][2]);

EXPECT_EQ(40, y[1][0]);

EXPECT_EQ(50, y[1][1]);

EXPECT_EQ(60, y[1][2]);

float (&z)[3][3] = *static_cast<float(*)[3][3]>(out);

z[0][0] = x[1] + y[1][0];

// ...

}

La funzione fornita dall'utente non deve avere effetti collaterali e la sua esecuzione deve essere idempotente.

Punto

Vedi anche

XlaBuilder::Dot.

Dot(lhs, rhs)

| Argomenti | Tipo | Semantica |

|---|---|---|

lhs |

XlaOp |

array di tipo T |

rhs |

XlaOp |

array di tipo T |

La semantica esatta di questa operazione dipende dal rango degli operandi:

| Input | Output | Semantica |

|---|---|---|

vettore [n] dot vettore [n] |

scalare | prodotto scalare vettoriale |

matrice [m x k] dot vettore [k] |

vettore [m] | moltiplicazione matrice-vettore |

matrice [m x k] dot matrice [k x n] |

matrice [m x n] | moltiplicazione matrice-matrice |

L'operazione esegue la somma dei prodotti sulla seconda dimensione di lhs (o sulla prima se ha rango 1) e sulla prima dimensione di rhs. Si tratta delle dimensioni "contrattate". Le dimensioni contrattate di lhs e rhs devono essere

delle stesse dimensioni. In pratica, può essere utilizzato per eseguire prodotti scalari tra vettori, moltiplicazioni vettore/matrice o moltiplicazioni matrice/matrice.

DotGeneral

Vedi anche

XlaBuilder::DotGeneral.

DotGeneral(lhs, rhs, dimension_numbers)

| Argomenti | Tipo | Semantica |

|---|---|---|

lhs |

XlaOp |

array di tipo T |

rhs |

XlaOp |

array di tipo T |

dimension_numbers |

DotDimensionNumbers |

numeri di dimensione in batch e in contratti |

Simile a Dot, ma consente di specificare i numeri delle dimensioni di aggregazione e batch sia per lhs che per rhs.

| Campi DotDimensioneNumbers | Tipo | Semantica |

|---|---|---|

lhs_contracting_dimensions

|

int64 ripetuto | lhs numeri di dimensione

contrattante |

rhs_contracting_dimensions

|

int64 ripetuto | rhs numeri di dimensione

contrattante |

lhs_batch_dimensions

|

int64 ripetuto | lhs numeri di dimensioni batch |

rhs_batch_dimensions

|

int64 ripetuto | rhs numeri

delle dimensioni del lotto |

DotGeneral esegue la somma dei prodotti per le dimensioni di contratto specificate in

dimension_numbers.

I numeri di dimensione contraente associati da lhs e rhs non devono

essere uguali, ma devono avere le stesse dimensioni.

Esempio di numeri di dimensione contratta:

lhs = { {1.0, 2.0, 3.0},

{4.0, 5.0, 6.0} }

rhs = { {1.0, 1.0, 1.0},

{2.0, 2.0, 2.0} }

DotDimensionNumbers dnums;

dnums.add_lhs_contracting_dimensions(1);

dnums.add_rhs_contracting_dimensions(1);

DotGeneral(lhs, rhs, dnums) -> { {6.0, 12.0},

{15.0, 30.0} }

I numeri delle dimensioni del batch associate di lhs e rhs devono avere le stesse dimensioni.

Esempio con numeri di dimensione del lotto (dimensione del lotto 2, matrici 2x2):

lhs = { { {1.0, 2.0},

{3.0, 4.0} },

{ {5.0, 6.0},

{7.0, 8.0} } }

rhs = { { {1.0, 0.0},

{0.0, 1.0} },

{ {1.0, 0.0},

{0.0, 1.0} } }

DotDimensionNumbers dnums;

dnums.add_lhs_contracting_dimensions(2);

dnums.add_rhs_contracting_dimensions(1);

dnums.add_lhs_batch_dimensions(0);

dnums.add_rhs_batch_dimensions(0);

DotGeneral(lhs, rhs, dnums) -> { { {1.0, 2.0},

{3.0, 4.0} },

{ {5.0, 6.0},

{7.0, 8.0} } }

| Input | Output | Semantica |

|---|---|---|

[b0, m, k] dot [b0, k, n] |

[b0, m, n] | matmul batch |

[b0, b1, m, k] dot [b0, b1, k, n] |

[b0, b1, m, n] | batch batch |

Ne consegue che il numero della dimensione risultante inizia con la dimensione batch, poi con la dimensione lhs non contrattuale/non batch e infine con la dimensione rhs

non contrattuale/non batch.

DynamicSlice

Vedi anche

XlaBuilder::DynamicSlice.

DynamicSlice estrae un sottoarray dall'array di input in corrispondenza di start_indices dinamico. La dimensione del segmento in ogni dimensione viene passata in

size_indices, che specifica il punto di fine degli intervalli di segmenti esclusivi in ogni

dimensione: [start, start + size). La forma di start_indices deve avere un rango ==

1, con una dimensione pari al rango di operand.

DynamicSlice(operand, start_indices, size_indices)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

Matrice dimensionale N di tipo T |

start_indices |

sequenza di N XlaOp |

Elenco di N numeri interi scalari contenenti gli indici iniziali del sezionamento per ogni dimensione. Il valore deve essere maggiore o uguale a zero. |

size_indices |

ArraySlice<int64> |

Elenco di N numeri interi contenenti le dimensioni della sezione per ogni dimensione. Ogni valore deve essere strettamente maggiore di zero e start + size deve essere inferiore o uguale alla dimensione della dimensione per evitare il wrapping modulo la dimensione della dimensione. |

Gli indici di taglio effettivi vengono calcolati applicando la seguente trasformazione per ogni indice i in [1, N) prima di eseguire il taglio:

start_indices[i] = clamp(start_indices[i], 0, operand.dimension_size[i] - size_indices[i])

In questo modo, il segmento estratto è sempre in ambito rispetto all'array di operandi. Se il segmento è in-bounds prima dell'applicazione della trasformazione, la trasformazione non ha alcun effetto.

Esempio unidimensionale:

let a = {0.0, 1.0, 2.0, 3.0, 4.0}

let s = {2}

DynamicSlice(a, s, {2}) produces:

{2.0, 3.0}

Esempio 2D:

let b =

{ {0.0, 1.0, 2.0},

{3.0, 4.0, 5.0},

{6.0, 7.0, 8.0},

{9.0, 10.0, 11.0} }

let s = {2, 1}

DynamicSlice(b, s, {2, 2}) produces:

{ { 7.0, 8.0},

{10.0, 11.0} }

DynamicUpdateSlice

Vedi anche

XlaBuilder::DynamicUpdateSlice.

DynamicUpdateSlice genera un risultato che corrisponde al valore dell'array di input operand, con una sezione update sovrascritta in start_indices.

La forma di update determina la forma del sottoarray del risultato che viene aggiornato.

La forma di start_indices deve avere ranking == 1, con dimensioni della dimensione uguali

al ranking di operand.

DynamicUpdateSlice(operand, update, start_indices)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

Matrice dimensionale N di tipo T |

update |

XlaOp |

Array N dimensionale di tipo T contenente l'aggiornamento della frazione. Ogni dimensione della forma dell'aggiornamento deve essere strettamente maggiore di zero e inizio + aggiornamento deve essere minore o uguale alla dimensione dell'operando per ogni dimensione per evitare di generare indici di aggiornamento fuori intervallo. |

start_indices |

sequenza di N XlaOp |

Elenco di N numeri interi scalari contenenti gli indici iniziali della sezione per ogni dimensione. Il valore deve essere maggiore o uguale a zero. |

Gli indici di taglio effettivi vengono calcolati applicando la seguente trasformazione per ogni indice i in [1, N) prima di eseguire il taglio:

start_indices[i] = clamp(start_indices[i], 0, operand.dimension_size[i] - update.dimension_size[i])

In questo modo, il segmento aggiornato è sempre in ambito rispetto all'array di operandi. Se il segmento è in-bounds prima dell'applicazione della trasformazione, la trasformazione non ha alcun effetto.

Esempio unidimensionale:

let a = {0.0, 1.0, 2.0, 3.0, 4.0}

let u = {5.0, 6.0}

let s = {2}

DynamicUpdateSlice(a, u, s) produces:

{0.0, 1.0, 5.0, 6.0, 4.0}

Esempio bidimensionale:

let b =

{ {0.0, 1.0, 2.0},

{3.0, 4.0, 5.0},

{6.0, 7.0, 8.0},

{9.0, 10.0, 11.0} }

let u =

{ {12.0, 13.0},

{14.0, 15.0},

{16.0, 17.0} }

let s = {1, 1}

DynamicUpdateSlice(b, u, s) produces:

{ {0.0, 1.0, 2.0},

{3.0, 12.0, 13.0},

{6.0, 14.0, 15.0},

{9.0, 16.0, 17.0} }

Operazioni aritmetiche binarie a livello di elementi

Vedi anche

XlaBuilder::Add.

È supportato un insieme di operazioni aritmetiche binarie a livello di elementi.

Op(lhs, rhs)

dove Op è uno dei seguenti valori: Add (addizione), Sub (sottrazione), Mul

(moltiplicazione), Div (divisione), Pow (potenza), Rem (residuo), Max

(massimo), Min (minimo), And (AND logico), Or (OR logico), Xor (XOR logico), ShiftLeft (Spostamento a sinistra),

ShiftRightArithmetic (Spostamento a destra aritmetico), ShiftRightLogical (Spostamento a destra

logico), Atan2 (arcotangente a 2 argomenti) o Complex (combina le parti reali e imaginary in un numero complesso)

| Argomenti | Tipo | Semantica |

|---|---|---|

lhs |

XlaOp |

operando sinistro: array di tipo T |

rhs |

XlaOp |

operando sul lato destro: array di tipo T |

Le forme degli argomenti devono essere simili o compatibili. Consulta la documentazione relativa alla trasmissione per sapere cosa significa che le forme siano compatibili. Il risultato di un'operazione ha una forma che è il risultato della trasmissione dei due array di input. In questa variante, le operazioni tra array di livelli diversi non sono supportate, a meno che uno degli operandi non sia uno scalare.

Quando Op è Rem, il segno del risultato viene dedotto dal dividendo e il

valore assoluto del risultato è sempre inferiore al valore assoluto del divisore.

Il overflow della divisione di interi (divisione/resto con segno/senza segno per zero o divisione/resto con segno di INT_SMIN con -1) produce un valore definito dall'implementazione.

Esiste una variante alternativa con supporto della trasmissione di ranking diverso per queste operazioni:

Op(lhs, rhs, broadcast_dimensions)

dove Op è lo stesso valore indicato sopra. Questa variante dell'operazione deve essere utilizzata per le operazioni aritmetiche tra array di ranghi diversi (ad esempio l'aggiunta di una matrice a un vettore).

L'operando broadcast_dimensions aggiuntivo è un segmento di numeri interi utilizzato per

espandere il rango dell'operando di rango inferiore fino al rango dell'operando di rango superiore. broadcast_dimensions mappa le dimensioni della forma di rango inferiore alle dimensioni della forma di rango superiore. Le dimensioni non mappate della forma espansa vengono completate con dimensioni di dimensione 1. La trasmissione delle dimensioni degenerate

quindi trasmette le forme lungo queste dimensioni degenerate per equalizzare

le forme di entrambi gli operandi. La semantica è descritta in dettaglio nella

pagina relativa alla trasmissione.

Operazioni di confronto elemento per elemento

Vedi anche

XlaBuilder::Eq.

È supportato un insieme di operazioni di confronto binario elementari standard. Tieni presente che la semantica del confronto in virgola mobile standard IEEE 754 viene applicata quando si confrontano i tipi con virgola mobile.

Op(lhs, rhs)

Dove Op è uno di Eq (uguale a), Ne (non uguale a), Ge

(maggiore o uguale a), Gt (maggiore di), Le (minore o uguale a), Lt

(minore di). Un altro insieme di operatori, EqTotalOrder, NeTotalOrder, GeTotalOrder,

GtTotalOrder, LeTotalOrder e LtTotalOrder, fornisce le stesse funzionalità,

ma supportano in aggiunta un ordine totale rispetto ai numeri in virgola mobile,

applicando -NaN < -Inf < -Finite < -0 < +0 < +Finite < +NaNInf.

| Argomenti | Tipo | Semantica |

|---|---|---|

lhs |

XlaOp |

operando sinistro: array di tipo T |

rhs |

XlaOp |

operando sul lato destro: array di tipo T |

Le forme degli argomenti devono essere simili o compatibili. Consulta la documentazione sulla trasmissione per scoprire cosa significa la compatibilità delle forme. Il risultato di un'operazione ha una forma che è il risultato della trasmissione dei due array di input con il tipo di elemento PRED. In questa variante,

le operazioni tra array di ranghi diversi non sono supportate, a meno che uno degli

operandi non sia uno scalare.

Esiste una variante alternativa con supporto della trasmissione di ranking diverso per queste operazioni:

Op(lhs, rhs, broadcast_dimensions)

dove Op è lo stesso valore indicato sopra. Questa variante dell'operazione deve essere utilizzata per le operazioni di confronto tra array di ranghi diversi (ad esempio l'aggiunta di una matrice a un vettore).

L'operando broadcast_dimensions aggiuntivo è un segmento di numeri interi che specifica

le dimensioni da utilizzare per la trasmissione degli operandi. La semantica è descritta in dettaglio nella pagina relativa alla trasmissione.

Funzioni unarie elementari

XlaBuilder supporta le seguenti funzioni unarie elementari:

Abs(operand) Assoluto elemento per elemento x -> |x|.

Cbrt(operand) Operazione di radice cubica elemento per elemento x -> cbrt(x).

Ceil(operand) Ceilo elemento per elemento x -> ⌈x⌉.

Clz(operand) Conta i zeri iniziali elemento per elemento.

Cos(operand) Coseno elemento per elemento x -> cos(x).

Erf(operand) Funzione di errore elemento per elemento x -> erf(x) dove

.

Exp(operand) Esponenziale naturale elemento per elemento x -> e^x.

Expm1(operand) Esponenziale naturale elemento per elemento meno uno x -> e^x - 1.

Floor(operand) Valore minimo per elemento x -> ⌊x⌋.

Imag(operand) Parte immaginaria basata sugli elementi di una forma complessa (o reale). x -> imag(x). Se l'operando è di tipo a virgola mobile, restituisce 0.

IsFinite(operand) Verifica se ogni elemento di operand è finito,

ovvero non è infinito positivo o negativo e non è NaN. Restituisce un array

di valori PRED con la stessa forma dell'input, dove ogni elemento è true

se e solo se l'elemento di input corrispondente è finito.

Log(operand) Logaritmo naturale elemento per elemento x -> ln(x).

Log1p(operand) Logaritmo naturale spostato per elemento x -> ln(1+x).

Logistic(operand) Calcolo della funzione logistica elemento per elemento x ->

logistic(x).

Neg(operand) Negazione elemento per elemento x -> -x.

Not(operand) Logica a livello di elemento non x -> !(x).

PopulationCount(operand) Calcola il numero di bit impostati in ogni

elemento di operand.

Real(operand) Parte reale elemento per elemento di una forma complessa (o reale).

x -> real(x). Se l'operando è di tipo a virgola mobile, restituisce lo stesso valore.

Round(operand) Arrotondamento elemento per elemento, i valori uguali a zero vengono ignorati.

RoundNearestEven(operand) Arrotondamento elemento per elemento, con arrotondamento al numero pari più vicino.

Rsqrt(operand) Reciproco elemento per elemento dell'operazione di radice quadrata

x -> 1.0 / sqrt(x).

Sign(operand) Operazione di firma a livello di elemento x -> sgn(x) in cui

utilizzando l'operatore di confronto del tipo di elemento operand.

Sin(operand) Seno elemento per elemento x -> sin(x).

Sqrt(operand) Operazione di radice quadrata elemento per elemento x -> sqrt(x).

Tan(operand) Tangente x -> tan(x) rispetto all'elemento.

Tanh(operand) Tangente iperbolica basata sull'elemento x -> tanh(x).

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

L'operando alla funzione |

La funzione viene applicata a ciascun elemento nell'array operand, generando un array con la stessa forma. operand può essere uno scalare (ranking 0) consentito.

Fft

L'operazione FFT XLA implementa le trasformazioni di Fourier dirette e inverse per input/output reali e complessi. Sono supportati gli FFT multidimensionali su un massimo di 3 assi.

Vedi anche

XlaBuilder::Fft.

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

L'array di cui stiamo calcolando la trasformata di Fourier. |

fft_type |

FftType |

Consulta la tabella riportata di seguito. |

fft_length |

ArraySlice<int64> |

Le lunghezze nel dominio del tempo degli assi in fase di trasformazione. Questo è necessario in particolare per l'IRFFT per ridimensionare correttamente l'asse più interno, poiché RFFT(fft_length=[16]) ha la stessa forma di output di RFFT(fft_length=[17]). |

FftType |

Semantica |

|---|---|

FFT |

Inoltra FFT da complessi a complessi. La forma non cambia. |

IFFT |

FFT inverso da complesso a complesso. La forma non cambia. |

RFFT |

Inoltra FFT da reale a complesso. La forma dell'asse più interno viene ridotta a fft_length[-1] // 2 + 1 se fft_length[-1] è un valore diverso da zero, omettendo la parte coniugata inversa del segnale trasformato oltre la frequenza di Nyquist. |

IRFFT |

FFT inverso da reale a complesso (ovvero richiede un insieme di dati complessi e restituisce il valore reale). La forma dell'asse più interno viene espansa a fft_length[-1] se fft_length[-1] è un valore diverso da zero, deducendo la parte del segnale trasformato oltre la frequenza di Nyquist dalla coniugata inversa delle voci 1 a fft_length[-1] // 2 + 1. |

FFT multidimensionale

Se viene fornito più di un fft_length, è equivalente all'applicazione di una cascata di operazioni FFT a ciascuno degli assi più interni. Tieni presente che per i casi reale->complesso e complesso->reale, la trasformazione dell'asse più interno viene eseguita (in modo efficace) per prima (RFFT; per ultima per IRFFT), motivo per cui è l'asse più interno a cambiare dimensione. Le altre trasformazioni degli assi saranno quindi

complesso->complesso.

Dettagli di implementazione

L'FFT della CPU è supportato da TensorFFT di Eigen. FFT GPU utilizza cuFFT.

Raccogliere

La XLA riunisce le operazioni di stitching di diverse sezioni (ciascuna sezione con un offset di runtime potenzialmente diverso) di un array di input.

Semantica generale

Vedi anche

XlaBuilder::Gather.

Per una descrizione più intuitiva, consulta la sezione "Descrizione informale" di seguito.

gather(operand, start_indices, offset_dims, collapsed_slice_dims, slice_sizes, start_index_map)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

L'array da cui stiamo raccogliendo i dati. |

start_indices |

XlaOp |

Array contenente gli indici iniziali delle sezioni raccolte. |

index_vector_dim |

int64 |

La dimensione in start_indices che "contiene" gli indici iniziali. Di seguito è riportata una descrizione dettagliata. |

offset_dims |

ArraySlice<int64> |

L'insieme di dimensioni nella forma di output che eseguono l'offset in una matrice suddivisa in base all'operando. |

slice_sizes |

ArraySlice<int64> |

slice_sizes[i] sono i limiti della sezione nella dimensione i. |

collapsed_slice_dims |

ArraySlice<int64> |

L'insieme di dimensioni in ogni frazione che vengono compresse. Queste dimensioni devono avere dimensioni pari a 1. |

start_index_map |

ArraySlice<int64> |

Una mappa che descrive come mappare gli indici in start_indices agli indici legali nell'operando. |

indices_are_sorted |

bool |

Indica se è garantito che gli indici siano ordinati dal chiamante. |

Per praticità, etichettiamo le dimensioni nell'array di output non in offset_dims

come batch_dims.

L'output è un array di ranking batch_dims.size + offset_dims.size.

operand.rank deve essere uguale alla somma di offset_dims.size e

collapsed_slice_dims.size. Inoltre, slice_sizes.size deve essere uguale a

operand.rank.

Se index_vector_dim è uguale a start_indices.rank, consideriamo implicitamente

start_indices una dimensione 1 finale (ad es. se start_indices era di

forma [6,7] e index_vector_dim è 2, consideriamo implicitamente

la forma di start_indices come [6,7,1]).

I limiti per l'array di output lungo la dimensione i vengono calcolati come segue:

Se

iè presente inbatch_dims(ovvero è uguale abatch_dims[k]per alcunik), scegliamo i limiti delle dimensioni corrispondenti trastart_indices.shape, saltandoindex_vector_dim(ad es. sceglistart_indices.shape.dims[k] sek<index_vector_dimestart_indices.shape.dims[k+1] in caso contrario).Se

iè presente inoffset_dims(ovvero è uguale aoffset_dims[k] per qualchek), selezioniamo il limite corrispondente daslice_sizesdopo aver tenuto conto dicollapsed_slice_dims(ovvero selezioniamoadjusted_slice_sizes[k] doveadjusted_slice_sizesèslice_sizescon i limiti agli indicicollapsed_slice_dimsrimossi).

Formalmente, l'indice dell'operando In corrispondente a un determinato indice di output Out viene calcolato come segue:

Sia

G= {Out[k] perkinbatch_dims}. UtilizzaGper suddividere un vettoreSin modo tale cheS[i] =start_indices[Combina(G,i)] dove Combina(A, b) inserisce b nella posizioneindex_vector_dimin A. Tieni presente che questo è ben definito anche seGè vuoto: seGè vuoto,S=start_indices.Crea un indice iniziale,

Sin, inoperandutilizzandoSdistribuendoStramitestart_index_map. Più precisamente:Sin[start_index_map[k]] =S[k] sek<start_index_map.size.Sin[_] =0in caso contrario.

Crea un indice

Oininoperanddistribuendo gli indici nelle dimensioni di offset inOutin base all'insiemecollapsed_slice_dims. Più nello specifico:Oin[remapped_offset_dims(k)] =Out[offset_dims[k]] sek<offset_dims.size(remapped_offset_dimsè definito di seguito).Oin[_] =0in caso contrario.

InèOin+Sin, dove + rappresenta l'aggiunta di elementi.

remapped_offset_dims è una funzione monotona con dominio [0,

offset_dims.size) e intervallo [0, operand.rank) \ collapsed_slice_dims. Pertanto,

se ad esempio offset_dims.size è 4, operand.rank è 6 e

collapsed_slice_dims è {0, 2} quindi remapped_offset_dims è {0→1,

1→3, 2→4, 3→5}.

Se indices_are_sorted è impostato su true, XLA può assumere che start_indices

siano ordinati (in ordine crescente, dopo aver sparso i relativi valori in base a

start_index_map) dall'utente. In caso contrario, la semantica

viene definita per l'implementazione.

Descrizione informale ed esempi

In modo informale, ogni indice Out nell'array di output corrisponde a un elemento E

nell'array dell'operando, calcolato come segue:

Utilizziamo le dimensioni batch in

Outper cercare un indice iniziale a partire dastart_indices.Utilizziamo

start_index_mapper mappare l'indice iniziale (la cui dimensione può essere inferiore a operand.rank) a un indice iniziale "completo" inoperand.Dividiamo dinamicamente un segmento con dimensioni

slice_sizesutilizzando l'indice iniziale completo.Rimodelniamo la sezione comprimindo le dimensioni

collapsed_slice_dims. Poiché tutte le dimensioni degli slice compressi devono avere un limite di 1, questa trasformazione è sempre valida.Utilizziamo le dimensioni di offset in

Outper indicizzare questa sezione in modo da ottenere l'elemento di input,E, corrispondente all'indice di outputOut.

Il valore index_vector_dim è impostato su start_indices.rank - 1 in tutti gli esempi

che seguono. I valori più interessanti per index_vector_dim non modificano sostanzialmente l'operazione, ma rendono la rappresentazione visiva più complicata.

Per capire meglio come si combinano tutti gli elementi precedenti, diamo un'occhiata a un

esempio che raccoglie 5 slice di forma [8,6] da un array [16,11]. La

posizione di un segmento nell'array [16,11] può essere rappresentata come un vettore di indice di forma S64[2], pertanto l'insieme di 5 posizioni può essere rappresentato come un

S64[5,2] array.

Il comportamento dell'operazione di collect può quindi essere rappresentato come una trasformazione dell'indice che prende [G,O0,O1], un indice nella forma di output, e lo mappa a un elemento nell'array di input nel seguente modo:

Per prima cosa selezioniamo un vettore (X,Y) dall'array di indici di raccolta utilizzando G.

L'elemento nell'array di output all'indice

[G,O0,O1] è quindi l'elemento nell'array di input

all'indice [X+O0,Y+O1].

slice_sizes è [8,6], che stabilisce l'intervallo di O0 e

O1 e questo determina a sua volta i limiti della sezione.

Questa operazione di raccolta agisce come una sezione dinamica batch con G come dimensione

batch.

Gli indici di aggregazione possono essere multidimensionali. Ad esempio, una versione più generale

dell'esempio precedente che utilizza un array di "indici di aggregazione" di forma [4,5,2]

tradurrebbe gli indici come segue:

Anche in questo caso, si tratta di un segmento dinamico del batch G0 e

G1 come dimensioni del batch. La dimensione del segmento rimane [8,6].

L'operazione di aggregazione in XLA generalizza la semantica informale descritta sopra nel seguente modo:

Possiamo configurare le dimensioni della forma di output che sono le dimensioni di offset (le dimensioni contenenti

O0,O1nell'ultimo esempio). Le dimensioni del batch di output (le dimensioni contenentiG0,G1nell'ultimo esempio) sono definite come le dimensioni di output che non sono dimensioni di offset.Il numero di dimensioni di offset dell'output esplicitamente presenti nella forma di output potrebbe essere inferiore al rango dell'input. Queste dimensioni "mancanti", elencate esplicitamente come

collapsed_slice_dims, devono avere una dimensione del segmento di1. Poiché hanno una dimensione di slice pari a1, l'unico indice valido per loro è0e l'elisione non introduce ambiguità.Il segmento estratto dall'array "Indici di aggregazione" ((

X,Y) nell'ultimo esempio) può avere meno elementi rispetto al ranking dell'array di input e una mappatura esplicita determina come deve essere espanso l'indice per avere lo stesso ranking dell'input.

Come ultimo esempio, utilizziamo i numeri (2) e (3) per implementare tf.gather_nd:

G0 e G1 vengono utilizzati per estrarre un indice iniziale dall'array di indici di aggregazione come di consueto, tranne per il fatto che l'indice iniziale ha un solo elemento, X. Analogamente, esiste un solo indice di offset di output con il valore

O0. start_index_mapremapped_offset_dimsXX000000000OOOOGGGG11GatherIndicestf.gather_nd

slice_sizes per questa richiesta è [1,11]. Intuitivamente, questo significa che ogni indice X nell'array di indici di aggregazione seleziona un'intera riga e il risultato è la concatenazione di tutte queste righe.

GetDimensionSize

Vedi anche

XlaBuilder::GetDimensionSize.

Restituisce la dimensione della dimensione specificata dell'operando. L'operando deve avere la forma di un array.

GetDimensionSize(operand, dimension)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

Array di input di n dimensioni |

dimension |

int64 |

Un valore nell'intervallo [0, n) che specifica la dimensione |

SetDimensionSize

Vedi anche

XlaBuilder::SetDimensionSize.

Imposta la dimensione dinamica della dimensione specificata di XlaOp. L'operando deve avere la forma di un array.

SetDimensionSize(operand, size, dimension)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

Array di input n-dimensionale. |

size |

XlaOp |

int32 che rappresenta la dimensione dinamica di runtime. |

dimension |

int64 |

Un valore nell'intervallo [0, n) che specifica la dimensione. |

Passa attraverso l'operando come risultato, con la dimensione dinamica monitorata dal compilatore.

I valori con spaziatura interna verranno ignorati dalle operazioni di riduzione a valle.

let v: f32[10] = f32[10]{1, 2, 3, 4, 5, 6, 7, 8, 9, 10};

let five: s32 = 5;

let six: s32 = 6;

// Setting dynamic dimension size doesn't change the upper bound of the static

// shape.

let padded_v_five: f32[10] = set_dimension_size(v, five, /*dimension=*/0);

let padded_v_six: f32[10] = set_dimension_size(v, six, /*dimension=*/0);

// sum == 1 + 2 + 3 + 4 + 5

let sum:f32[] = reduce_sum(padded_v_five);

// product == 1 * 2 * 3 * 4 * 5

let product:f32[] = reduce_product(padded_v_five);

// Changing padding size will yield different result.

// sum == 1 + 2 + 3 + 4 + 5 + 6

let sum:f32[] = reduce_sum(padded_v_six);

GetTupleElement

Vedi anche

XlaBuilder::GetTupleElement.

Indici in una tupla con un valore costante di tempo di compilazione.

Il valore deve essere una costante di compilazione affinché l'inferenza della forma possa determinare il tipo del valore risultante.

È analogo a std::get<int N>(t) in C++. Concettualmente:

let v: f32[10] = f32[10]{0, 1, 2, 3, 4, 5, 6, 7, 8, 9};

let s: s32 = 5;

let t: (f32[10], s32) = tuple(v, s);

let element_1: s32 = gettupleelement(t, 1); // Inferred shape matches s32.

Vedi anche tf.tuple.

Infeed

Vedi anche

XlaBuilder::Infeed.

Infeed(shape)

| Argomento | Tipo | Semantica |

|---|---|---|

shape |

Shape |

Forma dei dati letti dall'interfaccia Infeed. Il campo del layout della forma deve essere impostato in modo da corrispondere al layout dei dati inviati al dispositivo; in caso contrario, il comportamento non è definito. |

Legge un singolo elemento di dati dall'interfaccia di streaming infeed implicita del

dispositivo, interpretando i dati come la forma e il layout specificati e restituisce un

XlaOp di dati. In un calcolo sono consentite più operazioni infeed, ma deve essere presente un ordine totale tra le operazioni infeed. Ad esempio, due infeed nel codice di seguito hanno un ordine totale poiché esiste una dipendenza tra i loop while.

result1 = while (condition, init = init_value) {

Infeed(shape)

}

result2 = while (condition, init = result1) {

Infeed(shape)

}

Le forme di tuple nidificate non sono supportate. Per una forma di tupla vuota, l'operazione Infeed è in pratica un'operazione no-op e procede senza leggere alcun dato dall'infeed del dispositivo.

Iota

Vedi anche

XlaBuilder::Iota.

Iota(shape, iota_dimension)

Consente di creare una costante letterale sul dispositivo anziché un trasferimento dell'host potenzialmente di grandi dimensioni. Crea un array con una forma specificata e contiene valori che iniziano da zero e aumentano di uno lungo la dimensione specificata. Per i tipi con virgola mobile, l'array generato è equivalente a ConvertElementType(Iota(...)), dove Iota è di tipo integrale e la conversione è di tipo in virgola mobile.

| Argomenti | Tipo | Semantica |

|---|---|---|

shape |

Shape |

Forma dell'array creata da Iota() |

iota_dimension |

int64 |

La dimensione da incrementare. |

Ad esempio, Iota(s32[4, 8], 0) restituisce

[[0, 0, 0, 0, 0, 0, 0, 0 ],

[1, 1, 1, 1, 1, 1, 1, 1 ],

[2, 2, 2, 2, 2, 2, 2, 2 ],

[3, 3, 3, 3, 3, 3, 3, 3 ]]

Resi a Iota(s32[4, 8], 1)

[[0, 1, 2, 3, 4, 5, 6, 7 ],

[0, 1, 2, 3, 4, 5, 6, 7 ],

[0, 1, 2, 3, 4, 5, 6, 7 ],

[0, 1, 2, 3, 4, 5, 6, 7 ]]

Mappa

Vedi anche

XlaBuilder::Map.

Map(operands..., computation)

| Argomenti | Tipo | Semantica |

|---|---|---|

operands |

sequenza di N XlaOp s |

N array di tipo T0..T{N-1} |

computation |

XlaComputation |

calcolo di tipo T_0, T_1, .., T_{N + M -1} -> S con N parametri di tipo T e M di tipo arbitrario |

dimensions |

Array int64 |

array di dimensioni della mappa |

Applica una funzione scalare sugli array operands specificati, producendo un array delle stesse dimensioni in cui ogni elemento è il risultato della funzione mappata applicata agli elementi corrispondenti negli array di input.

La funzione mappata è un calcolo arbitrario con la limitazione di avere

N input di tipo scalare T e un singolo output di tipo S. L'output ha le stesse dimensioni degli operandi, tranne per il fatto che il tipo di elemento T viene sostituito con S.

Ad esempio: Map(op1, op2, op3, computation, par1) mappa elem_out <-

computation(elem1, elem2, elem3, par1) a ciascun indice (multidimensionale) negli array di input per produrre l'array di output.

OptimizationBarrier

Impedisce a qualsiasi passaggio di ottimizzazione di spostare i calcoli oltre la barriera.

Garantisce che tutti gli input vengano valutati prima di qualsiasi operatore che dipende dagli output della barriera.

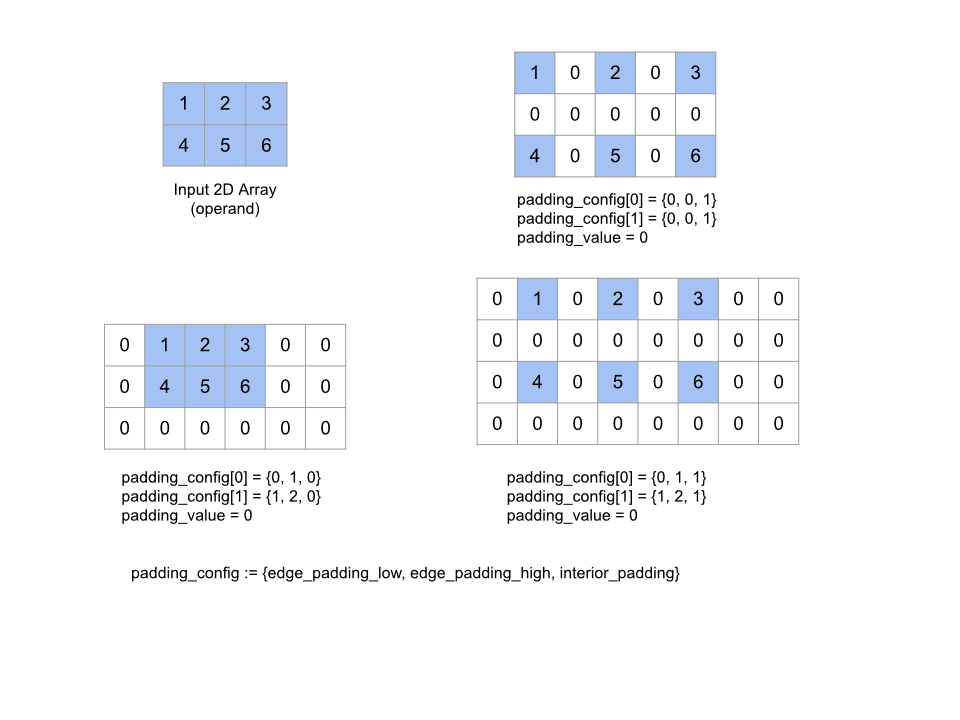

Cuscinetto

Vedi anche

XlaBuilder::Pad.

Pad(operand, padding_value, padding_config)

| Argomenti | Tipo | Semantica |

|---|---|---|

operand |

XlaOp |

array di tipo T |

padding_value |

XlaOp |

scalare di tipo T per riempire la spaziatura interna aggiunta |

padding_config |

PaddingConfig |

La quantità di spaziatura interna su entrambi i lati (basso, alto) e tra gli elementi di ogni dimensione |

Espande l'array operand specificato inserendo spaziatura interna intorno all'array e tra gli elementi dell'array con il valore padding_value specificato. padding_config

specifica la quantità di spaziatura interna e interna per ogni

dimensione.

PaddingConfig è un campo ripetuto di PaddingConfigDimension, che contiene tre campi per ogni dimensione: edge_padding_low, edge_padding_high e interior_padding.

edge_padding_low e edge_padding_high specificano la quantità di spaziatura interna aggiunta rispettivamente all'estremità inferiore (accanto all'indice 0) e all'estremità superiore (accanto all'indice più alto) di ogni dimensione. La quantità di spaziatura interna può essere negativa: il valore assoluto della spaziatura interna negativa indica il numero di elementi da rimuovere dalla dimensione specificata.

interior_padding specifica la quantità di spaziatura interna aggiunta tra due elementi in ogni dimensione. Non può essere negativo. Il padding interno avviene

logicamente prima del padding dei bordi, pertanto, nel caso di padding dei bordi negativo, gli elementi

vengono rimossi dall'operando con padding interno.

Questa operazione non esegue alcuna operazione se tutte le coppie di spaziatura interna sono (0, 0) e tutti i valori di spaziatura interna sono 0. La figura seguente mostra esempi di valori diversi di edge_padding e interior_padding per un array bidimensionale.

Recv

Vedi anche

XlaBuilder::Recv.

Recv(shape, channel_handle)

| Argomenti | Tipo | Semantica |

|---|---|---|

shape |

Shape |

la forma dei dati per ricevere |

channel_handle |

ChannelHandle |

identificatore univoco per ogni coppia di invio/ricezione |

Riceve i dati della forma specificata da un'istruzione Send in un altro calcolo che condivide lo stesso handle di canale. Restituisce un

XlaOp per i dati ricevuti.

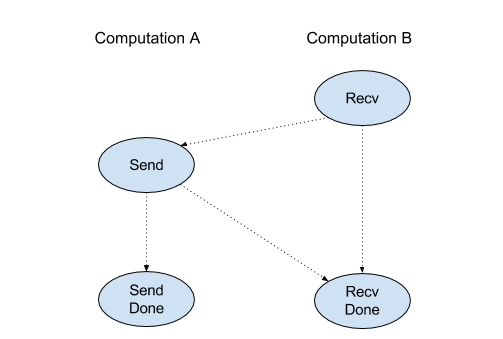

L'API client dell'operazione Recv rappresenta la comunicazione sincrona.

Tuttavia, l'istruzione viene decomposta internamente in due istruzioni HLO (Recv e RecvDone) per abilitare i trasferimenti di dati asincroni. Vedi anche

HloInstruction::CreateRecv e HloInstruction::CreateRecvDone.

Recv(const Shape& shape, int64 channel_id)

Alloca le risorse necessarie per ricevere i dati da un'istruzione Send con lo stesso channel_id. Restituisce un contesto per le risorse allocate, che viene utilizzato da una successiva istruzione RecvDone per attendere il completamento del trasferimento dei dati. Il contesto è una tupla di {receive buffer (shape), request identifier

(U32)} e può essere utilizzato solo da un'istruzione RecvDone.

RecvDone(HloInstruction context)

Dato un contesto creato da un'istruzione Recv, attende il completamento del trasferimento dei dati e restituisce i dati ricevuti.

Riduci

Vedi anche

XlaBuilder::Reduce.

Applica una funzione di riduzione a uno o più array in parallelo.

Reduce(operands..., init_values..., computation, dimensions)

| Argomenti | Tipo | Semantica |

|---|---|---|

operands |

Sequenza di N XlaOp |

N array di tipo T_0, ..., T_{N-1}. |

init_values |

Sequenza di N XlaOp |

N scalari di tipi T_0, ..., T_{N-1}. |

computation |

XlaComputation |

calcolo di tipo T_0, ..., T_{N-1}, T_0, ..., T_{N-1} -> Collate(T_0, ..., T_{N-1}). |

dimensions |

Array int64 |

Array non ordinato di dimensioni da ridurre. |

Dove:

- N deve essere maggiore o uguale a 1.

- Il calcolo deve essere "approssimativamente" associativo (vedi sotto).

- Tutti gli array di input devono avere le stesse dimensioni.

- Tutti i valori iniziali devono formare un'identità in

computation. - Se

N = 1,Collate(T)èT. - Se

N > 1,Collate(T_0, ..., T_{N-1})è una tupla di elementiNdi tipoT.

Questa operazione riduce una o più dimensioni di ogni array di input in scalari.

Il ranking di ogni matrice restituita è rank(operand) - len(dimensions). L'output

dell'operazione è Collate(Q_0, ..., Q_N), dove Q_i è un array di tipo T_i, le cui

dimensioni sono descritte di seguito.

È consentito associare nuovamente il calcolo della riduzione a backend diversi. Ciò può portare a differenze numeriche, poiché alcune funzioni di riduzione come l'addizione non sono associative per i valori float. Tuttavia, se l'intervallo dei dati è limitato, l'addizione a virgola mobile è sufficientemente simile all'associazione per la maggior parte degli utilizzi pratici.

Esempi

Quando si riduce una dimensione in un singolo array 1D con valori [10, 11,

12, 13], con la funzione di riduzione f (ovvero computation), il valore può essere calcolato come

f(10, f(11, f(12, f(init_value, 13)))

ma ci sono anche molte altre possibilità, ad es.

f(init_value, f(f(10, f(init_value, 11)), f(f(init_value, 12), f(init_value, 13))))

Di seguito è riportato un esempio approssimativo di pseudo-codice di come potrebbe essere implementata la riduzione, utilizzando la somma come calcolo della riduzione con un valore iniziale di 0.

result_shape <- remove all dims in dimensions from operand_shape

# Iterate over all elements in result_shape. The number of r's here is equal

# to the rank of the result

for r0 in range(result_shape[0]), r1 in range(result_shape[1]), ...:

# Initialize this result element

result[r0, r1...] <- 0

# Iterate over all the reduction dimensions

for d0 in range(dimensions[0]), d1 in range(dimensions[1]), ...:

# Increment the result element with the value of the operand's element.

# The index of the operand's element is constructed from all ri's and di's

# in the right order (by construction ri's and di's together index over the

# whole operand shape).

result[r0, r1...] += operand[ri... di]