도구

TensorFlow 워크플로를 지원하고 가속화하는 도구를 탐색하세요.

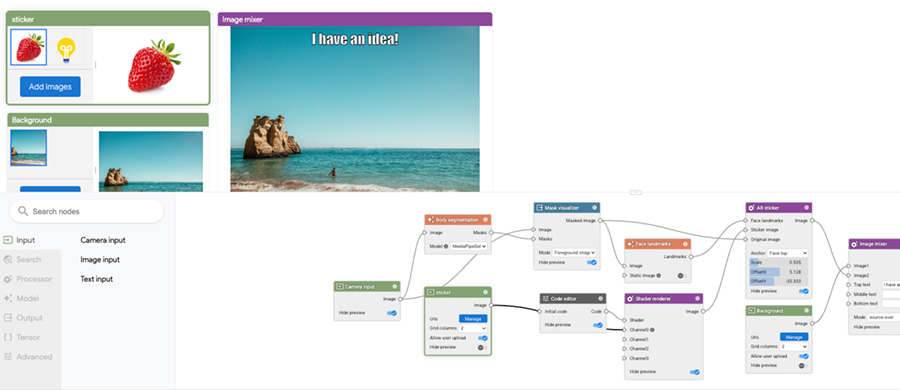

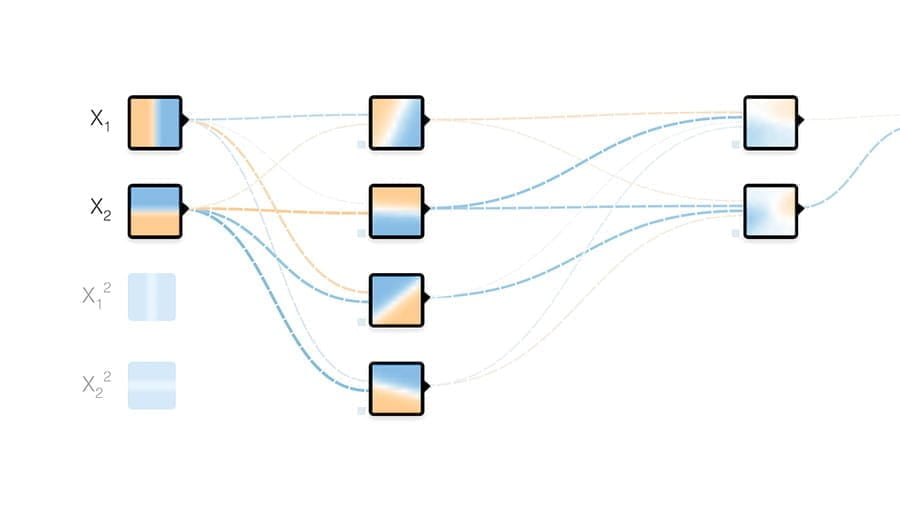

Visual Blocks

I/O 기기, 모델, 데이터 증강, Colab 코드를 재사용 가능한 구성요소로 사용하여 ML 워크플로의 프로토타입을 제작하는 시각적 코딩 웹 프레임워크입니다.

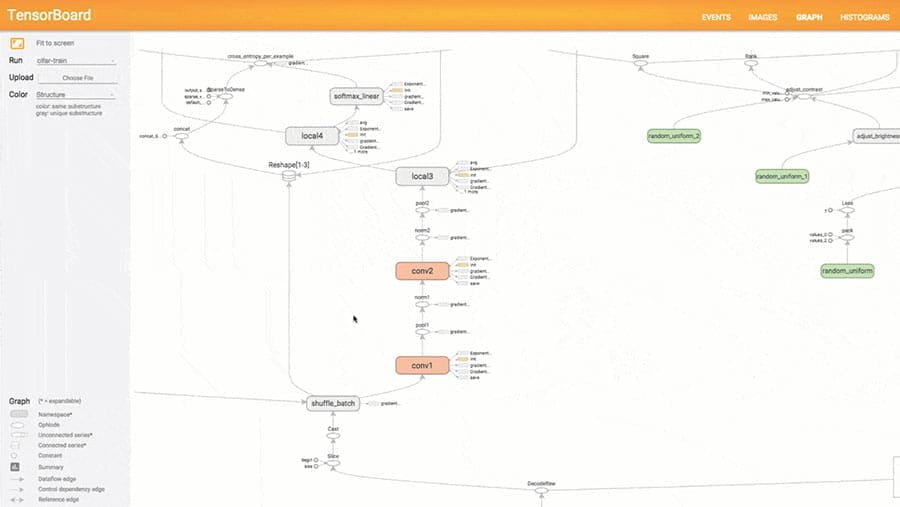

What-If Tool

모델 이해, 디버깅, 공정성에 유용한 머신러닝 모델의 코드 없는 프로빙을 위한 도구입니다. 텐서보드와 jupyter 또는 colab 노트북에서 사용 가능합니다.

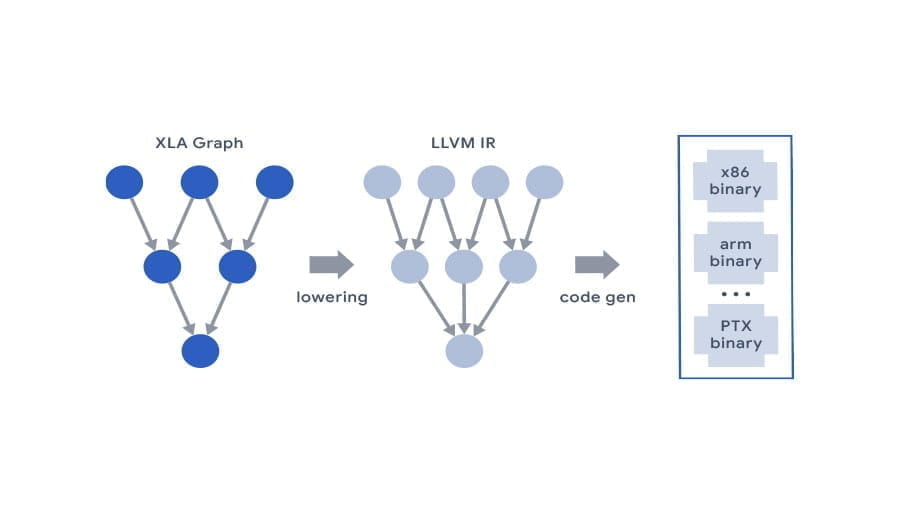

TPU Research Cloud

TPU Research Cloud(TRC) 프로그램을 통해 연구원은 1,000개가 넘는 Cloud TPU의 클러스터에 대한 무료 액세스를 신청할 수 있으며, 이를 통해 새로운 연구 혁신을 가속화할 수 있습니다.