Découvrez comment intégrer des pratiques de Responsible AI dans votre workflow de ML à l'aide de TensorFlow

TensorFlow s'engage à faire progresser le développement responsable de l'IA en partageant un ensemble de ressources et d'outils avec la communauté du machine learning.

Qu'est-ce que l'IA responsable ?

Le développement de l'IA offre de nouvelles opportunités pour résoudre des problèmes concrets complexes. Cela soulève également de nouvelles questions quant au meilleur moyen de concevoir des systèmes d'IA dont tout le monde peut bénéficier.

Bonnes pratiques recommandées pour l'IA

La conception de systèmes d'IA doit respecter les bonnes pratiques en termes de développement logiciel, tout en adoptant une

approche du ML centrée sur l'humain

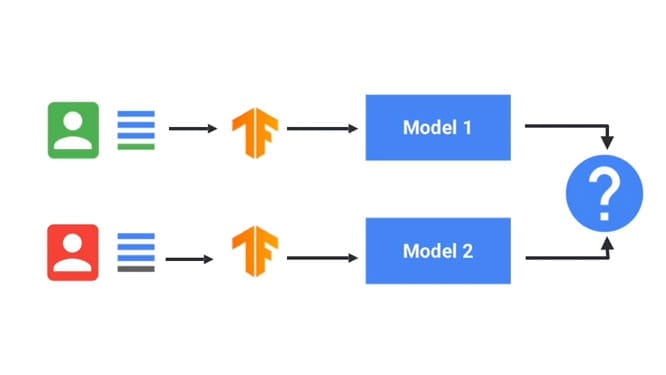

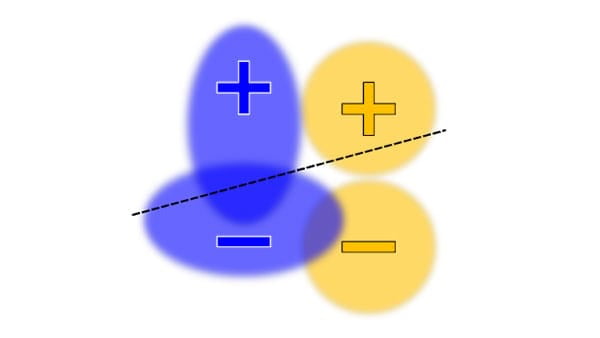

Équité

L'IA ne cesse de gagner en importance dans tous les secteurs d'activités et au sein de la société. Il est donc essentiel de s'atteler à la mise en œuvre de systèmes qui soient équitables et qui s'adressent à tous.

Interprétabilité

Il est important de bien comprendre les systèmes d'IA et de leur faire confiance pour s'assurer qu'ils fonctionnent comme prévu

Confidentialité

L'utilisation de mesures de protection de la confidentialité est nécessaire pour entraîner des modèles à l'aide de données sensibles

Sécurité

Identifier les menaces potentielles peut contribuer à la sécurité et à la protection des systèmes d'IA

Une Responsible AI dans votre workflow de ML

Des pratiques de Responsible AI peuvent être intégrées à chaque étape du workflow de ML. Voici quelques questions importantes que vous devez vous poser à chaque étape.

À qui mon système de ML est-il destiné ?

Les conditions d'utilisation réelles de votre système constituent un facteur essentiel pour évaluer l'impact de ses prédictions, recommandations et décisions. Veillez à obtenir des retours d'un large éventail d'utilisateurs dès le début de votre processus de développement.

L'ensemble de données que j'utilise est-il représentatif ?

Vos données sont-elles échantillonnées de telle manière qu'elles représentent vos utilisateurs (par exemple, si elles

sont destinées à être utilisées pour toutes les tranches d'âges, mais que vous ne disposez que de données d'entraînement pour les personnes âgées)

et un environnement réel (par exemple, si elles sont destinées à être utilisées toute l'année, mais que vous

ne disposez que de données d'entraînement pour l'été) ?

Les données comportent-elles des biais réels/humains ?

La présence de biais sous-jacents dans les données peut donner lieu à des boucles de rétroaction complexes qui renforcent les stéréotypes existants.

Quelles méthodes dois-je utiliser pour entraîner mon modèle ?

Utilisez des méthodes d'entraînement qui répondent au mieux aux problématiques d'équité, d'interprétabilité, de confidentialité et de sécurité du modèle.

Quelles sont les performances de mon modèle ?

Évaluez l'expérience utilisateur dans des scénarios réels sur un large éventail d'utilisateurs, avec divers cas et contextes d'utilisation. Effectuez des tests et des itérations dans la version dogfood, puis procédez à des tests continus après le lancement.

Y a-t-il des boucles de rétroaction complexes ?

Même si l'ensemble du système a été conçu avec soin, il est rare que les modèles basés sur le ML fonctionnent parfaitement lorsqu'ils sont appliqués à des données dynamiques réelles. Lorsqu'un problème survient dans un produit, déterminez s'il correspond à des inégalités sociétales existantes, et dans quelle mesure il sera affecté par des solutions à court et à long terme.

Outils de Responsible AI pour TensorFlow

L'écosystème TensorFlow comprend une suite d'outils et de ressources permettant de résoudre certains des problèmes évoqués ci-dessus.

Définir un problème

Utilisez les ressources suivantes pour concevoir des modèles selon les principes de l'IA responsable.

Découvrez le processus de développement de l'IA et d'autres remarques importantes.

Découvrez, par le biais de visualisations interactives, les principales questions et les concepts clés dans le domaine de la Responsible AI.

Développer et préparer des données

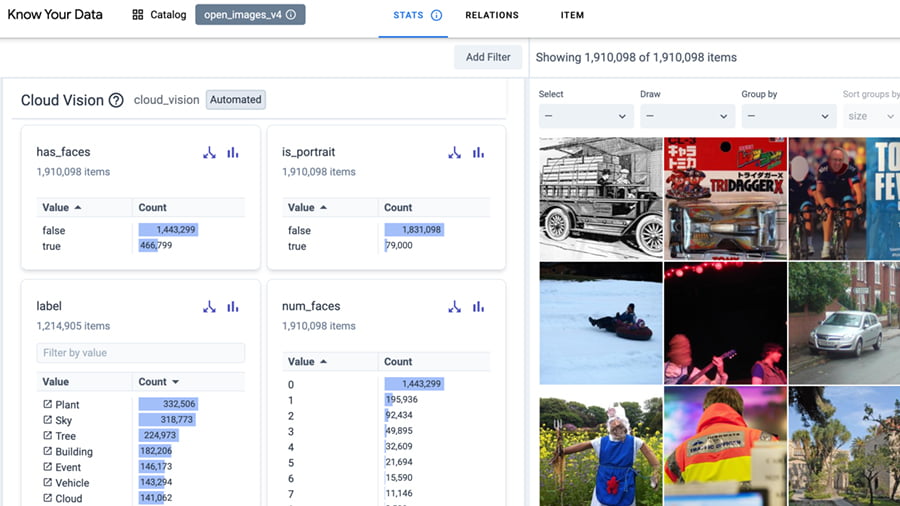

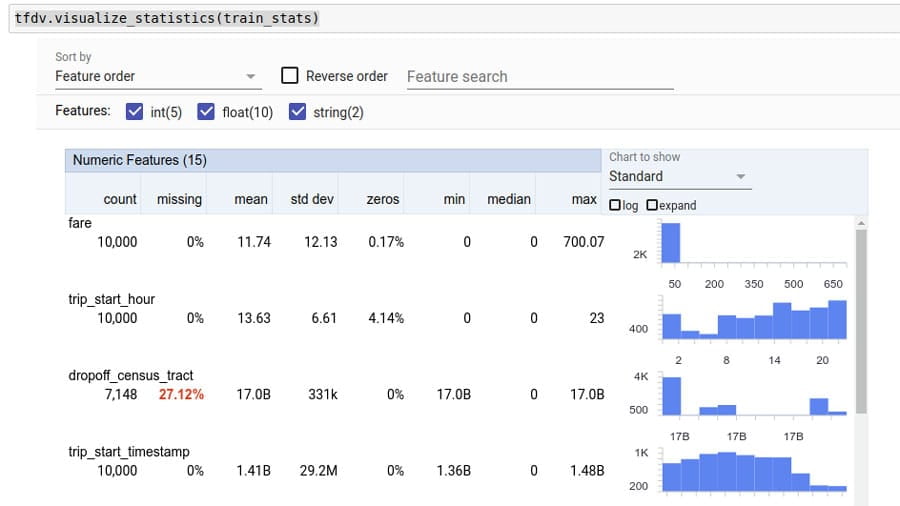

Utilisez les outils suivants pour découvrir des biais potentiels dans les données.

Analysez votre ensemble de données de manière interactive pour améliorer la qualité des données et réduire les problèmes d'équité et de biais.

Analysez et transformez les données pour détecter les problèmes et concevoir des ensembles de caractéristiques plus efficaces.

Créez un rapport sur la transparence des informations pour votre ensemble de données.

Une palette de carnations plus large, sous licence ouverte, pour que votre collecte de données et votre création de modèles soient plus solides et inclusives.

Développer et entraîner un modèle

Utilisez les outils suivants pour entraîner des modèles à l'aide de mesures de protection de la vie privée, de techniques interprétables et bien plus encore.

Entraînez des modèles de machine learning pour générer des résultats plus équitables.

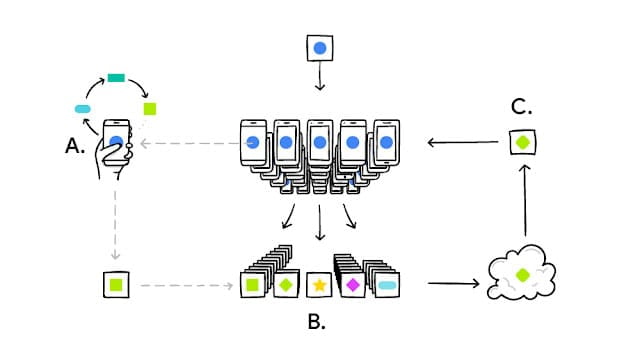

Entraînez des modèles de machine learning pour la confidentialité des données.

Entraînez des modèles de machine learning à l'aide de techniques d'apprentissage fédéré.

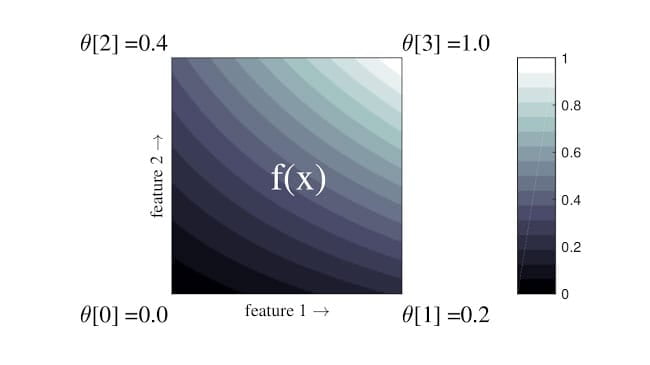

Mettez en œuvre des modèles basés sur des réseaux flexibles, contrôlés et interprétables.

Évaluer le modèle

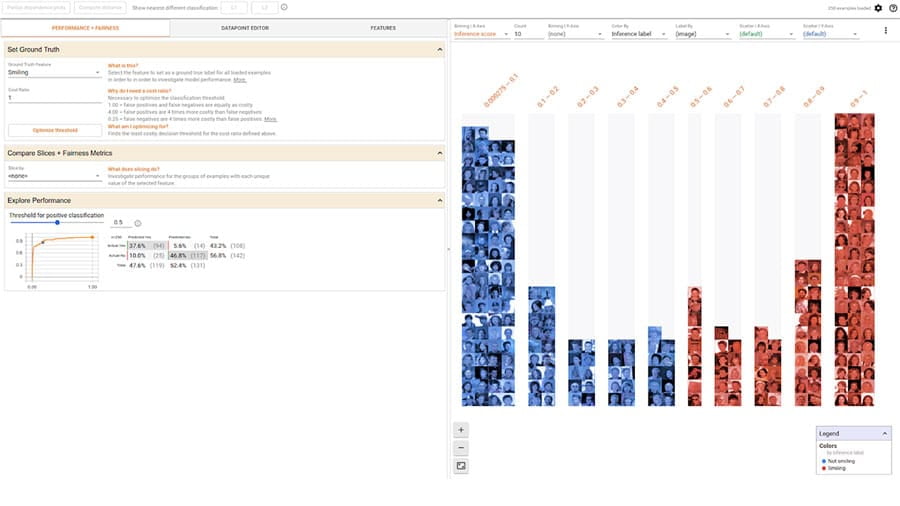

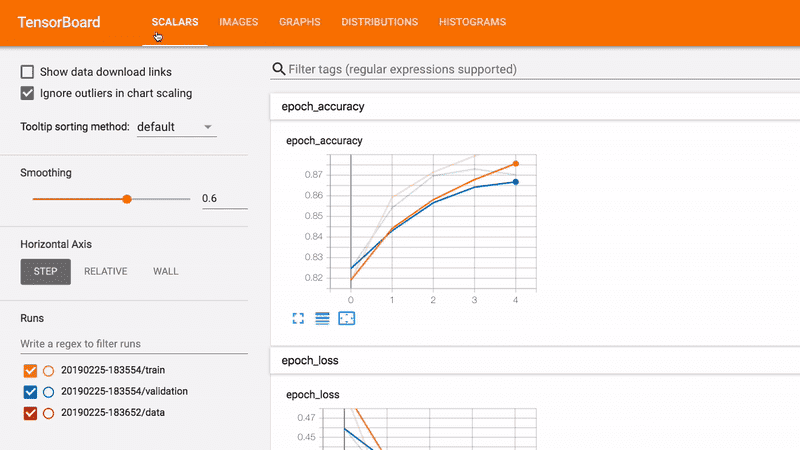

Déboguez, évaluez et visualisez les performances du modèle à l'aide des outils suivants.

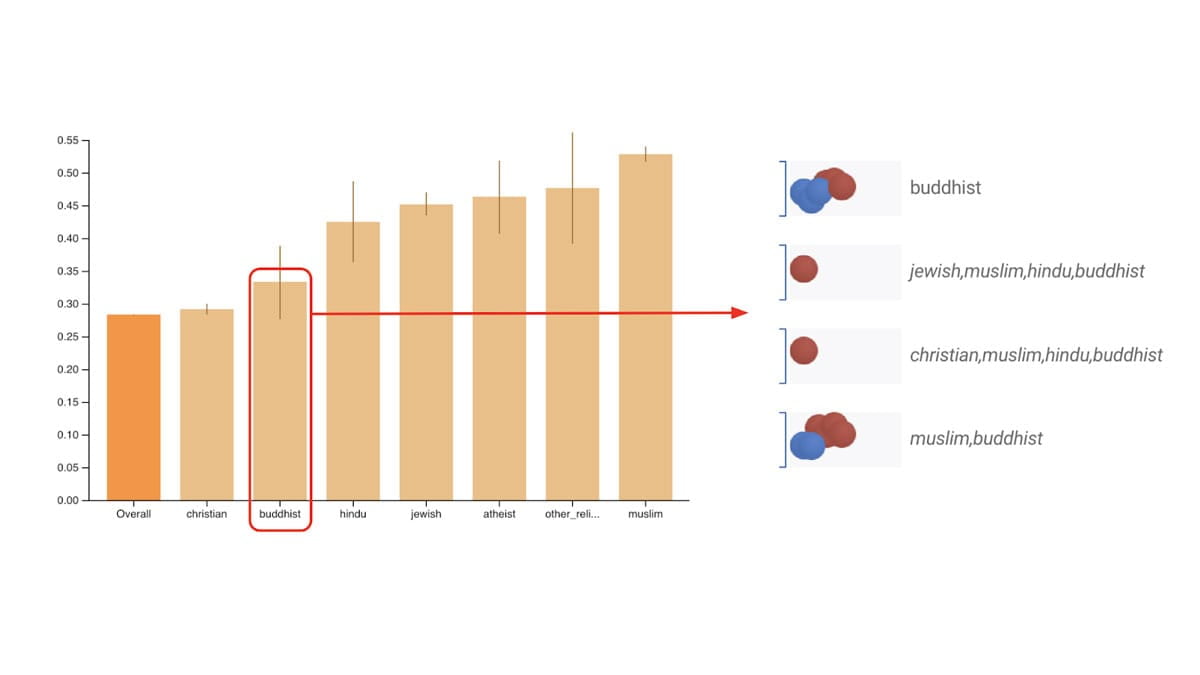

Calculez des métriques d'équité couramment identifiées pour les classificateurs multiclasses et binaires.

Évaluez des modèles de manière distribuée et effectuez des calculs sur différentes tranches de données.

Développez des modèles de machine learning interprétables et inclusifs.

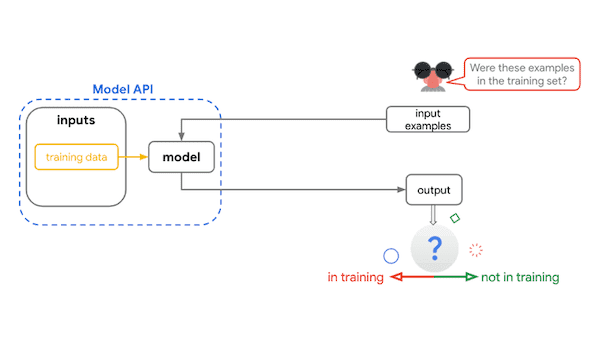

Évaluez les propriétés de confidentialité des modèles de classification.

Déployer et surveiller

Utilisez les outils suivants pour effectuer le suivi des informations et du contexte du modèle, et communiquer à leur sujet.

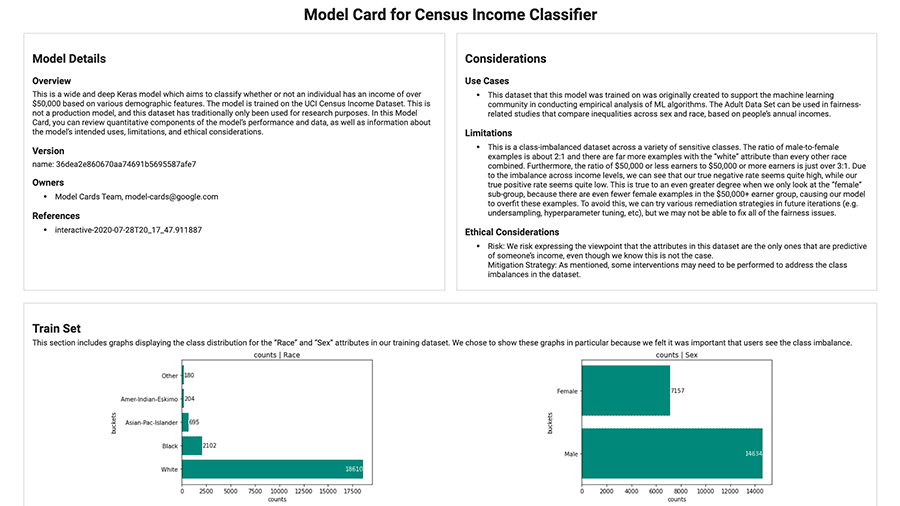

Générez facilement des fiches modèles à l'aide de la boîte à outils Model Card.

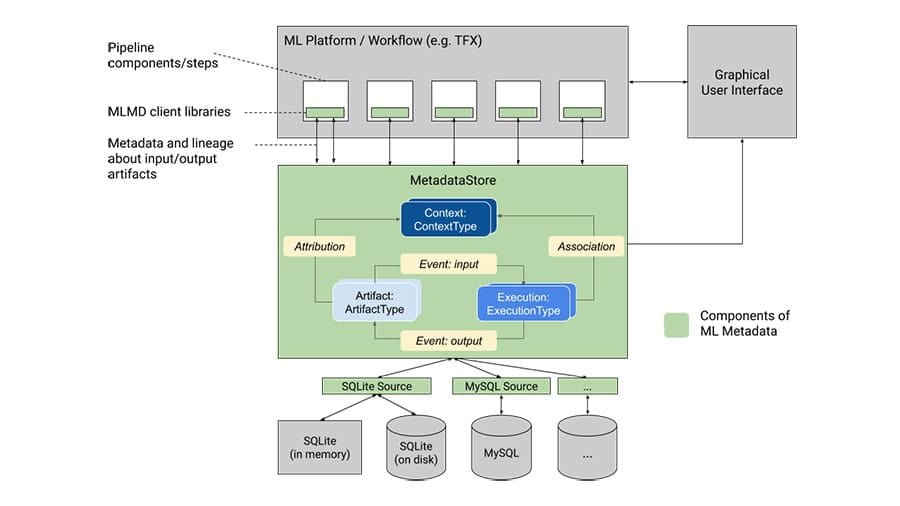

Enregistrez et récupérez les métadonnées associées aux workflows pour les data scientists et les développeurs ML.

Organisez de manière structurée les points essentiels concernant le machine learning.

Ressources de la communauté

Découvrez les travaux de la communauté et comment apporter votre contribution.

Faites en sorte que les produits de Google soient plus inclusifs et plus représentatifs de votre langue, de votre région et de votre culture.

Nous avons demandé aux participants de concevoir un modèle ou une application selon les principes Responsible AI grâce à TensorFlow 2.2. Consultez la galerie pour découvrir les gagnants ainsi que d'autres projets passionnants.

Présentation d'un framework axé sur le ML, l'équité et la confidentialité.