למד כיצד לשלב פרקטיקות בינה מלאכותית אחראית בזרימת העבודה שלך ב-ML באמצעות TensorFlow

TensorFlow מחויבת לעזור להתקדם בפיתוח אחראי של AI על ידי שיתוף אוסף של משאבים וכלים עם קהילת ה-ML.

מה זה בינה מלאכותית אחראית?

הפיתוח של AI יוצר הזדמנויות חדשות לפתור בעיות מאתגרות בעולם האמיתי. זה גם מעלה שאלות חדשות לגבי הדרך הטובה ביותר לבנות מערכות AI שמועילות לכולם.

שיטות עבודה מומלצות מומלצות עבור AI

תכנון מערכות בינה מלאכותית צריך לעקוב אחר שיטות עבודה מומלצות לפיתוח תוכנה תוך שימוש באדם ממוקד

גישה ל-ML

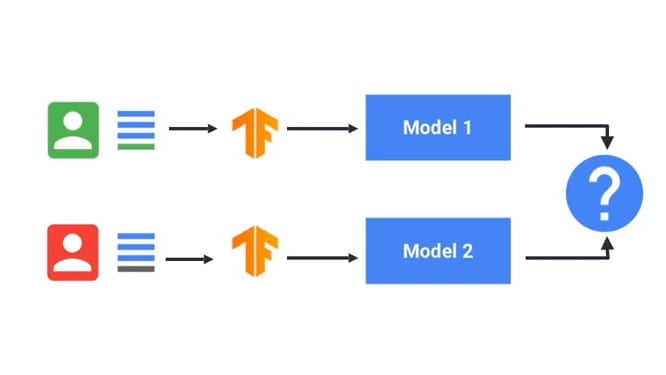

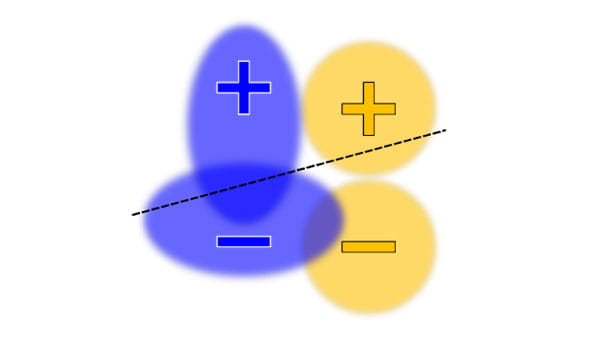

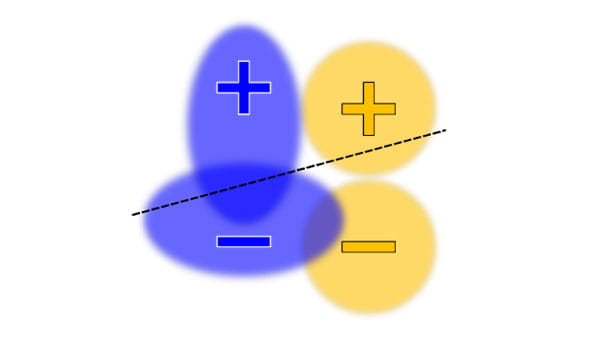

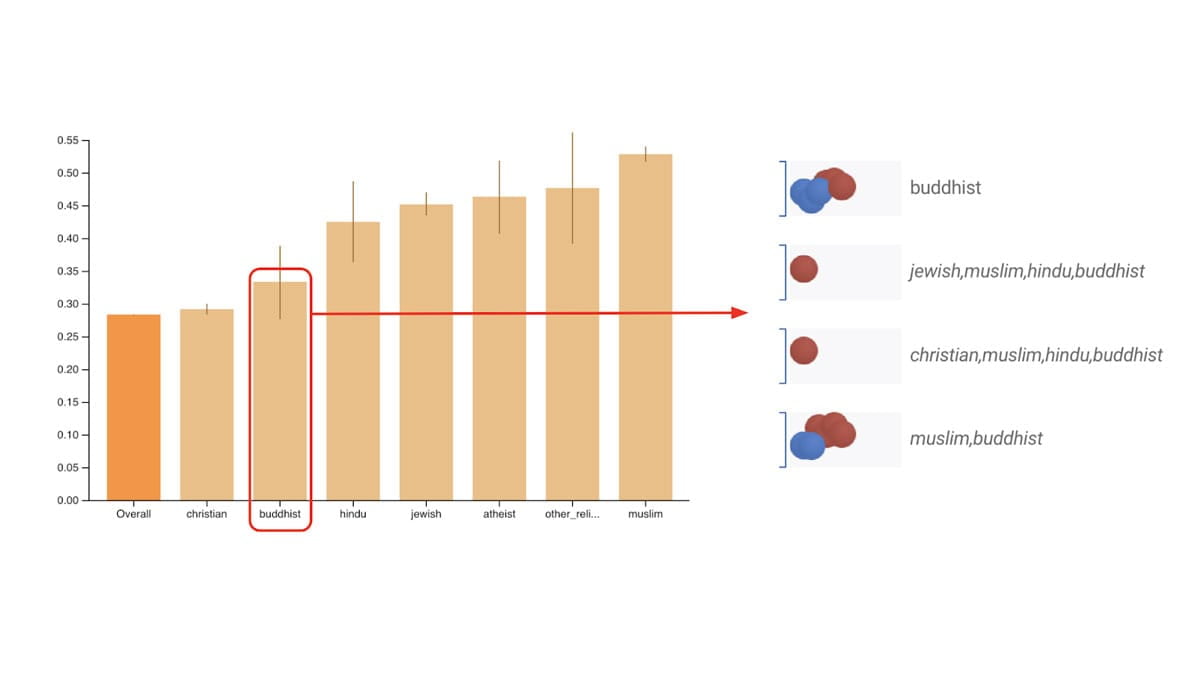

הֲגִינוּת

ככל שהשפעת הבינה המלאכותית גוברת בין מגזרים וחברות, חיוני לפעול למען מערכות הוגנות ומכילות לכולם

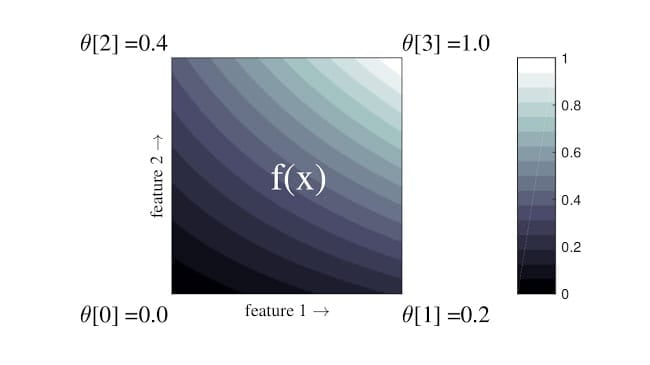

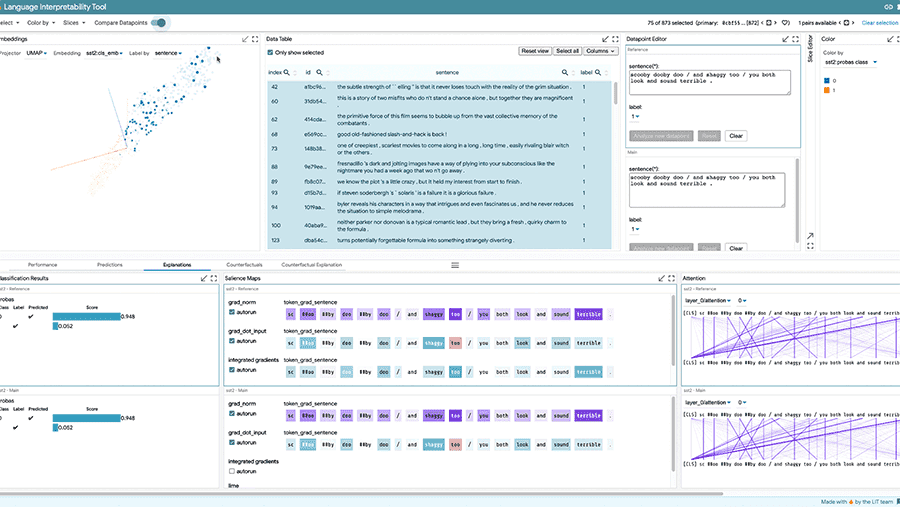

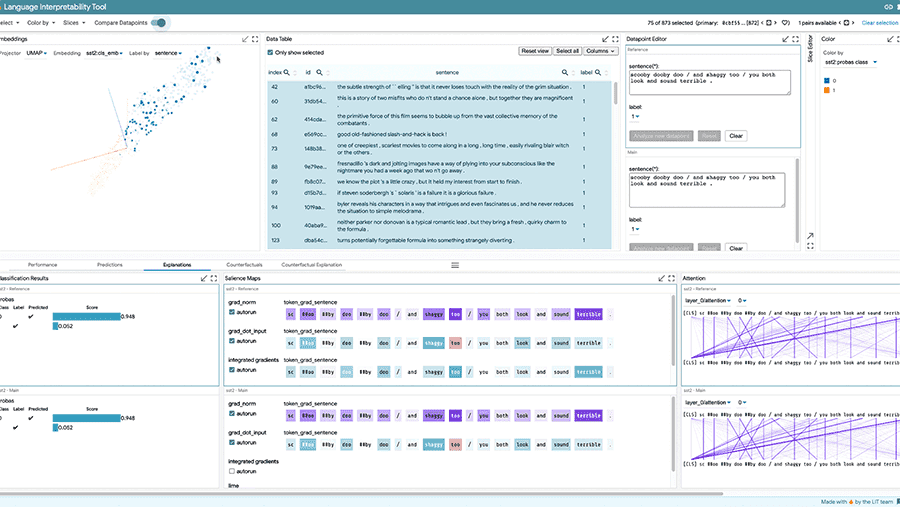

ניתנות לפירוש

חשוב להבין ולסמוך על מערכות AI כדי להבטיח שהן פועלות כמתוכנן

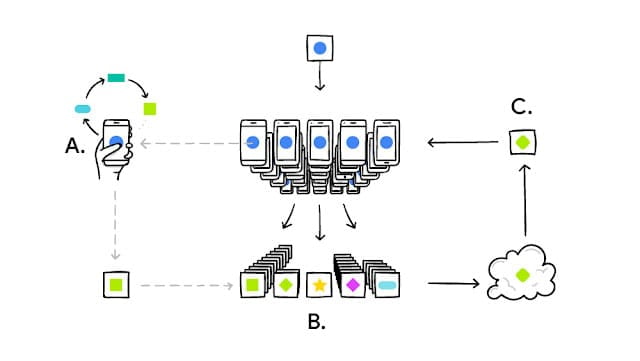

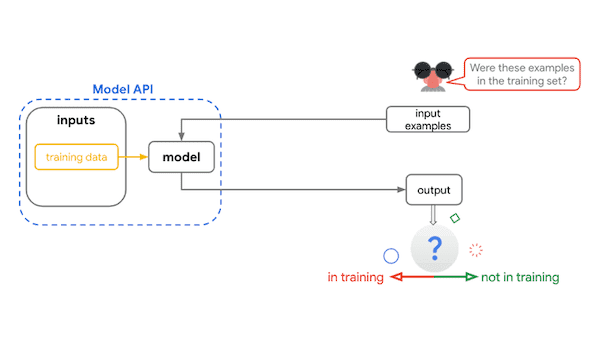

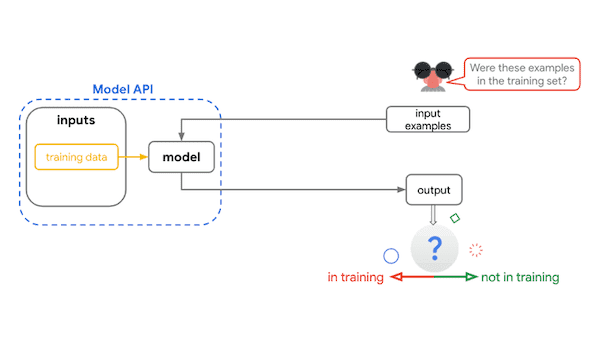

פְּרָטִיוּת

אימון מודלים של נתונים רגישים זקוק לשמירה על פרטיות

בִּטָחוֹן

זיהוי איומים פוטנציאליים יכול לעזור לשמור על בטיחות ומאובטחת מערכות AI

AI אחראי בתהליך העבודה שלך ב-ML

ניתן לשלב שיטות AI אחראיות בכל שלב של זרימת העבודה של ML. הנה כמה שאלות מרכזיות שיש לקחת בחשבון בכל שלב.

למי מיועדת מערכת ה-ML שלי?

האופן שבו המשתמשים בפועל חווים את המערכת שלך חיונית להערכת ההשפעה האמיתית של התחזיות, ההמלצות וההחלטות שלה. הקפד לקבל מידע מקבוצה מגוונת של משתמשים בשלב מוקדם בתהליך הפיתוח שלך.

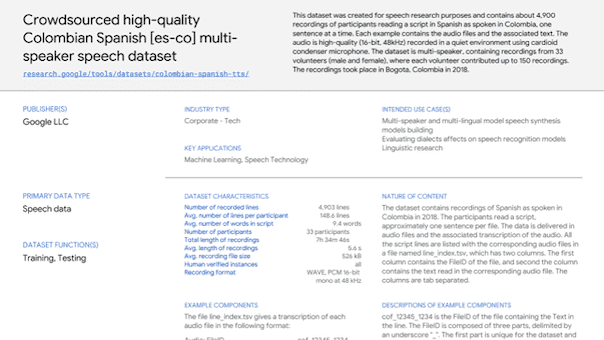

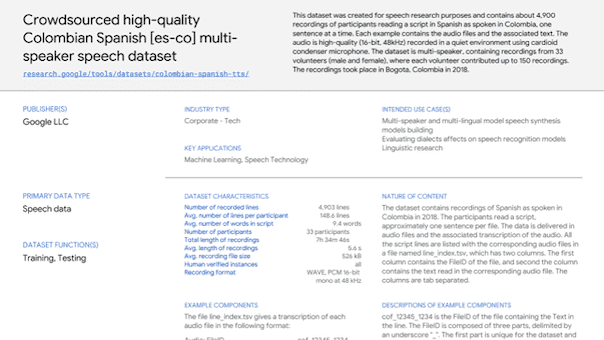

האם אני משתמש במערך נתונים מייצג?

האם הנתונים שלך נדגמו בצורה שמייצגת את המשתמשים שלך (למשל ישמשו עבור כל הגילאים, אבל יש לך רק נתוני הכשרה מאזרחים ותיקים) ואת ההגדרה בעולם האמיתי (למשל ישמש כל השנה, אבל יש לך רק הכשרה נתונים מהקיץ)?

האם יש הטיה בעולם האמיתי/אנושי בנתונים שלי?

הטיות בסיסיות בנתונים יכולות לתרום ללולאות משוב מורכבות שמחזקות סטריאוטיפים קיימים.

באילו שיטות עלי להשתמש כדי לאמן את המודל שלי?

השתמש בשיטות הדרכה שמבנות במודל הוגנות, פרשנות, פרטיות ואבטחה.

איך המודל שלי מתפקד?

הערכת חווית משתמש בתרחישים בעולם האמיתי על פני קשת רחבה של משתמשים, מקרי שימוש והקשרי שימוש. בדוק תחילה בניסוי לפני הפצה, ולאחר מכן המשך בדיקה לאחר ההשקה.

האם יש לולאות משוב מורכבות?

גם אם כל מה בתכנון המערכת הכולל מעוצב בקפידה, מודלים מבוססי ML רק לעתים נדירות פועלים ב-100% שלמות כשהם מיושמים על נתונים אמיתיים, חיים. כאשר מתרחשת בעיה במוצר חי, שקול האם היא תואמת את החסרונות החברתיים הקיימים, וכיצד היא תושפע מפתרונות לטווח קצר וארוך כאחד.

כלי AI אחראי עבור TensorFlow

למערכת האקולוגית של TensorFlow יש חבילה של כלים ומשאבים שיעזרו להתמודד עם כמה מהשאלות שלמעלה.

תגדיר בעיה

השתמש במשאבים הבאים כדי לעצב מודלים מתוך מחשבה על AI אחראי.

חקור, באמצעות הדמיות אינטראקטיביות, שאלות ומושגים מרכזיים בתחום הבינה המלאכותית האחראית.

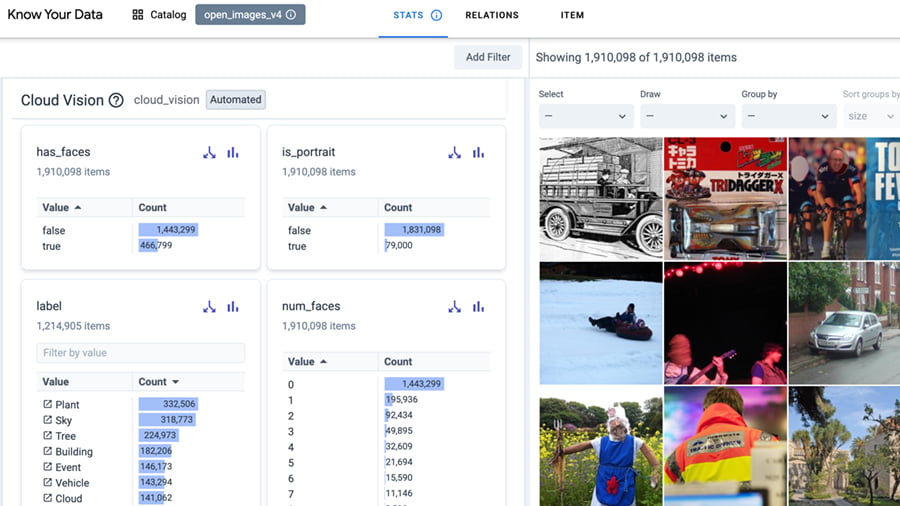

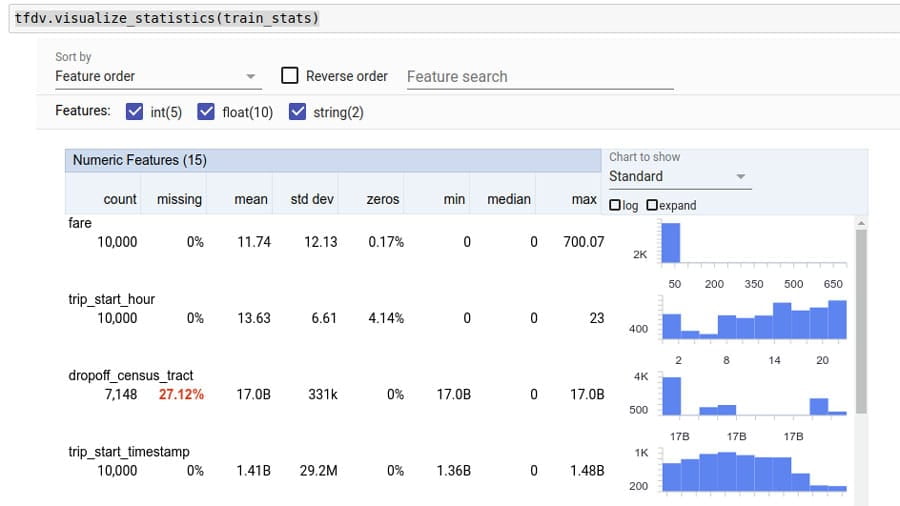

לבנות ולהכין נתונים

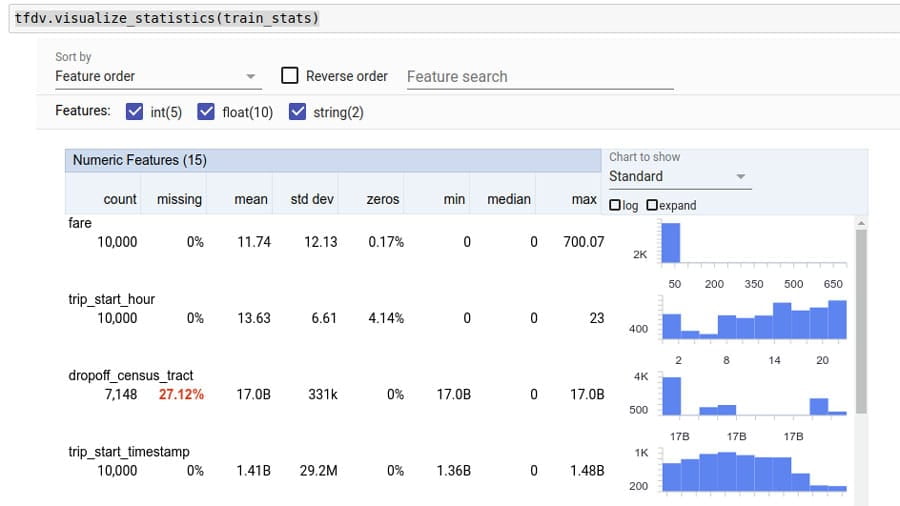

השתמש בכלים הבאים כדי לבחון את הנתונים עבור הטיות אפשריות.

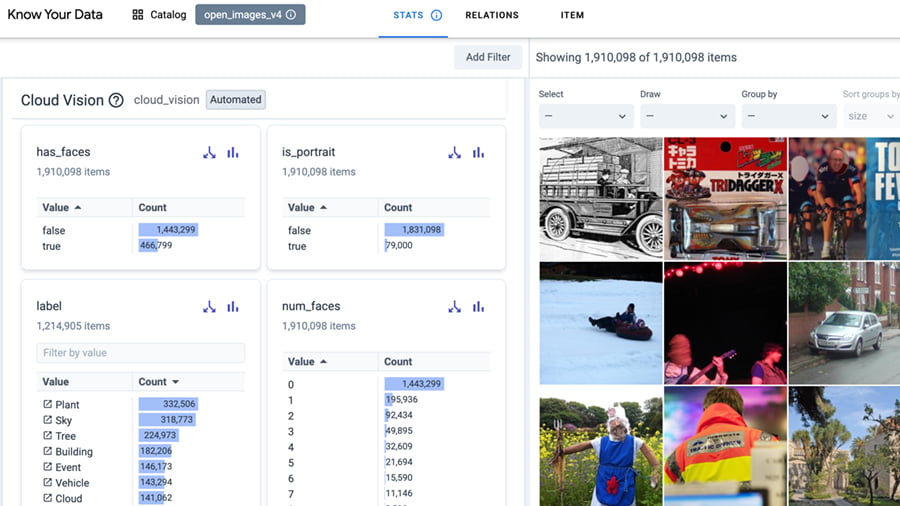

חקור באופן אינטראקטיבי את מערך הנתונים שלך כדי לשפר את איכות הנתונים ולהפחית בעיות הגינות והטיות.

סולם גוון עור כולל יותר, בעל רישיון פתוח, כדי להפוך את צורכי איסוף הנתונים ובניית הדגמים שלך לחזקים ומכילים יותר.

בנה ואימון מודל

השתמש בכלים הבאים כדי להכשיר מודלים תוך שימוש בטכניקות לשמירה על הפרטיות, הניתנות לפירוש ועוד.

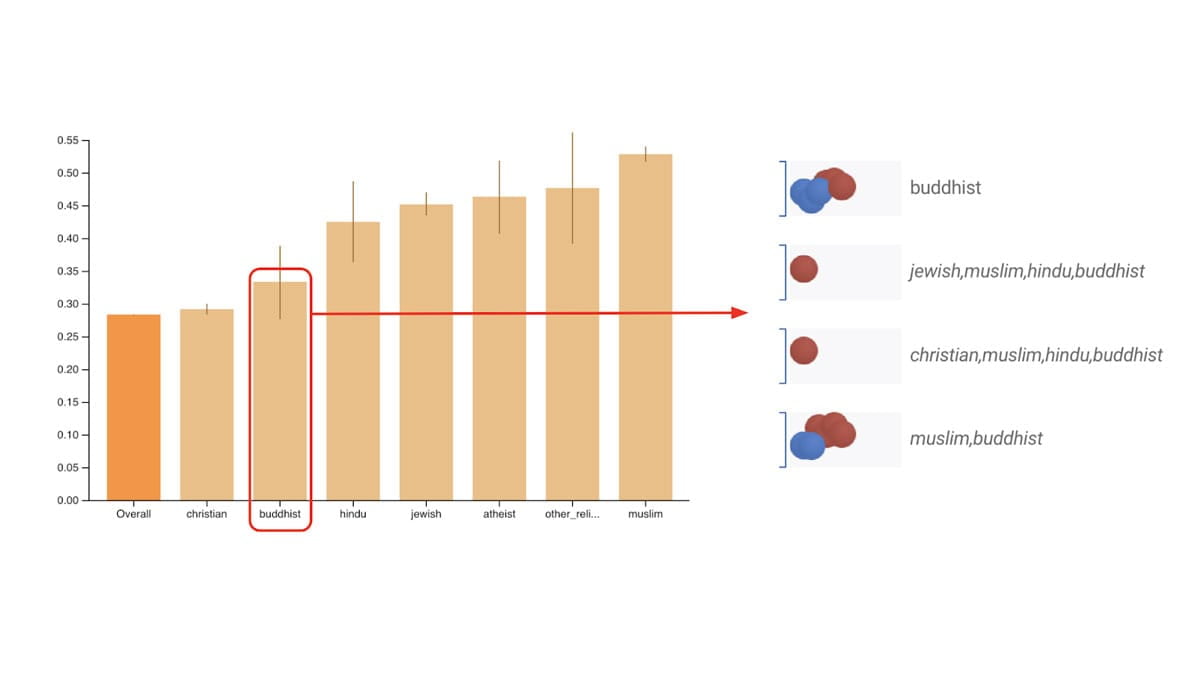

הערכת מודל

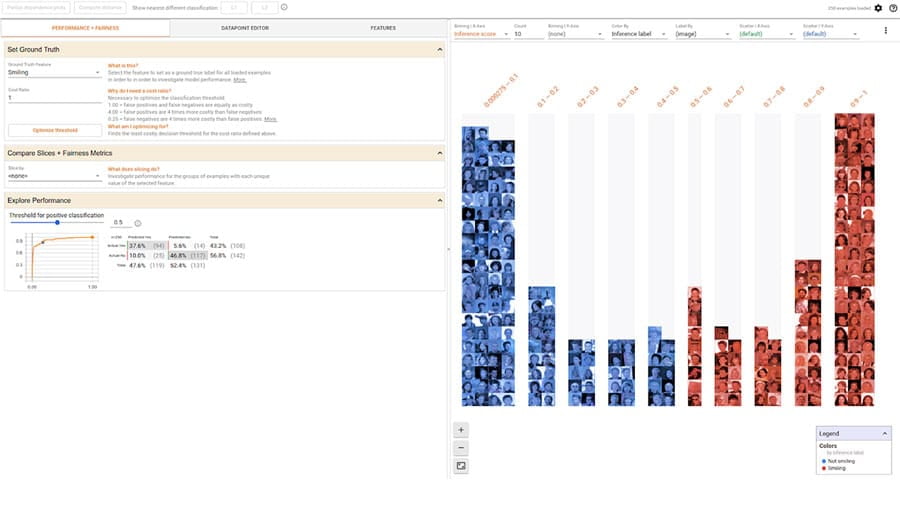

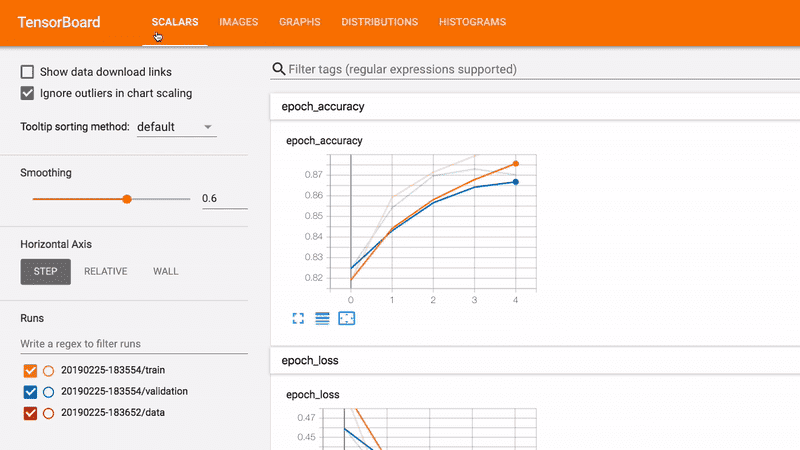

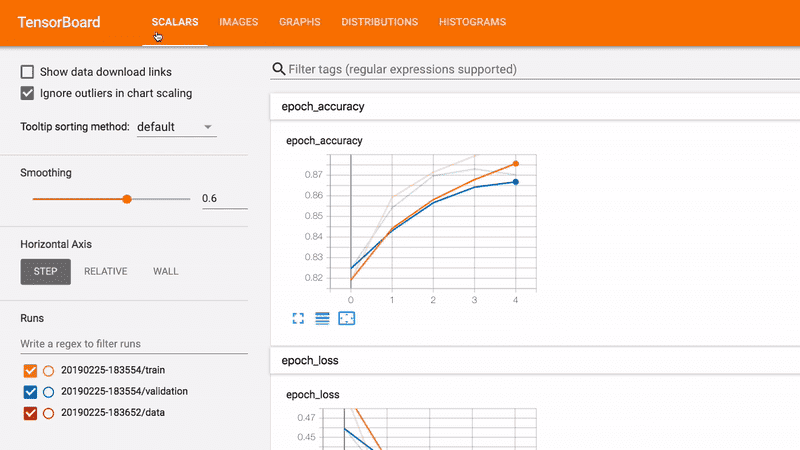

איתור באגים, הערכת ודמיין את ביצועי המודל באמצעות הכלים הבאים.

פריסה וניטור

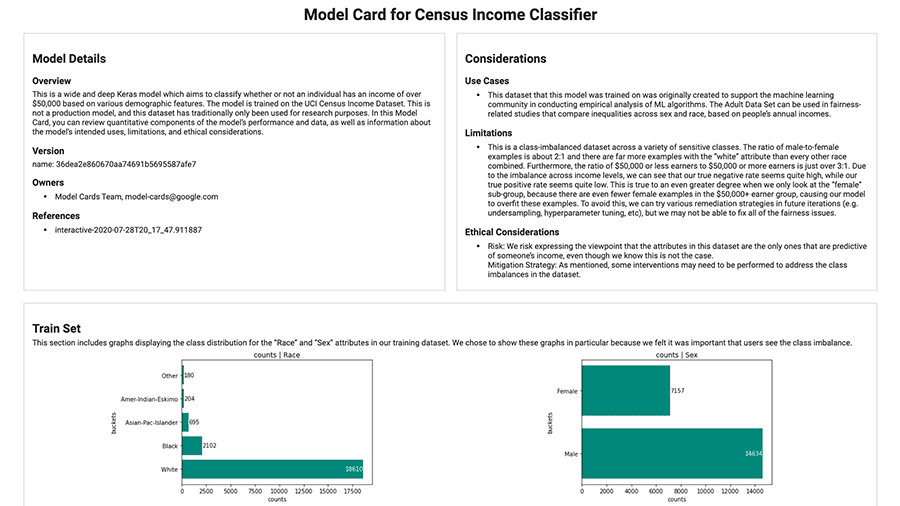

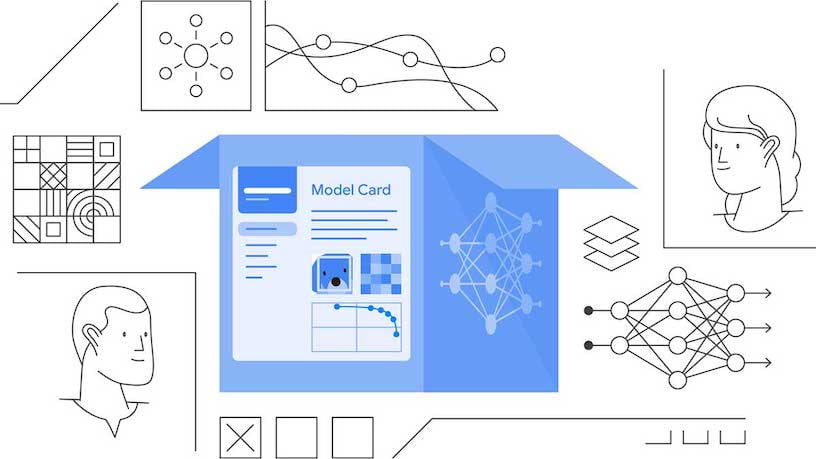

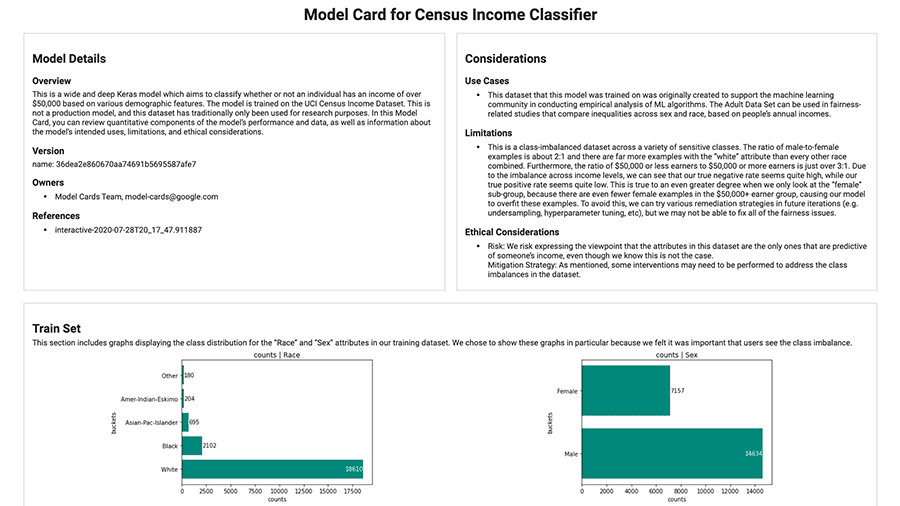

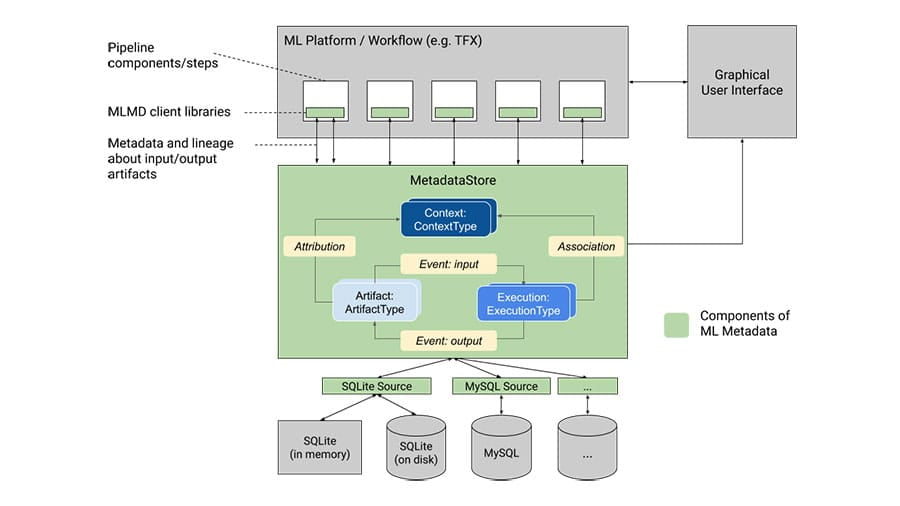

השתמש בכלים הבאים כדי לעקוב ולתקשר לגבי הקשר ופרטים של המודל.

משאבי קהילה

למד מה הקהילה עושה ולחקור דרכים להיות מעורבות.

עזור למוצרים של Google להפוך ליותר כוללים ומייצגים את השפה, האזור והתרבות שלך.

ביקשנו מהמשתתפים להשתמש ב-TensorFlow 2.2 כדי לבנות מודל או יישום עם עקרונות בינה מלאכותית אחראית. בדוק את הגלריה כדי לראות את הזוכים ופרויקטים מדהימים אחרים.

למד כיצד לשלב פרקטיקות בינה מלאכותית אחראית בזרימת העבודה שלך ב-ML באמצעות TensorFlow

TensorFlow מחויבת לסייע בהתקדמות בפיתוח אחראי של AI על ידי שיתוף אוסף של משאבים וכלים עם קהילת ה-ML.

מה זה בינה מלאכותית אחראית?

הפיתוח של AI יוצר הזדמנויות חדשות לפתור בעיות מאתגרות בעולם האמיתי. זה גם מעלה שאלות חדשות לגבי הדרך הטובה ביותר לבנות מערכות AI שמועילות לכולם.

שיטות עבודה מומלצות מומלצות עבור AI

תכנון מערכות בינה מלאכותית צריך לעקוב אחר שיטות עבודה מומלצות לפיתוח תוכנה תוך שימוש באדם ממוקד

גישה ל-ML

הֲגִינוּת

ככל שהשפעת הבינה המלאכותית גוברת בין מגזרים וחברות, חיוני לפעול למען מערכות הוגנות ומכילות לכולם

ניתנות לפירוש

חשוב להבין ולסמוך על מערכות AI כדי להבטיח שהן פועלות כמתוכנן

פְּרָטִיוּת

אימון מודלים של נתונים רגישים זקוק לשמירה על פרטיות

בִּטָחוֹן

זיהוי איומים פוטנציאליים יכול לעזור לשמור על בטיחות ומאובטחת מערכות AI

AI אחראי בתהליך העבודה שלך ב-ML

ניתן לשלב שיטות AI אחראיות בכל שלב של זרימת העבודה של ML. הנה כמה שאלות מרכזיות שיש לקחת בחשבון בכל שלב.

למי מיועדת מערכת ה-ML שלי?

האופן שבו המשתמשים בפועל חווים את המערכת שלך חיונית להערכת ההשפעה האמיתית של התחזיות, ההמלצות וההחלטות שלה. הקפד לקבל מידע מקבוצה מגוונת של משתמשים בשלב מוקדם בתהליך הפיתוח שלך.

האם אני משתמש במערך נתונים מייצג?

האם הנתונים שלך נדגמו בצורה שמייצגת את המשתמשים שלך (למשל ישמשו עבור כל הגילאים, אבל יש לך רק נתוני הדרכה מאזרחים ותיקים) ואת ההגדרה בעולם האמיתי (למשל ישמש כל השנה, אבל יש לך רק הכשרה נתונים מהקיץ)?

האם יש הטיה בעולם האמיתי/אנושי בנתונים שלי?

הטיות בסיסיות בנתונים יכולות לתרום ללולאות משוב מורכבות שמחזקות סטריאוטיפים קיימים.

באילו שיטות עלי להשתמש כדי לאמן את המודל שלי?

השתמש בשיטות הדרכה שמבנות במודל הוגנות, פרשנות, פרטיות ואבטחה.

איך המודל שלי מתפקד?

הערכת חווית משתמש בתרחישים בעולם האמיתי על פני קשת רחבה של משתמשים, מקרי שימוש והקשרי שימוש. בדוק תחילה בניסוי לפני הפצה, ולאחר מכן המשך בדיקה לאחר ההשקה.

האם יש לולאות משוב מורכבות?

גם אם הכל בתכנון המערכת הכולל מעוצב בקפידה, מודלים מבוססי ML רק לעתים רחוקות פועלים ב-100% שלמות כשהם מיושמים על נתונים אמיתיים, חיים. כאשר מתרחשת בעיה במוצר חי, שקול אם היא תואמת את החסרונות החברתיים הקיימים, וכיצד היא תושפע מפתרונות לטווח קצר וארוך כאחד.

כלי AI אחראי עבור TensorFlow

למערכת האקולוגית של TensorFlow יש חבילה של כלים ומשאבים שיעזרו להתמודד עם כמה מהשאלות שלמעלה.

תגדיר בעיה

השתמש במשאבים הבאים כדי לעצב מודלים מתוך מחשבה על AI אחראי.

חקור, באמצעות הדמיות אינטראקטיביות, שאלות ומושגים מרכזיים בתחום הבינה המלאכותית האחראית.

לבנות ולהכין נתונים

השתמש בכלים הבאים כדי לבחון את הנתונים עבור הטיות אפשריות.

חקור באופן אינטראקטיבי את מערך הנתונים שלך כדי לשפר את איכות הנתונים ולהפחית בעיות הגינות והטיות.

סולם גוון עור כולל יותר, בעל רישיון פתוח, כדי להפוך את צורכי איסוף הנתונים ובניית הדגמים שלך לחזקים ומכילים יותר.

בנה ואימון מודל

השתמש בכלים הבאים כדי להכשיר מודלים תוך שימוש בטכניקות לשמירה על הפרטיות, הניתנות לפירוש ועוד.

הערכת מודל

איתור באגים, הערכת ודמיין את ביצועי המודל באמצעות הכלים הבאים.

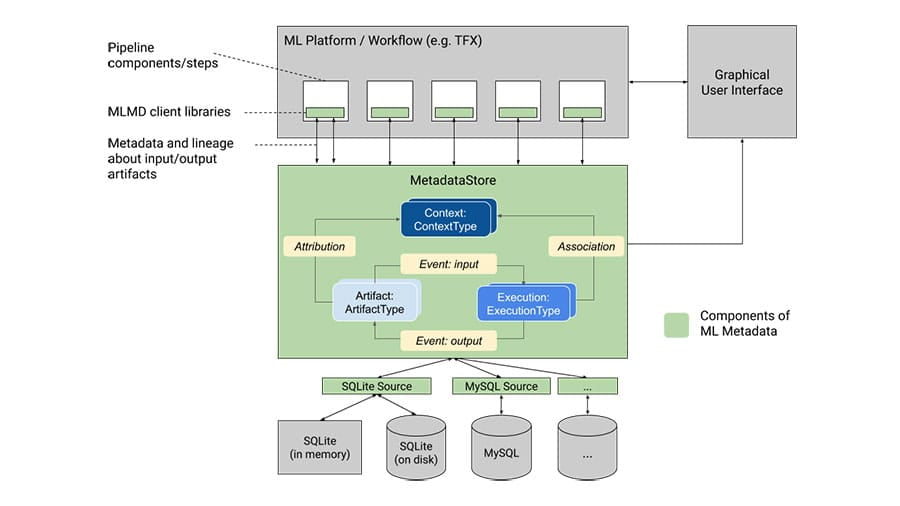

פריסה וניטור

השתמש בכלים הבאים כדי לעקוב ולתקשר לגבי הקשר ופרטים של המודל.

משאבי קהילה

למד מה הקהילה עושה ולחקור דרכים להיות מעורבות.

עזור למוצרים של Google להפוך ליותר כוללים ומייצגים את השפה, האזור והתרבות שלך.

ביקשנו מהמשתתפים להשתמש ב-TensorFlow 2.2 כדי לבנות מודל או יישום עם עקרונות בינה מלאכותית אחראית. בדוק את הגלריה כדי לראות את הזוכים ופרויקטים מדהימים אחרים.