Узнайте, как интегрировать методы ответственного ИИ в рабочий процесс машинного обучения с помощью TensorFlow.

TensorFlow стремится помочь добиться прогресса в ответственной разработке ИИ, делясь набором ресурсов и инструментов с сообществом ML.

Что такое ответственный ИИ?

Развитие ИИ создает новые возможности для решения сложных реальных проблем. Это также поднимает новые вопросы о том, как лучше всего создавать системы искусственного интеллекта, которые принесут пользу всем.

Рекомендуемые лучшие практики для ИИ

При проектировании систем искусственного интеллекта следует следовать передовым практикам разработки программного обеспечения, уделяя при этом внимание человеку.

подход к МО

Справедливость

Поскольку влияние ИИ возрастает во всех секторах и обществах, крайне важно работать над созданием систем, которые будут справедливыми и инклюзивными для всех.

Интерпретируемость

Понимание систем искусственного интеллекта и доверие к ним важно для обеспечения их правильной работы.

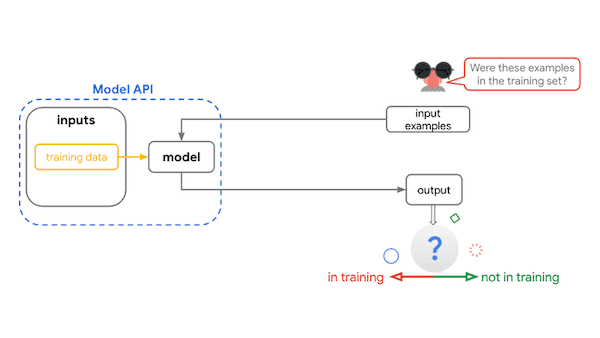

Конфиденциальность

Модели обучения на основе конфиденциальных данных требуют мер по сохранению конфиденциальности

Безопасность

Выявление потенциальных угроз может помочь обеспечить безопасность и надежность систем искусственного интеллекта.

Ответственный ИИ в вашем рабочем процессе машинного обучения

Ответственные практики искусственного интеллекта могут применяться на каждом этапе рабочего процесса машинного обучения. Вот несколько ключевых вопросов, которые следует рассмотреть на каждом этапе.

Для кого предназначена моя система машинного обучения?

То, как реальные пользователи взаимодействуют с вашей системой, важно для оценки истинного влияния ее прогнозов, рекомендаций и решений. Обязательно получите информацию от различных пользователей на ранних этапах процесса разработки.

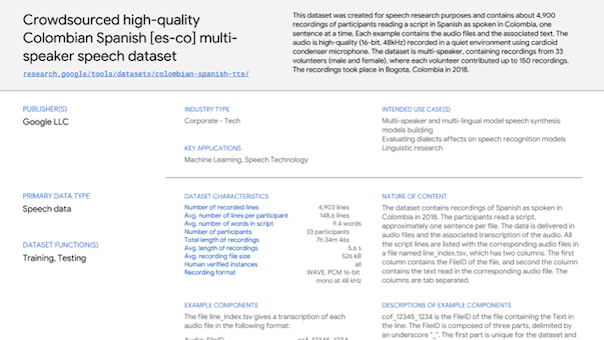

Использую ли я репрезентативный набор данных?

Отбираются ли ваши данные таким образом, чтобы отражать ваших пользователей (например, будут использоваться для всех возрастов, но у вас есть данные об обучении только пожилых людей) и реальные условия (например, будут использоваться круглый год, но у вас есть только обучение? данные за лето)?

Есть ли в моих данных реальная/человеческая предвзятость?

Скрытые искажения в данных могут способствовать возникновению сложных циклов обратной связи, которые укрепляют существующие стереотипы.

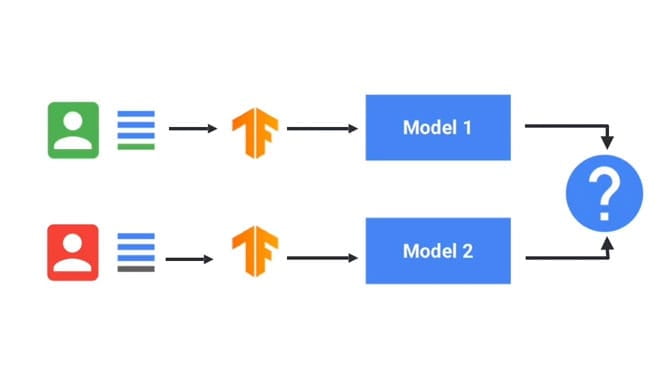

Какие методы следует использовать для обучения моей модели?

Используйте методы обучения, обеспечивающие справедливость, интерпретируемость, конфиденциальность и безопасность модели.

Как работает моя модель?

Оценивайте пользовательский опыт в реальных сценариях для широкого спектра пользователей, вариантов использования и контекстов использования. Сначала тестируйте и тестируйте тестовую версию, а затем продолжайте тестирование после запуска.

Существуют ли сложные петли обратной связи?

Даже если все в общей конструкции системы тщательно продумано, модели на основе машинного обучения редко работают со 100%-ным совершенством при применении к реальным, живым данным. Когда проблема возникает в работающем продукте, подумайте, соответствует ли она каким-либо существующим социальным недостаткам и как на нее повлияют как краткосрочные, так и долгосрочные решения.

Ответственные инструменты искусственного интеллекта для TensorFlow

В экосистеме TensorFlow есть набор инструментов и ресурсов, которые помогут решить некоторые из вышеперечисленных вопросов.

Определить проблему

Используйте следующие ресурсы для разработки моделей с учетом ответственного ИИ.

Узнайте больше о процессе разработки ИИ и основных моментах.

Изучите с помощью интерактивной визуализации ключевые вопросы и концепции в области ответственного ИИ.

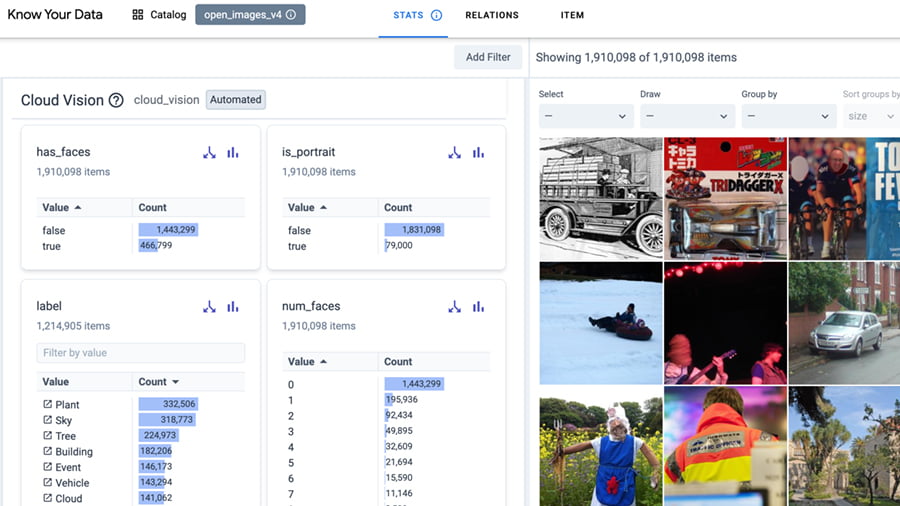

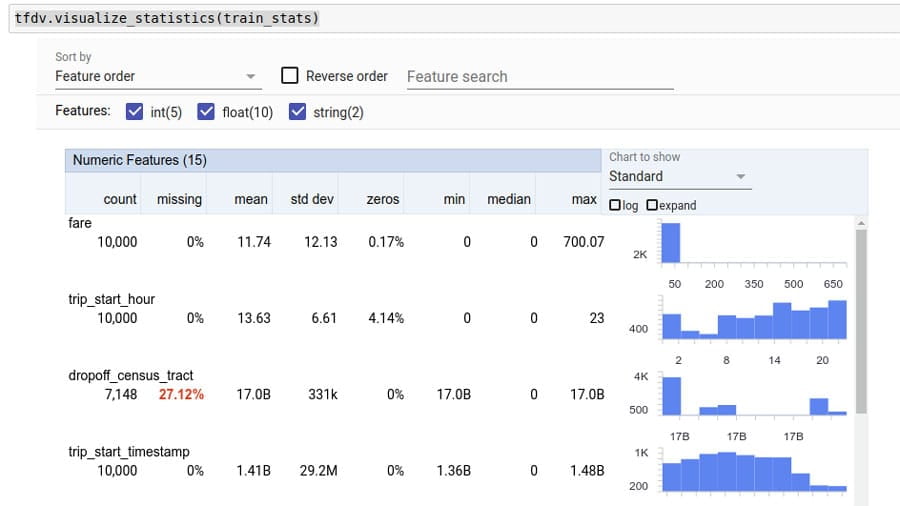

Создайте и подготовьте данные

Используйте следующие инструменты для проверки данных на предмет потенциальных ошибок.

Интерактивно исследуйте свой набор данных, чтобы улучшить качество данных и устранить проблемы справедливости и предвзятости.

Анализируйте и преобразуйте данные для выявления проблем и разработки более эффективных наборов функций.

Более инклюзивная шкала телесных тонов с открытой лицензией, позволяющая сделать сбор данных и построение моделей более надежными и инклюзивными.

Сборка и обучение модели

Используйте следующие инструменты для обучения моделей, используя сохраняющие конфиденциальность, интерпретируемые методы и многое другое.

Обучайте модели машинного обучения для достижения более справедливых результатов.

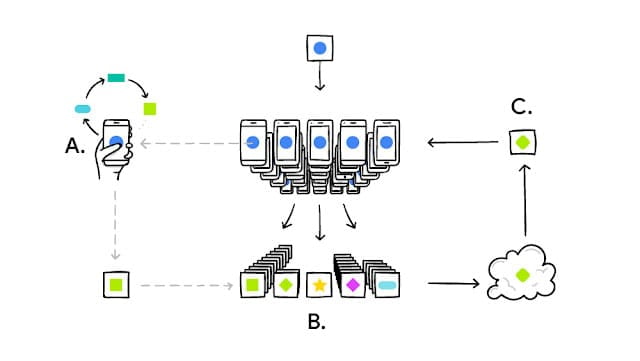

Обучайте модели машинного обучения с соблюдением конфиденциальности.

Обучайте модели машинного обучения, используя методы федеративного обучения.

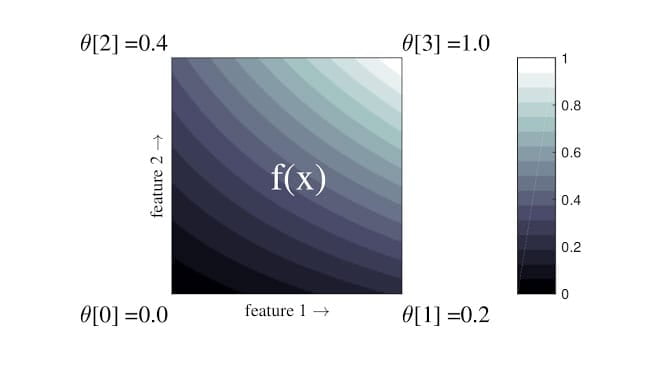

Реализуйте гибкие, контролируемые и интерпретируемые модели на основе решеток.

Оценить модель

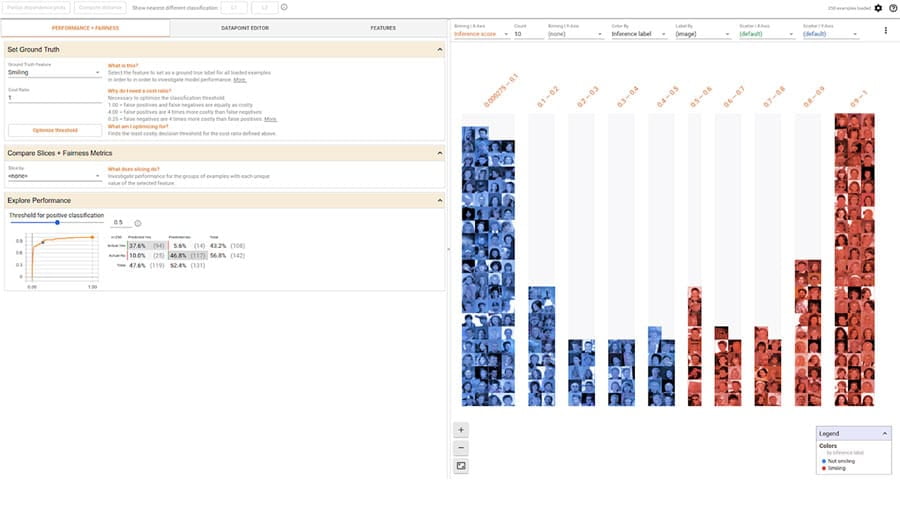

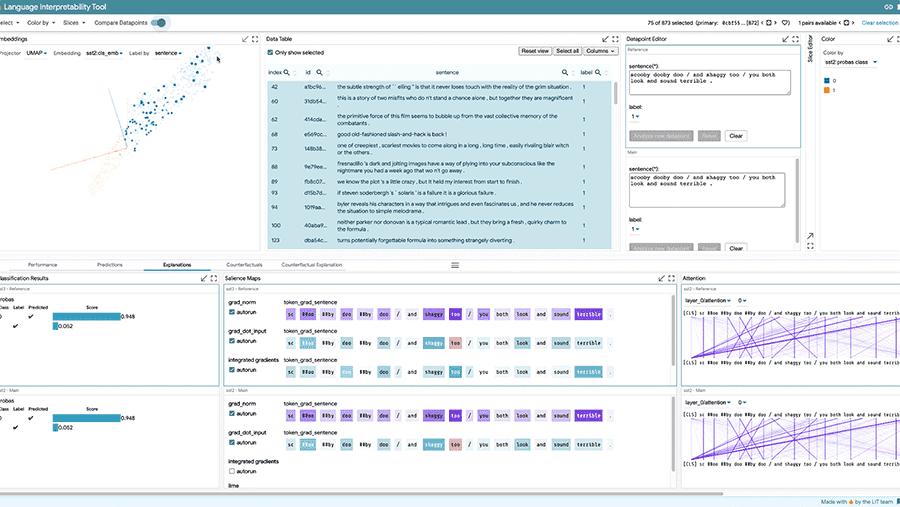

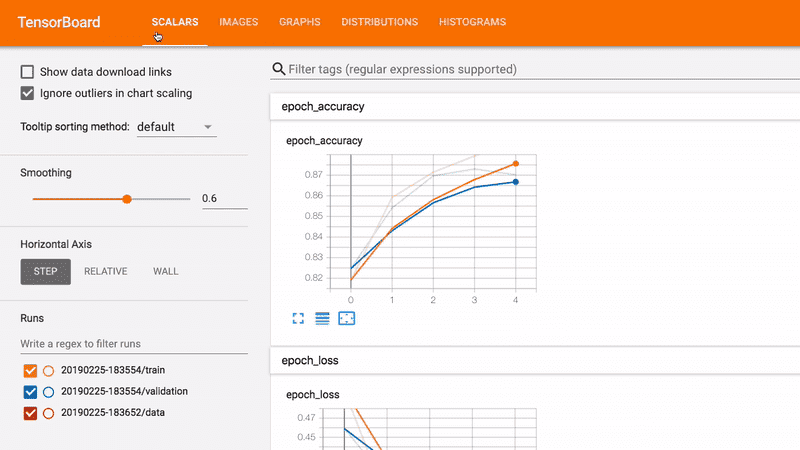

Отлаживайте, оценивайте и визуализируйте производительность модели с помощью следующих инструментов.

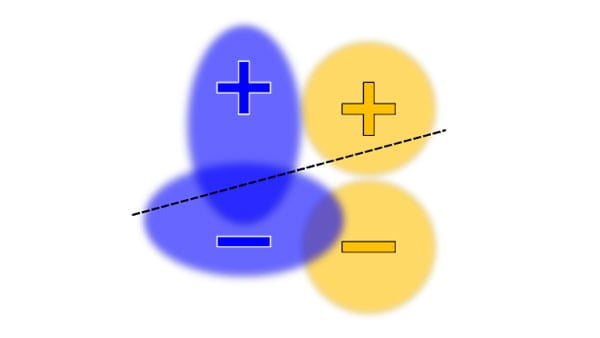

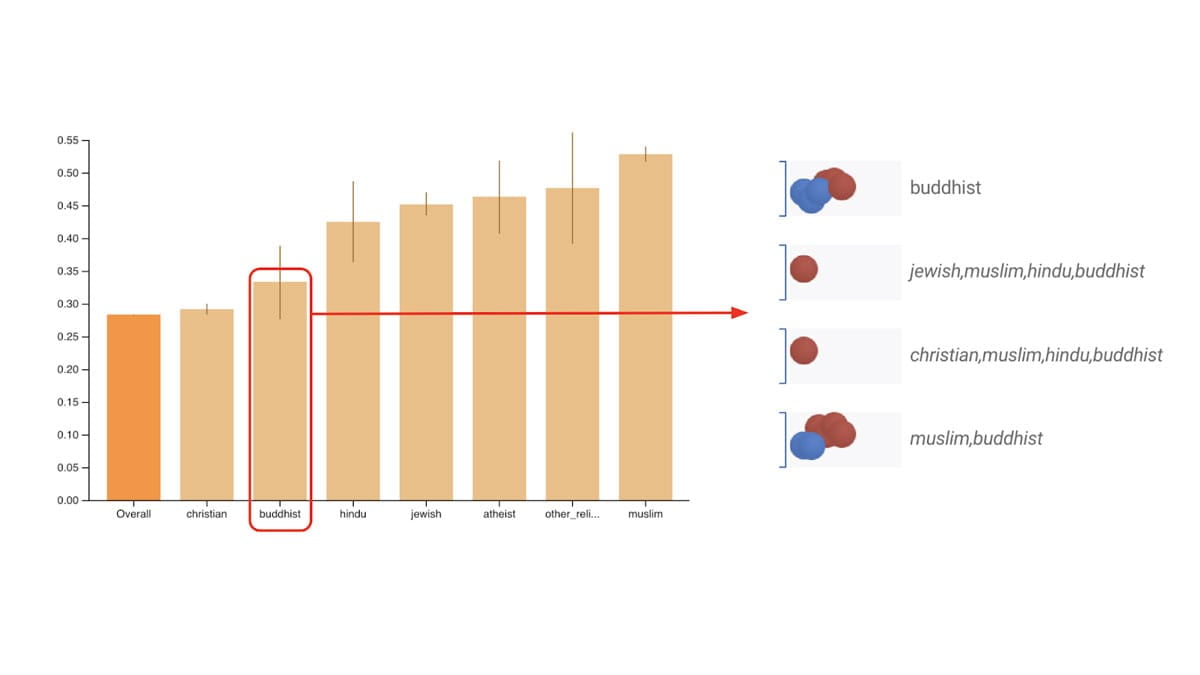

Оцените общеизвестные показатели справедливости для бинарных и многоклассовых классификаторов.

Оценивайте модели распределенным образом и вычисляйте различные фрагменты данных.

Разрабатывайте интерпретируемые и инклюзивные модели машинного обучения.

Оцените свойства конфиденциальности моделей классификации.

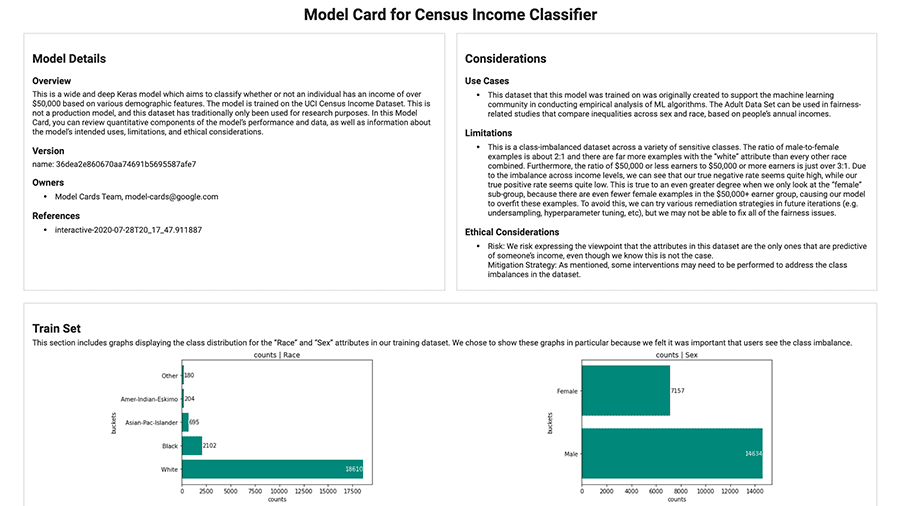

Развертывание и мониторинг

Используйте следующие инструменты для отслеживания и обмена информацией о контексте и деталях модели.

С легкостью создавайте карточки моделей с помощью набора инструментов Model Card.

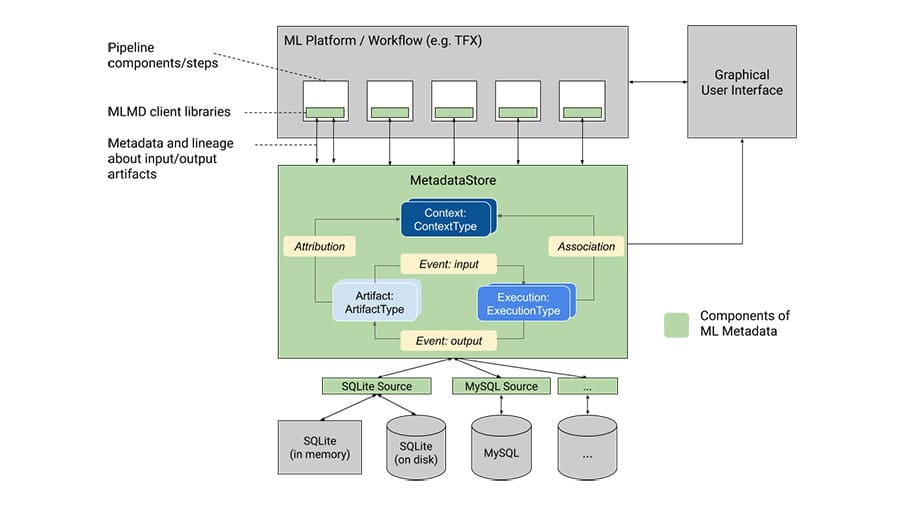

Записывайте и извлекайте метаданные, связанные с рабочими процессами разработчиков машинного обучения и специалистов по данным.

Организуйте основные факты машинного обучения в структурированном виде.

Ресурсы сообщества

Узнайте, чем занимается сообщество, и изучите способы принять в нем участие.

Помогите продуктам Google стать более инклюзивными и отражающими ваш язык, регион и культуру.

Мы попросили участников использовать TensorFlow 2.2 для создания модели или приложения с учетом принципов ответственного ИИ. Посетите галерею, чтобы увидеть победителей и другие потрясающие проекты.

Представляем основу для размышлений об МО, справедливости и конфиденциальности.