Veja no TensorFlow.org Veja no TensorFlow.org |  Executar no Google Colab Executar no Google Colab |  Ver fonte no GitHub Ver fonte no GitHub |  Baixar caderno Baixar caderno |

Ao trabalhar em aplicativos de ML, como detecção de objetos e NLP, às vezes é necessário trabalhar com subseções (fatias) de tensores. Por exemplo, se sua arquitetura de modelo inclui roteamento, onde uma camada pode controlar qual exemplo de treinamento é roteado para a próxima camada. Nesse caso, você pode usar operações de fatiamento de tensor para dividir os tensores e juntá-los novamente na ordem correta.

Em aplicativos de PNL, você pode usar o fatiamento de tensor para realizar o mascaramento de palavras durante o treinamento. Por exemplo, você pode gerar dados de treinamento a partir de uma lista de frases escolhendo um índice de palavras para mascarar em cada frase, retirando a palavra como um rótulo e substituindo a palavra escolhida por um token de máscara.

Neste guia, você aprenderá a usar as APIs do TensorFlow para:

- Extrair fatias de um tensor

- Inserir dados em índices específicos em um tensor

Este guia pressupõe familiaridade com a indexação de tensores. Leia as seções de indexação dos guias Tensor e TensorFlow NumPy antes de começar a usar este guia.

Configurar

import tensorflow as tf

import numpy as np

Extrair fatias de tensor

Execute o fatiamento de tensor do tipo NumPy usando tf.slice .

t1 = tf.constant([0, 1, 2, 3, 4, 5, 6, 7])

print(tf.slice(t1,

begin=[1],

size=[3]))

tf.Tensor([1 2 3], shape=(3,), dtype=int32)

Alternativamente, você pode usar uma sintaxe mais Pythonic. Observe que as fatias de tensor são espaçadas uniformemente em um intervalo de início-parada.

print(t1[1:4])

tf.Tensor([1 2 3], shape=(3,), dtype=int32)

print(t1[-3:])

tf.Tensor([5 6 7], shape=(3,), dtype=int32)

Para tensores bidimensionais, você pode usar algo como:

t2 = tf.constant([[0, 1, 2, 3, 4],

[5, 6, 7, 8, 9],

[10, 11, 12, 13, 14],

[15, 16, 17, 18, 19]])

print(t2[:-1, 1:3])

tf.Tensor( [[ 1 2] [ 6 7] [11 12]], shape=(3, 2), dtype=int32)

Você pode usar tf.slice em tensores de dimensão mais alta também.

t3 = tf.constant([[[1, 3, 5, 7],

[9, 11, 13, 15]],

[[17, 19, 21, 23],

[25, 27, 29, 31]]

])

print(tf.slice(t3,

begin=[1, 1, 0],

size=[1, 1, 2]))

tf.Tensor([[[25 27]]], shape=(1, 1, 2), dtype=int32)

Você também pode usar tf.strided_slice para extrair fatias de tensores 'passando' sobre as dimensões do tensor.

Use tf.gather para extrair índices específicos de um único eixo de um tensor.

print(tf.gather(t1,

indices=[0, 3, 6]))

# This is similar to doing

t1[::3]

tf.Tensor([0 3 6], shape=(3,), dtype=int32) <tf.Tensor: shape=(3,), dtype=int32, numpy=array([0, 3, 6], dtype=int32)>

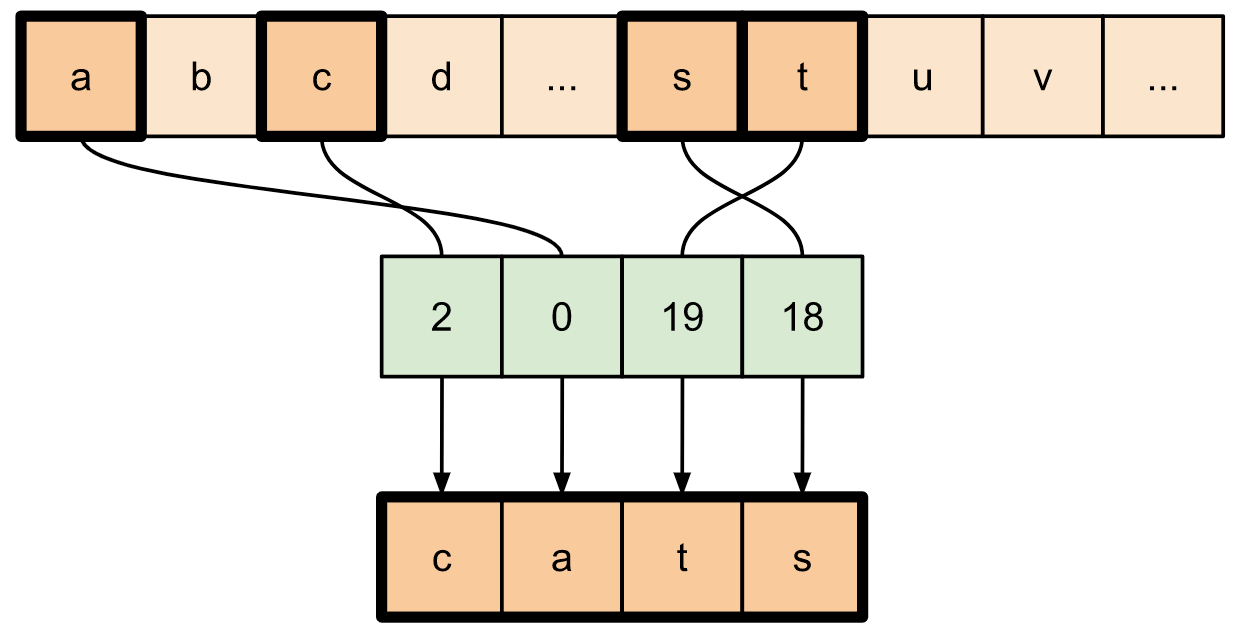

tf.gather não requer que os índices sejam espaçados uniformemente.

alphabet = tf.constant(list('abcdefghijklmnopqrstuvwxyz'))

print(tf.gather(alphabet,

indices=[2, 0, 19, 18]))

tf.Tensor([b'c' b'a' b't' b's'], shape=(4,), dtype=string)

Para extrair fatias de vários eixos de um tensor, use tf.gather_nd . Isso é útil quando você deseja reunir os elementos de uma matriz em vez de apenas suas linhas ou colunas.

t4 = tf.constant([[0, 5],

[1, 6],

[2, 7],

[3, 8],

[4, 9]])

print(tf.gather_nd(t4,

indices=[[2], [3], [0]]))

tf.Tensor( [[2 7] [3 8] [0 5]], shape=(3, 2), dtype=int32)

t5 = np.reshape(np.arange(18), [2, 3, 3])

print(tf.gather_nd(t5,

indices=[[0, 0, 0], [1, 2, 1]]))

tf.Tensor([ 0 16], shape=(2,), dtype=int64)

# Return a list of two matrices

print(tf.gather_nd(t5,

indices=[[[0, 0], [0, 2]], [[1, 0], [1, 2]]]))

tf.Tensor( [[[ 0 1 2] [ 6 7 8]] [[ 9 10 11] [15 16 17]]], shape=(2, 2, 3), dtype=int64)

# Return one matrix

print(tf.gather_nd(t5,

indices=[[0, 0], [0, 2], [1, 0], [1, 2]]))

tf.Tensor( [[ 0 1 2] [ 6 7 8] [ 9 10 11] [15 16 17]], shape=(4, 3), dtype=int64)

Inserir dados em tensores

Use tf.scatter_nd para inserir dados em fatias/índices específicos de um tensor. Observe que o tensor no qual você insere valores é inicializado com zero.

t6 = tf.constant([10])

indices = tf.constant([[1], [3], [5], [7], [9]])

data = tf.constant([2, 4, 6, 8, 10])

print(tf.scatter_nd(indices=indices,

updates=data,

shape=t6))

tf.Tensor([ 0 2 0 4 0 6 0 8 0 10], shape=(10,), dtype=int32)

Métodos como tf.scatter_nd que requerem tensores inicializados com zero, são semelhantes aos inicializadores de tensores esparsos. Você pode usar tf.gather_nd e tf.scatter_nd para imitar o comportamento de operações de tensor esparsas.

Considere um exemplo em que você constrói um tensor esparso usando esses dois métodos em conjunto.

# Gather values from one tensor by specifying indices

new_indices = tf.constant([[0, 2], [2, 1], [3, 3]])

t7 = tf.gather_nd(t2, indices=new_indices)

# Add these values into a new tensor

t8 = tf.scatter_nd(indices=new_indices, updates=t7, shape=tf.constant([4, 5]))

print(t8)

tf.Tensor( [[ 0 0 2 0 0] [ 0 0 0 0 0] [ 0 11 0 0 0] [ 0 0 0 18 0]], shape=(4, 5), dtype=int32)

Isso é semelhante a:

t9 = tf.SparseTensor(indices=[[0, 2], [2, 1], [3, 3]],

values=[2, 11, 18],

dense_shape=[4, 5])

print(t9)

SparseTensor(indices=tf.Tensor( [[0 2] [2 1] [3 3]], shape=(3, 2), dtype=int64), values=tf.Tensor([ 2 11 18], shape=(3,), dtype=int32), dense_shape=tf.Tensor([4 5], shape=(2,), dtype=int64))

# Convert the sparse tensor into a dense tensor

t10 = tf.sparse.to_dense(t9)

print(t10)

tf.Tensor( [[ 0 0 2 0 0] [ 0 0 0 0 0] [ 0 11 0 0 0] [ 0 0 0 18 0]], shape=(4, 5), dtype=int32)

Para inserir dados em um tensor com valores pré-existentes, use tf.tensor_scatter_nd_add .

t11 = tf.constant([[2, 7, 0],

[9, 0, 1],

[0, 3, 8]])

# Convert the tensor into a magic square by inserting numbers at appropriate indices

t12 = tf.tensor_scatter_nd_add(t11,

indices=[[0, 2], [1, 1], [2, 0]],

updates=[6, 5, 4])

print(t12)

tf.Tensor( [[2 7 6] [9 5 1] [4 3 8]], shape=(3, 3), dtype=int32)

Da mesma forma, use tf.tensor_scatter_nd_sub para subtrair valores de um tensor com valores pré-existentes.

# Convert the tensor into an identity matrix

t13 = tf.tensor_scatter_nd_sub(t11,

indices=[[0, 0], [0, 1], [1, 0], [1, 1], [1, 2], [2, 1], [2, 2]],

updates=[1, 7, 9, -1, 1, 3, 7])

print(t13)

tf.Tensor( [[1 0 0] [0 1 0] [0 0 1]], shape=(3, 3), dtype=int32)

Use tf.tensor_scatter_nd_min para copiar valores mínimos elementares de um tensor para outro.

t14 = tf.constant([[-2, -7, 0],

[-9, 0, 1],

[0, -3, -8]])

t15 = tf.tensor_scatter_nd_min(t14,

indices=[[0, 2], [1, 1], [2, 0]],

updates=[-6, -5, -4])

print(t15)

tf.Tensor( [[-2 -7 -6] [-9 -5 1] [-4 -3 -8]], shape=(3, 3), dtype=int32)

Da mesma forma, use tf.tensor_scatter_nd_max para copiar valores máximos por elemento de um tensor para outro.

t16 = tf.tensor_scatter_nd_max(t14,

indices=[[0, 2], [1, 1], [2, 0]],

updates=[6, 5, 4])

print(t16)

tf.Tensor( [[-2 -7 6] [-9 5 1] [ 4 -3 -8]], shape=(3, 3), dtype=int32)

Leitura adicional e recursos

Neste guia, você aprendeu a usar as operações de fatiamento de tensor disponíveis com o TensorFlow para exercer um controle mais preciso sobre os elementos em seus tensores.

Confira as operações de fatiamento disponíveis com o TensorFlow NumPy, como

tf.experimental.numpy.take_along_axisetf.experimental.numpy.take.Confira também o guia Tensor e o guia Variável .