TensorFlow を使用して責任ある AI への取り組みを ML ワークフローに統合する方法をご確認ください

TensorFlow は ML コミュニティとさまざまなリソースやツールを共有することで、責任ある AI 開発の推進に取り組んでいます。

責任ある AI とは

AI 開発により、現実世界の困難な問題を解決する新たなチャンスが生まれています。同時に、誰にとっても有意義な AI システムを構築するための最善の方法に関して、新たに考慮すべき点があります。

AI に関するおすすめのベスト プラクティス

AI システムを設計する際は、ソフトウェア開発のベスト プラクティスに沿って進めつつ、ML に対しては人間中心のアプローチを取る必要があります。

公平さ

さまざまなセクターや社会に AI の影響が広がる今日、誰にとっても公正でインクルーシブなシステムを目指すことが重要です。

解釈可能性

意図したとおりに動作させるには、AI システムを理解し、信頼することが大切です

プライバシー

機密データを使用してモデルをトレーニングする際はプライバシー保護対策が必要です

セキュリティ

潜在的な脅威を特定して、AI システムの安全性を確保できます

ML ワークフローで責任ある AI を

責任ある AI への取り組みは、ML ワークフローのあらゆる段階に組み込めます。各段階で検討すべき重要な点は、以下のとおりです。

システムはどのようなユーザーを対象としているか?

システムによる予測や推奨、決定の持つ真の影響力を評価するためには、実際のユーザーがどのようにシステムを使用しているのかを知ることが重要です。開発の早い段階で、多様なユーザーからフィードバックをもらいましょう。

使用しているデータは代表的なデータセットか?

データのサンプリングは、実際のユーザーに応じて(例: 全年齢層が対象なのに高齢者のトレーニング データしかない)、かつ実際の状況に応じて(例: 年間を通じて使用するのに夏期のトレーニング データしかない)行われていますか?

現実世界や人間のバイアスがデータに含まれていないか?

データの根底にあるバイアスは、既存の固定概念を強化する複雑なフィードバック ループの原因になる可能性があります。

どのような方法でモデルのトレーニングを行えばよいか?

モデルに公平性と解釈可能性をもたらし、プライバシーとセキュリティに配慮したトレーニング方法を選びます。

モデルのパフォーマンスをどのように把握するか?

さまざまなユーザー、ユースケース、使用コンテキストにわたって現実世界のシナリオでのユーザー エクスペリエンスを評価します。まず dogfood でテストを繰り返し実行し、リリース後も継続してテストを行います。

複雑なフィードバック ループが存在していないか?

システムの全体的な設計に細部まで慎重に取り組んだとしても、機械学習モデルを現実世界のデータに適用した場合、100% 完璧に動作することはめったにありません。稼働中のプロダクトに問題が発生した場合は、その問題が、既存の社会的なデメリットと合致するものか、また短期および長期ソリューションによってどのように影響を受けるかを検討してください。

責任ある AI のための TensorFlow 用の各種ツール

TensorFlow エコシステムには、上記の項目に取り組むためのさまざまなツールとリソースがそろっています。

問題の定義

次のリソースを使用して、責任ある AI を念頭に置いたモデルを設計します。

データの作成と準備

次のツールを使用して、データに潜在的なバイアスが含まれていないか調べます。

モデルの構築とトレーニング

次のツールを使用して、わかりやすく、プライバシーに配慮した手法などでモデルをトレーニングします。

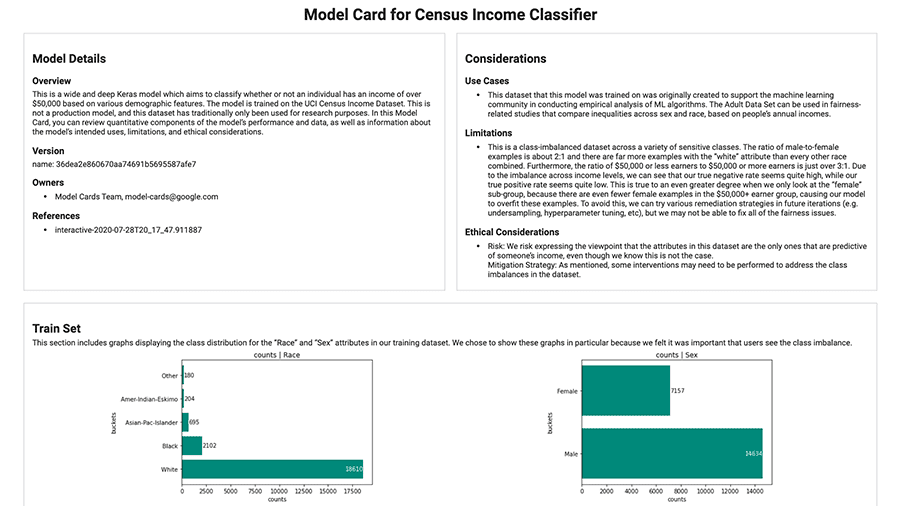

モデルの評価

次のツールを使用して、モデルのパフォーマンスをデバッグ、評価、可視化します。

デプロイとモニタリング

次のツールを使用して、モデルのコンテキストと詳細を追跡し、整理します。

コミュニティ リソース

コミュニティの活動内容と参加方法についてご確認ください。

参加者に TensorFlow 2.2 を使って、責任ある AI の原則を踏まえたモデルやアプリケーションを構築してもらいました。ギャラリーで、受賞者や素晴らしいプロジェクトをチェックしてみましょう。