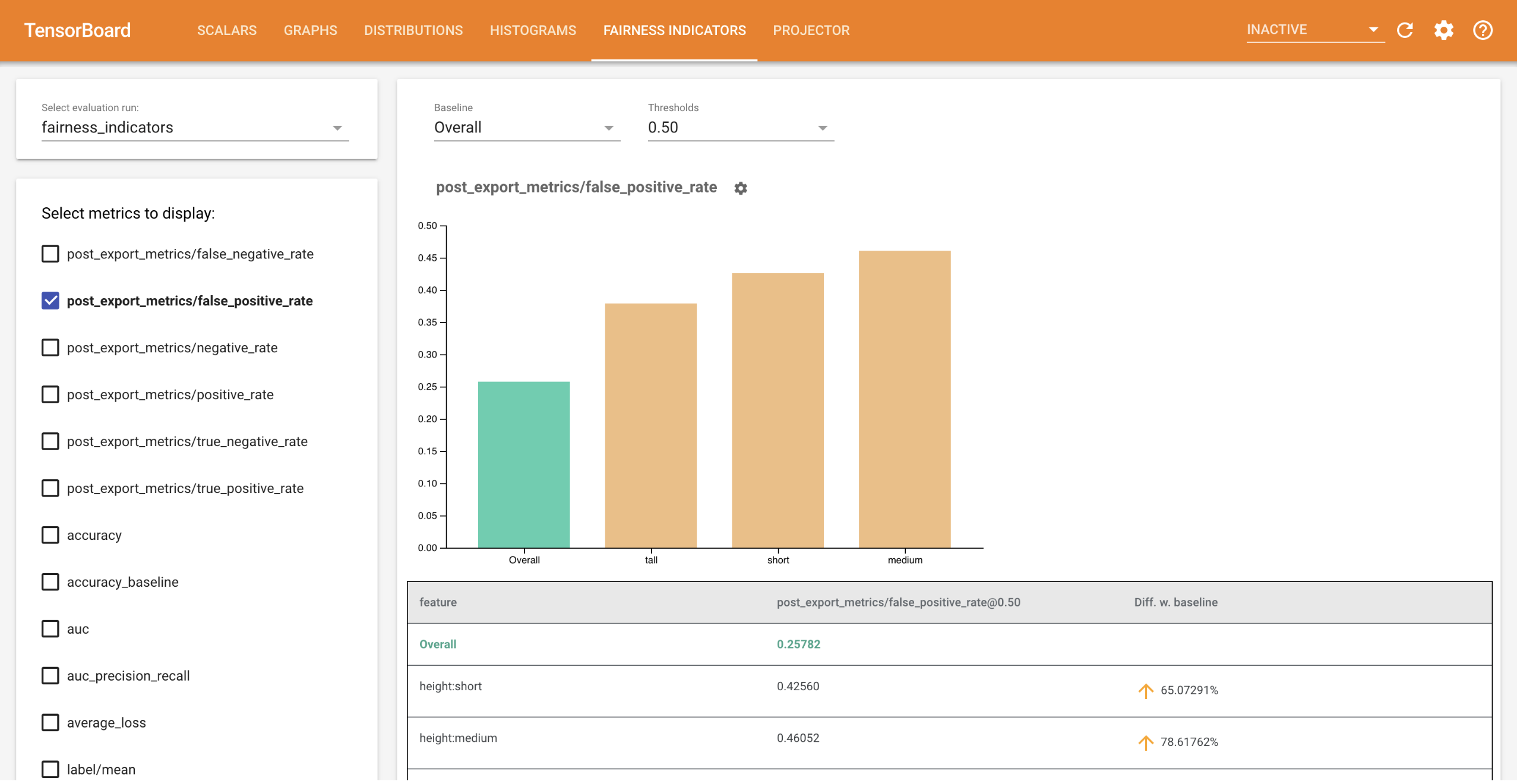

TensorBoard için Adillik Göstergeleri, ikili ve çok sınıflı sınıflandırıcılar için yaygın olarak tanımlanan adalet metriklerinin kolay hesaplanmasını sağlar. Eklentiyle koşularınız için adalet değerlendirmelerini görselleştirebilir ve gruplar arasındaki performansı kolayca karşılaştırabilirsiniz.

Özellikle TensorBoard için Adillik Göstergeleri, tanımlanmış kullanıcı gruplarına göre model performansını değerlendirmenize ve görselleştirmenize olanak tanır. Güven aralıkları ve çoklu eşiklerdeki değerlendirmelerle sonuçlarınızdan emin olun.

Adillik endişelerini değerlendirmeye yönelik mevcut araçların çoğu, büyük ölçekli veri kümeleri ve modellerde iyi çalışmıyor. Google olarak milyarlarca kullanıcılı sistemlerde çalışabilecek araçlara sahip olmak bizim için önemli. Adillik Göstergeleri, TensorBoard ortamında veya Colab'da her boyuttaki kullanım durumunu değerlendirmenize olanak tanır.

Gereksinimler

TensorBoard için Adillik Göstergelerini yüklemek için şunu çalıştırın:

python3 -m virtualenv ~/tensorboard_demo

source ~/tensorboard_demo/bin/activate

pip install --upgrade pip

pip install fairness_indicators

pip install tensorboard-plugin-fairness-indicators

Demo

TensorBoard'daki Adillik Göstergelerini test etmek istiyorsanız, aşağıdaki komutu kullanarak örnek TensorFlow Model Analizi değerlendirme sonuçlarını (eval_config.json, metrikler ve çizimler dosyaları) ve bir demo.py yardımcı programını Google Cloud Platform'dan indirebilirsiniz.

pip install gsutil

gsutil cp -r gs://tensorboard_plugin_fairness_indicators/ .

İndirilen dosyaları içeren dizine gidin.

cd tensorboard_plugin_fairness_indicators

Bu değerlendirme verileri, Tensorflow Model Analizi'nin model_eval_lib kütüphanesi kullanılarak hesaplanan Civil Comments veri setine dayanmaktadır. Ayrıca referans olması açısından örnek bir TensorBoard özet veri dosyası içerir.

demo.py yardımcı programı, Adillik Göstergeleri kontrol panelini oluşturmak için TensorBoard tarafından okunacak olan bir TensorBoard özet veri dosyası yazar (Özet veri dosyaları hakkında daha fazla bilgi için TensorBoard eğitimine bakın).

demo.py yardımcı programıyla kullanılacak bayraklar:

-

--logdir: TensorBoard'un özeti yazacağı dizin -

--eval_result_output_dir: TFMA tarafından değerlendirilen değerlendirme sonuçlarını içeren dizin (son adımda indirildi)

Özet sonuçları günlük dizinine yazmak için demo.py yardımcı programını çalıştırın:

python demo.py --logdir=. --eval_result_output_dir=.

TensorBoard'u çalıştırın:

tensorboard --logdir=.

Bu yerel bir örneği başlatacaktır. Yerel örnek başlatıldıktan sonra terminale bir bağlantı görüntülenecektir. Adillik Göstergeleri kontrol panelini görüntülemek için bağlantıyı tarayıcınızda açın.

Demo Colab'ı

Fairness_Indicators_TensorBoard_Plugin_Example_Colab.ipynb , bir modeli eğitmek ve değerlendirmek ve adalet değerlendirme sonuçlarını TensorBoard'da görselleştirmek için uçtan uca bir demo içerir.

Kullanım

Adillik Göstergelerini kendi verileriniz ve değerlendirmelerinizle kullanmak için:

Yeni bir model eğitin ve model_eval_lib içindeki

tensorflow_model_analysis.run_model_analysisveyatensorflow_model_analysis.ExtractEvaluateAndWriteResultAPI'sini kullanarak değerlendirin. Bunun nasıl yapılacağına ilişkin kod parçacıkları için buradaki Adillik Göstergeleri ortak çalışmasına bakın.tensorboard_plugin_fairness_indicators.summary_v2API'sini kullanarak Adillik Göstergeleri Özeti yazın.writer = tf.summary.create_file_writer(<logdir>) with writer.as_default(): summary_v2.FairnessIndicators(<eval_result_dir>, step=1) writer.close()TensorBoard'u çalıştırın

-

tensorboard --logdir=<logdir> - Sonuçları görselleştirmek için kontrol panelinin sol tarafındaki açılır menüyü kullanarak yeni değerlendirme çalışmasını seçin.

-