- 説明:

NYU-Depth V2 データ セットは、Microsoft Kinect の RGB カメラと Depth カメラの両方で記録されたさまざまな屋内シーンのビデオ シーケンスで構成されています。

追加のドキュメント:コードを使用したペーパーの探索

ホームページ: https://cs.nyu.edu/~silberman/datasets/nyu_depth_v2.html

バージョン:

-

0.0.1(デフォルト): リリース ノートはありません。

-

ダウンロードサイズ:

31.92 GiBデータセットサイズ:

74.03 GiB自動キャッシュ(ドキュメント): いいえ

スプリット:

| スプリット | 例 |

|---|---|

'train' | 47,584 |

'validation' | 654 |

- 機能構造:

FeaturesDict({

'depth': Tensor(shape=(480, 640), dtype=float16),

'image': Image(shape=(480, 640, 3), dtype=uint8),

})

- 機能のドキュメント:

| 特徴 | クラス | 形 | Dtype | 説明 |

|---|---|---|---|---|

| 特徴辞書 | ||||

| 深さ | テンソル | (480、640) | float16 | |

| 画像 | 画像 | (480、640、3) | uint8 |

監視されたキー(

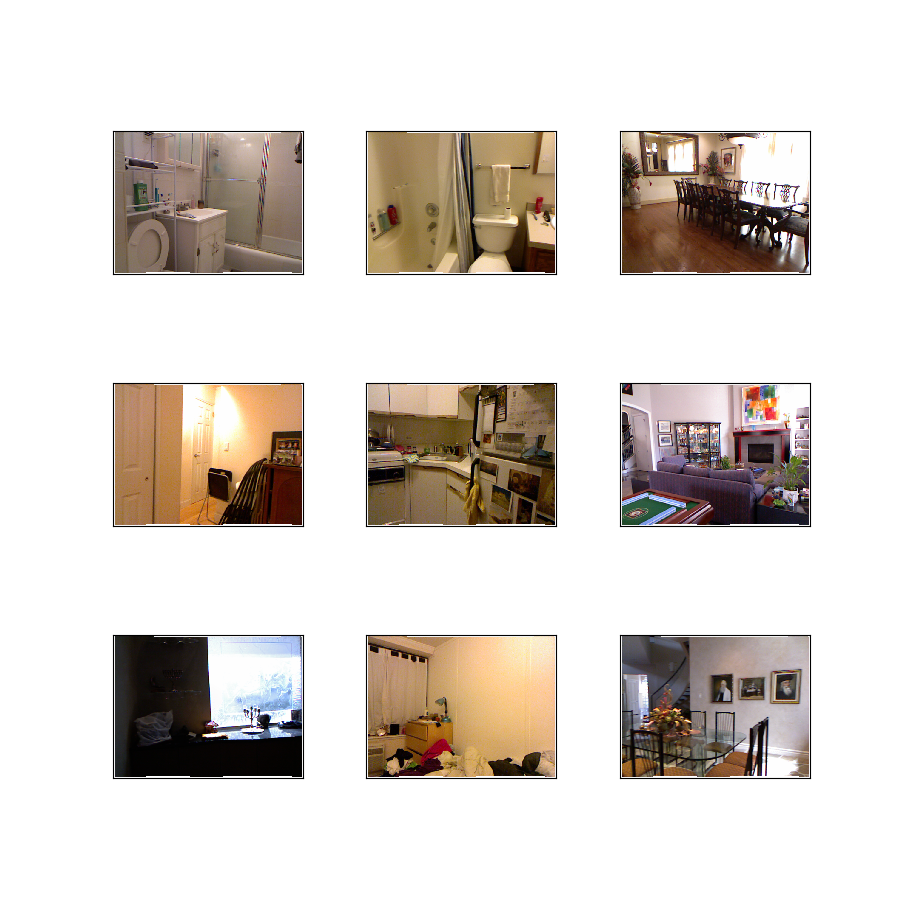

as_superviseddocを参照):('image', 'depth')図( tfds.show_examples ):

- 例( tfds.as_dataframe ):

- 引用:

@inproceedings{Silberman:ECCV12,

author = {Nathan Silberman, Derek Hoiem, Pushmeet Kohli and Rob Fergus},

title = {Indoor Segmentation and Support Inference from RGBD Images},

booktitle = {ECCV},

year = {2012}

}

@inproceedings{icra_2019_fastdepth,

author = {Wofk, Diana and Ma, Fangchang and Yang, Tien-Ju and Karaman, Sertac and Sze, Vivienne},

title = {FastDepth: Fast Monocular Depth Estimation on Embedded Systems},

booktitle = {IEEE International Conference on Robotics and Automation (ICRA)},

year = {2019}

}