- 説明:

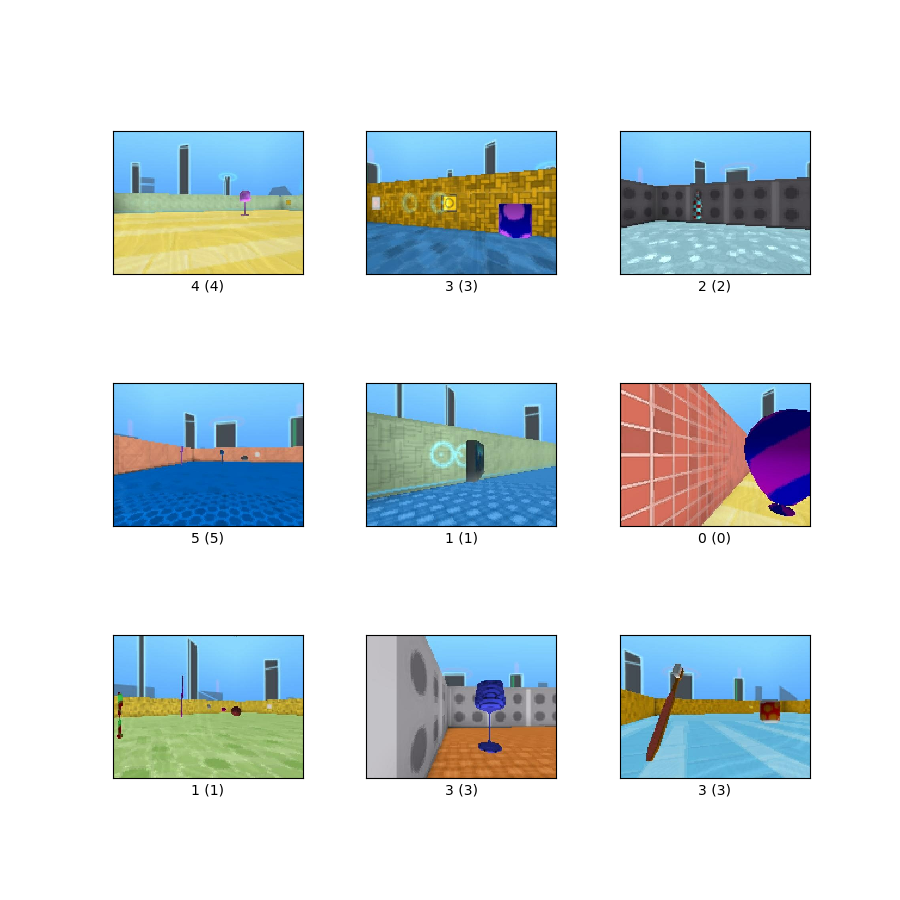

Dmlab データセットには、DeepMind Lab 環境で動作するエージェントによって観察されたフレームが含まれており、エージェントと環境内に存在するさまざまなオブジェクトとの間の距離によって注釈が付けられます。目標は、3D 環境における視覚入力からの距離を推論する視覚モデルの能力を評価することです。 Dmlab データセットは、6 つのクラスの 360x480 カラー画像で構成されています。クラスはそれぞれ、{近い、遠い、非常に遠い} x {正の報酬、負の報酬} です。

ソースコード:

tfds.image_classification.Dmlabバージョン:

-

2.0.1(デフォルト): リリース ノートはありません。

-

ダウンロードサイズ:

2.81 GiBデータセットのサイズ:

3.13 GiB自動キャッシュ(ドキュメント): いいえ

分割:

| スプリット | 例 |

|---|---|

'test' | 22,735 |

'train' | 65,550 |

'validation' | 22,628 |

- 機能の構造:

FeaturesDict({

'filename': Text(shape=(), dtype=string),

'image': Image(shape=(360, 480, 3), dtype=uint8),

'label': ClassLabel(shape=(), dtype=int64, num_classes=6),

})

- 機能ドキュメント:

| 特徴 | クラス | 形 | Dタイプ | 説明 |

|---|---|---|---|---|

| 特徴辞書 | ||||

| ファイル名 | 文章 | 弦 | ||

| 画像 | 画像 | (360、480、3) | uint8 | |

| ラベル | クラスラベル | int64 |

監視キー(

as_superviseddoc を参照):('image', 'label')図( tfds.show_examples ):

- 例( tfds.as_dataframe ):

- 引用:

@article{zhai2019visual,

title={The Visual Task Adaptation Benchmark},

author={Xiaohua Zhai and Joan Puigcerver and Alexander Kolesnikov and

Pierre Ruyssen and Carlos Riquelme and Mario Lucic and

Josip Djolonga and Andre Susano Pinto and Maxim Neumann and

Alexey Dosovitskiy and Lucas Beyer and Olivier Bachem and

Michael Tschannen and Marcin Michalski and Olivier Bousquet and

Sylvain Gelly and Neil Houlsby},

year={2019},

eprint={1910.04867},

archivePrefix={arXiv},

primaryClass={cs.CV},

url = {https://arxiv.org/abs/1910.04867}

}