- 説明:

Google RefExp データセットは、公開されている MS-COCO データセットに基づいて構築された、画像内のオブジェクトのテキスト説明のコレクションです。 MS-COCO の画像キャプションは画像全体に適用されますが、このデータセットは、画像内の単一のオブジェクトまたは領域を一意に識別できるようにするテキストの説明に焦点を当てています。詳細については、このホワイト ペーパーの「明確なオブジェクト記述の生成と理解」を参照してください。

追加のドキュメント:コードを使用したペーパーの探索

ソース コード:

tfds.vision_language.gref.Grefバージョン:

-

1.0.0(デフォルト): 初期リリース。

-

ダウンロードサイズ: サイズ

Unknown sizeデータセットサイズ:

4.60 GiB手動ダウンロードの手順: このデータセットでは、ソース データを手動で

download_config.manual_dir(デフォルトは~/tensorflow_datasets/downloads/manual/) にダウンロードする必要があります。

https://github.com/mjhucla/Google_Refexp_toolboxの指示に従って、データをダウンロードし、COCO に合わせた形式に前処理します。ディレクトリには、2 つのファイルと 1 つのフォルダーが含まれています。google_refexp_train_201511_coco_aligned_catg.json

google_refexp_val_201511_coco_aligned_catg.json

coco_train2014/

coco_train2014 フォルダーには、すべての COCO 2014 トレーニング イメージが含まれています。

自動キャッシュ(ドキュメント): いいえ

スプリット:

| スプリット | 例 |

|---|---|

'train' | 24,698 |

'validation' | 4,650 |

- 機能構造:

FeaturesDict({

'image': Image(shape=(None, None, 3), dtype=uint8),

'image/id': int64,

'objects': Sequence({

'area': int64,

'bbox': BBoxFeature(shape=(4,), dtype=float32),

'id': int64,

'label': int64,

'label_name': ClassLabel(shape=(), dtype=int64, num_classes=80),

'refexp': Sequence({

'raw': Text(shape=(), dtype=string),

'referent': Text(shape=(), dtype=string),

'refexp_id': int64,

'tokens': Sequence(Text(shape=(), dtype=string)),

}),

}),

})

- 機能のドキュメント:

| 特徴 | クラス | 形 | Dtype | 説明 |

|---|---|---|---|---|

| 特徴辞書 | ||||

| 画像 | 画像 | (なし、なし、3) | uint8 | |

| 画像/ID | テンソル | int64 | ||

| オブジェクト | 順序 | |||

| オブジェクト/エリア | テンソル | int64 | ||

| オブジェクト/bbox | BBoxFeature | (4) | float32 | |

| オブジェクト/ID | テンソル | int64 | ||

| オブジェクト/ラベル | テンソル | int64 | ||

| オブジェクト/ラベル名 | クラスラベル | int64 | ||

| オブジェクト/refexp | 順序 | |||

| オブジェクト/refexp/生 | 文章 | ストリング | ||

| オブジェクト/refexp/リファレント | 文章 | ストリング | ||

| オブジェクト/refexp/refexp_id | テンソル | int64 | ||

| オブジェクト/refexp/トークン | シーケンス(テキスト) | (なし、) | ストリング |

監視されたキー(

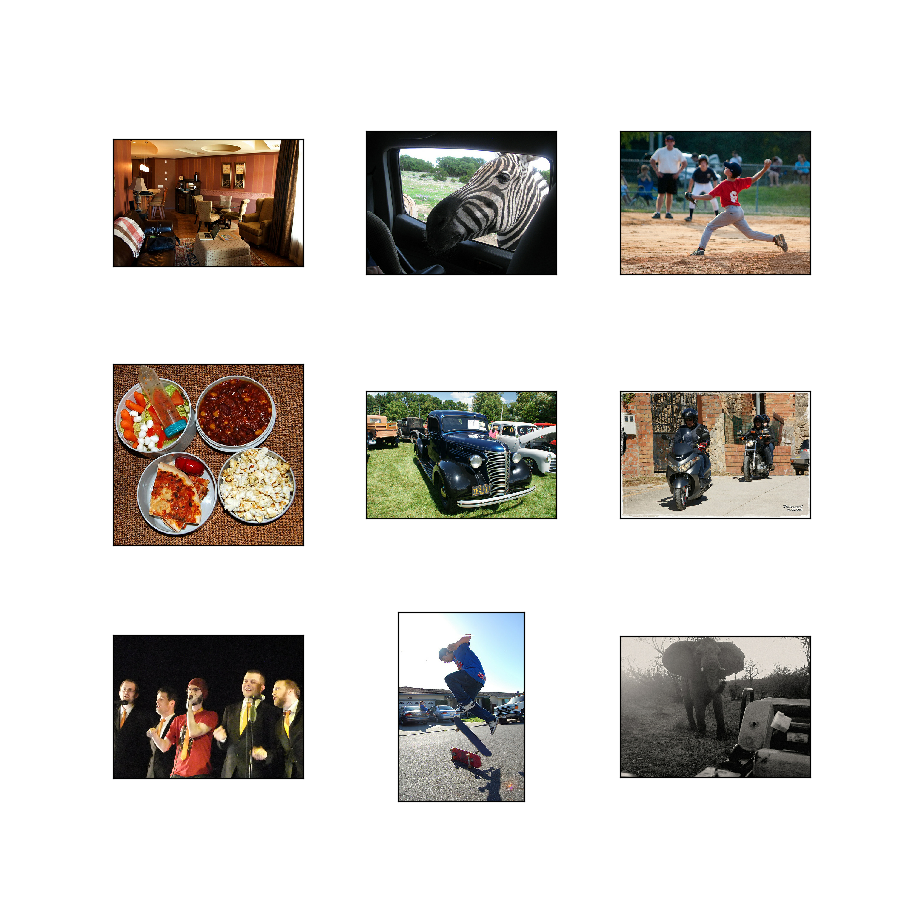

as_superviseddocを参照):None図( tfds.show_examples ):

- 例( tfds.as_dataframe ):

- 引用:

@inproceedings{mao2016generation,

title={Generation and Comprehension of Unambiguous Object Descriptions},

author={Mao, Junhua and Huang, Jonathan and Toshev, Alexander and Camburu, Oana and Yuille, Alan and Murphy, Kevin},

booktitle={CVPR},

year={2016}

}