- 説明:

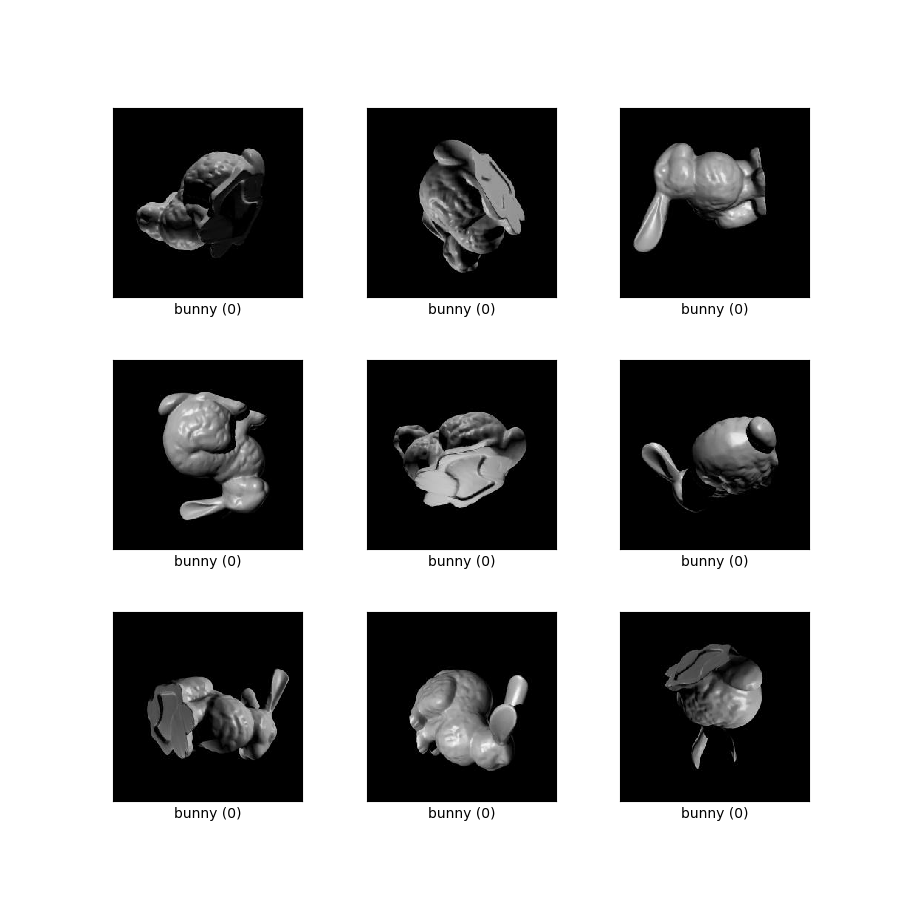

このデータセットは、論文「 Disentangling by Subspace Diffusion 」の「Stanford 3D Objects」セクションで最初に説明されました。データは、スタンフォード 3D スキャン リポジトリからのバニー オブジェクトとドラゴン オブジェクトのそれぞれ 100,000 レンダリングで構成されます。将来さらに多くのオブジェクトが追加される可能性がありますが、本稿ではバニーとドラゴンのみが使用されています。各オブジェクトは、2 球上の点から均一にサンプリングされた照明と、均一にサンプリングされた 3D 回転を使用してレンダリングされます。真の潜在状態は、画像とともに NumPy 配列として提供されます。照明は単位ノルムを持つ 3 ベクトルとして与えられ、回転は四元数と 3x3 直交行列の両方として与えられます。

S3O4D と、 NORB 、 3D 椅子、 3D シェイプなどの既存の ML ベンチマーク データセットとの間には多くの類似点があり、さまざまなポーズや照明条件下での一連のオブジェクトのレンダリングも含まれます。ただし、これらの既存のデータセットには 3D の回転の完全な多様体が含まれておらず、ほとんどのデータセットには高度と方位角の変更のサブセットのみが含まれています。 S3O4D 画像は、回転と照明の空間全体から均一かつ独立してサンプリングされます。つまり、データセットには、逆さまで後ろまたは下から照明されたオブジェクトが含まれています。このため、S3O4D は、潜在空間が非自明なトポロジーを持つ生成モデルの研究や、多様体の曲率が重要となる一般的な多様体学習手法に独自に適していると考えられます。

追加ドキュメント:コード付きの論文について調べる

ソースコード:

tfds.datasets.s3o4d.Builderバージョン:

-

1.0.0(デフォルト): 初期リリース。

-

ダウンロードサイズ:

911.68 MiBデータセットのサイズ:

1.01 GiB自動キャッシュ(ドキュメント): いいえ

分割:

| スプリット | 例 |

|---|---|

'bunny_test' | 20,000 |

'bunny_train' | 80,000 |

'dragon_test' | 20,000 |

'dragon_train' | 80,000 |

- 機能の構造:

FeaturesDict({

'illumination': Tensor(shape=(3,), dtype=float32),

'image': Image(shape=(256, 256, 3), dtype=uint8),

'label': ClassLabel(shape=(), dtype=int64, num_classes=2),

'pose_mat': Tensor(shape=(3, 3), dtype=float32),

'pose_quat': Tensor(shape=(4,), dtype=float32),

})

- 機能ドキュメント:

| 特徴 | クラス | 形 | Dタイプ | 説明 |

|---|---|---|---|---|

| 特徴辞書 | ||||

| イルミネーション | テンソル | (3,) | float32 | |

| 画像 | 画像 | (256, 256, 3) | uint8 | |

| ラベル | クラスラベル | int64 | ||

| ポーズマット | テンソル | (3, 3) | float32 | |

| ポーズクワット | テンソル | (4,) | float32 |

監視キー(

as_superviseddocを参照):None図( tfds.show_examples ):

- 例( tfds.as_dataframe ):

- 引用:

@article{pfau2020disentangling,

title={Disentangling by Subspace Diffusion},

author={Pfau, David and Higgins, Irina and Botev, Aleksandar and Racani\`ere,

S{\'e}bastian},

journal={Advances in Neural Information Processing Systems (NeurIPS)},

year={2020}

}