- Описание :

PASS — это крупномасштабный набор данных изображений, который не включает в себя людей, части тела или другую личную информацию. Его можно использовать для высококачественного предварительного обучения с самоконтролем, значительно снижая при этом проблемы конфиденциальности.

PASS содержит 1 439 589 изображений без каких-либо меток, полученных из YFCC-100M.

Все изображения в этом наборе данных, как и сам набор данных, лицензированы по лицензии CC-BY. Информацию о YFCC-100M см. на http://www.multimediacommons.org/.

Дополнительная документация : Изучите статьи с кодом

Домашняя страница : https://www.robots.ox.ac.uk/~vgg/data/pass/

Исходный код :

tfds.datasets.pass.BuilderВерсии :

-

1.0.0: Начальная версия. -

2.0.0: v2: Удалены 472 изображения из v1, так как на них были люди. Также добавлены метаданные: дата и GPS. -

3.0.0(по умолчанию): v3: из версии 2 удалено 131 изображение, поскольку они содержали людей/татуировки.

-

Размер загрузки :

167.30 GiBРазмер набора данных :

166.43 GiBАвтокэширование ( документация ): Нет

Расколы :

| Расколоть | Примеры |

|---|---|

'train' | 1 439 588 |

- Структура функции :

FeaturesDict({

'image': Image(shape=(None, None, 3), dtype=uint8),

'image/creator_uname': Text(shape=(), dtype=string),

'image/date_taken': Text(shape=(), dtype=string),

'image/gps_lat': float32,

'image/gps_lon': float32,

'image/hash': Text(shape=(), dtype=string),

})

- Функциональная документация :

| Особенность | Сорт | Форма | Дтип | Описание |

|---|---|---|---|---|

| ВозможностиDict | ||||

| изображение | Изображение | (Нет, Нет, 3) | uint8 | |

| изображение/имя_создателя | Текст | нить | ||

| изображение/дата_снимка | Текст | нить | ||

| изображение/gps_lat | Тензор | поплавок32 | ||

| изображение/gps_lon | Тензор | поплавок32 | ||

| изображение/хеш | Текст | нить |

Контролируемые ключи (см. документ

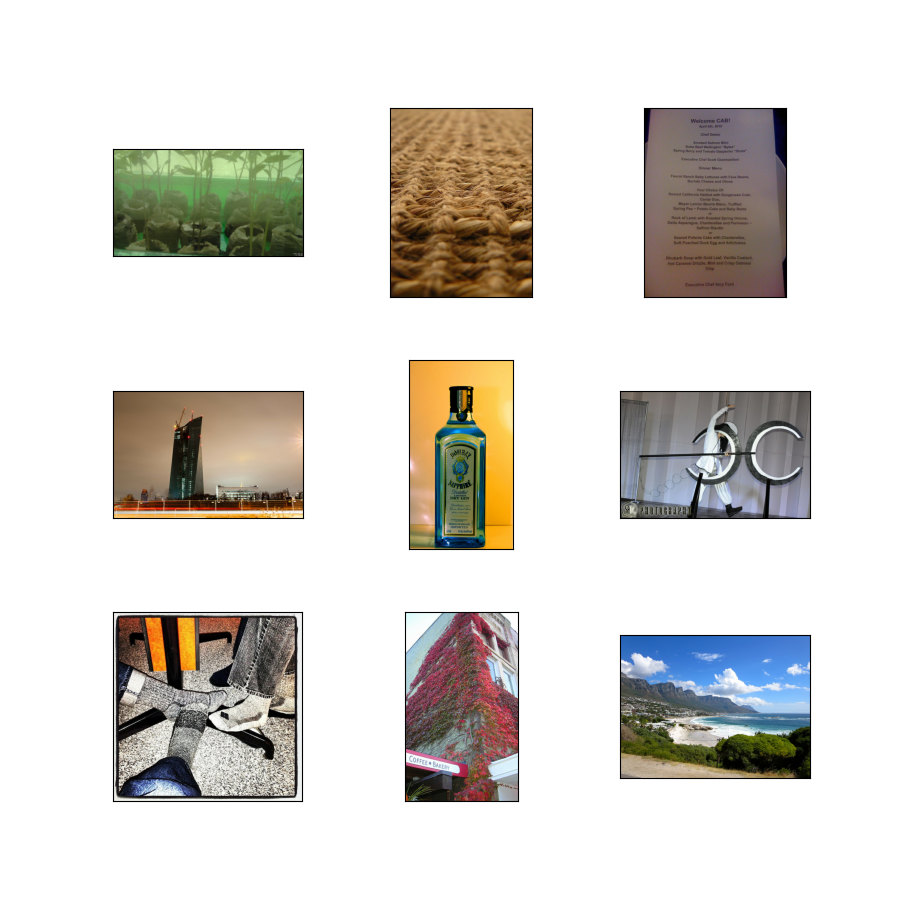

as_supervised):NoneРисунок ( tfds.show_examples ):

- Примеры ( tfds.as_dataframe ):

- Цитата :

@Article{asano21pass,

author = "Yuki M. Asano and Christian Rupprecht and Andrew Zisserman and Andrea Vedaldi",

title = "PASS: An ImageNet replacement for self-supervised pretraining without humans",

journal = "NeurIPS Track on Datasets and Benchmarks",

year = "2021"

}