- Descripción :

Una colección de 3 conjuntos de datos de expresiones de referencia basados en imágenes del conjunto de datos COCO. Una expresión de referencia es un fragmento de texto que describe un objeto único en una imagen. Estos conjuntos de datos se recopilan pidiendo a evaluadores humanos que eliminen la ambigüedad de los objetos delineados por cuadros delimitadores en el conjunto de datos COCO.

RefCoco y RefCoco+ son de Kazemzadeh et al. 2014. Las expresiones de RefCoco+ son descripciones estrictamente basadas en la apariencia, que impusieron impidiendo que los evaluadores usaran descripciones basadas en la ubicación (por ejemplo, "persona a la derecha" no es una descripción válida para RefCoco+). RefCocoG es de Mao et al. 2016, y tiene una descripción más rica de objetos en comparación con RefCoco debido a diferencias en el proceso de anotación. En particular, RefCoco se recopiló en un entorno interactivo basado en juegos, mientras que RefCocoG se recopiló en un entorno no interactivo. En promedio, RefCocoG tiene 8,4 palabras por expresión, mientras que RefCoco tiene 3,5 palabras.

Cada conjunto de datos tiene diferentes asignaciones divididas que normalmente se informan en artículos. Los conjuntos "testA" y "testB" en RefCoco y RefCoco+ contienen solo personas y no personas respectivamente. Las imágenes se dividen en distintas divisiones. En la división "google", los objetos, no las imágenes, se dividen entre las divisiones tren y no tren. Esto significa que la misma imagen puede aparecer tanto en el tren como en la división de validación, pero los objetos a los que se hace referencia en la imagen serán diferentes entre los dos conjuntos. Por el contrario, "unc" y "umd" dividen las imágenes de partición entre la división de tren, validación y prueba. En RefCocoG, la división "google" no tiene un conjunto de pruebas canónico y el conjunto de validación normalmente se informa en los artículos como "val*".

Estadísticas para cada conjunto de datos y división ("refs" es el número de expresiones de referencia e "imágenes" es el número de imágenes):

| conjunto de datos | dividir | dividir | árbitros | imágenes |

|---|---|---|---|---|

| refcoco | tren | 40000 | 19213 | |

| refcoco | vale | 5000 | 4559 | |

| refcoco | prueba | 5000 | 4527 | |

| refcoco | tío | tren | 42404 | 16994 |

| refcoco | tío | vale | 3811 | 1500 |

| refcoco | tío | pruebaA | 1975 | 750 |

| refcoco | tío | pruebaB | 1810 | 750 |

| refcoco+ | tío | tren | 42278 | 16992 |

| refcoco+ | tío | vale | 3805 | 1500 |

| refcoco+ | tío | pruebaA | 1975 | 750 |

| refcoco+ | tío | pruebaB | 1798 | 750 |

| refcocog | tren | 44822 | 24698 | |

| refcocog | vale | 5000 | 4650 | |

| refcocog | umd | tren | 42226 | 21899 |

| refcocog | umd | vale | 2573 | 1300 |

| refcocog | umd | prueba | 5023 | 2600 |

Documentación adicional : Explorar en artículos con código

Página de inicio : https://github.com/lichengunc/refer

Código fuente :

tfds.datasets.ref_coco.BuilderVersiones :

-

1.0.0: versión inicial. -

1.1.0(predeterminado): máscaras agregadas.

-

Tamaño de descarga :

Unknown sizeInstrucciones de descarga manual : este conjunto de datos requiere que descargue los datos de origen manualmente en

download_config.manual_dir(el valor predeterminado es~/tensorflow_datasets/downloads/manual/):Siga las instrucciones en https://github.com/lichengunc/refer y descargue las anotaciones y las imágenes, que coincidan con el directorio data/ especificado en el repositorio.

Siga las instrucciones de PythonAPI en https://github.com/cocodataset/cocoapi para obtener pycocotools y el archivo de anotaciones instancias_train2014 de https://cocodataset.org/#download

Agregue refer.py de (1) y pycocotools de (2) a su PYTHONPATH.

Ejecute manual_download_process.py para generar refcoco.json, reemplazando

ref_data_root,coco_annotations_fileyout_filecon los valores correspondientes a dónde descargó o desea guardar estos archivos. Tenga en cuenta que manual_download_process.py se puede encontrar en el repositorio TFDS.Descargue el conjunto de capacitación COCO desde https://cocodataset.org/#download y péguelo en una carpeta llamada

coco_train2014/. Muevarefcoco.jsonal mismo nivel quecoco_train2014.Siga las instrucciones de descarga del manual estándar.

Almacenamiento en caché automático ( documentación ): No

Estructura de características :

FeaturesDict({

'coco_annotations': Sequence({

'area': int64,

'bbox': BBoxFeature(shape=(4,), dtype=float32),

'id': int64,

'label': int64,

}),

'image': Image(shape=(None, None, 3), dtype=uint8),

'image/id': int64,

'objects': Sequence({

'area': int64,

'bbox': BBoxFeature(shape=(4,), dtype=float32),

'gt_box_index': int64,

'id': int64,

'label': int64,

'mask': Image(shape=(None, None, 3), dtype=uint8),

'refexp': Sequence({

'raw': Text(shape=(), dtype=string),

'refexp_id': int64,

}),

}),

})

- Documentación de funciones :

| Característica | Clase | Forma | tipo D | Descripción |

|---|---|---|---|---|

| FuncionesDict | ||||

| anotaciones_coco | Secuencia | |||

| anotaciones_coco/área | Tensor | int64 | ||

| coco_annotaciones/bbox | Característica BBox | (4,) | flotador32 | |

| anotaciones_coco/id | Tensor | int64 | ||

| anotaciones_coco/etiqueta | Tensor | int64 | ||

| imagen | Imagen | (Ninguno, Ninguno, 3) | uint8 | |

| imagen/identificación | Tensor | int64 | ||

| objetos | Secuencia | |||

| objetos/área | Tensor | int64 | ||

| objetos/caja | Característica BBox | (4,) | flotador32 | |

| objetos/gt_box_index | Tensor | int64 | ||

| objetos/identificación | Tensor | int64 | ||

| objetos/etiqueta | Tensor | int64 | ||

| objetos/máscara | Imagen | (Ninguno, Ninguno, 3) | uint8 | |

| objetos/refexp | Secuencia | |||

| objetos/refexp/raw | Texto | cadena | ||

| objetos/refexp/refexp_id | Tensor | int64 |

Claves supervisadas (ver documento

as_supervised):NoneCitación :

@inproceedings{kazemzadeh2014referitgame,

title={Referitgame: Referring to objects in photographs of natural scenes},

author={Kazemzadeh, Sahar and Ordonez, Vicente and Matten, Mark and Berg, Tamara},

booktitle={Proceedings of the 2014 conference on empirical methods in natural language processing (EMNLP)},

pages={787--798},

year={2014}

}

@inproceedings{yu2016modeling,

title={Modeling context in referring expressions},

author={Yu, Licheng and Poirson, Patrick and Yang, Shan and Berg, Alexander C and Berg, Tamara L},

booktitle={European Conference on Computer Vision},

pages={69--85},

year={2016},

organization={Springer}

}

@inproceedings{mao2016generation,

title={Generation and Comprehension of Unambiguous Object Descriptions},

author={Mao, Junhua and Huang, Jonathan and Toshev, Alexander and Camburu, Oana and Yuille, Alan and Murphy, Kevin},

booktitle={CVPR},

year={2016}

}

@inproceedings{nagaraja2016modeling,

title={Modeling context between objects for referring expression understanding},

author={Nagaraja, Varun K and Morariu, Vlad I and Davis, Larry S},

booktitle={European Conference on Computer Vision},

pages={792--807},

year={2016},

organization={Springer}

}

ref_coco/refcoco_unc (configuración predeterminada)

Tamaño del conjunto de datos :

3.29 GiBDivisiones :

| Dividir | Ejemplos |

|---|---|

'testA' | 750 |

'testB' | 750 |

'train' | 16.994 |

'validation' | 1.500 |

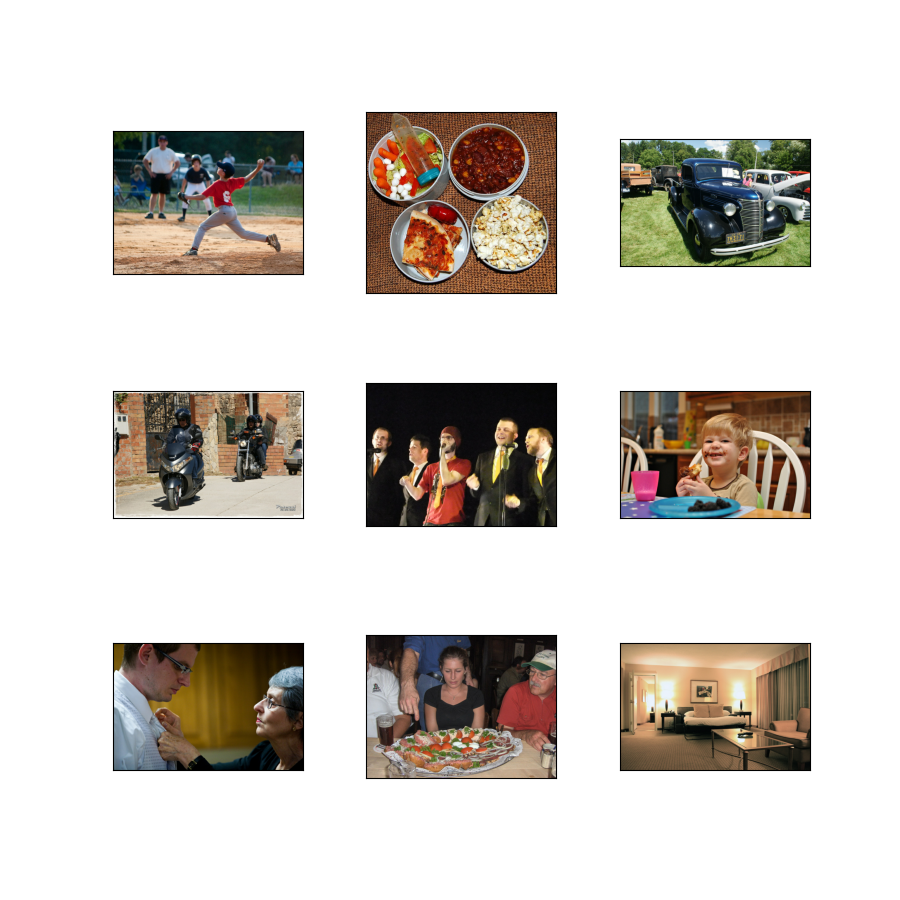

- Figura ( tfds.show_examples ):

- Ejemplos ( tfds.as_dataframe ):

ref_coco/refcoco_google

Tamaño del conjunto de datos :

4.65 GiBDivisiones :

| Dividir | Ejemplos |

|---|---|

'test' | 4.527 |

'train' | 19,213 |

'validation' | 4.559 |

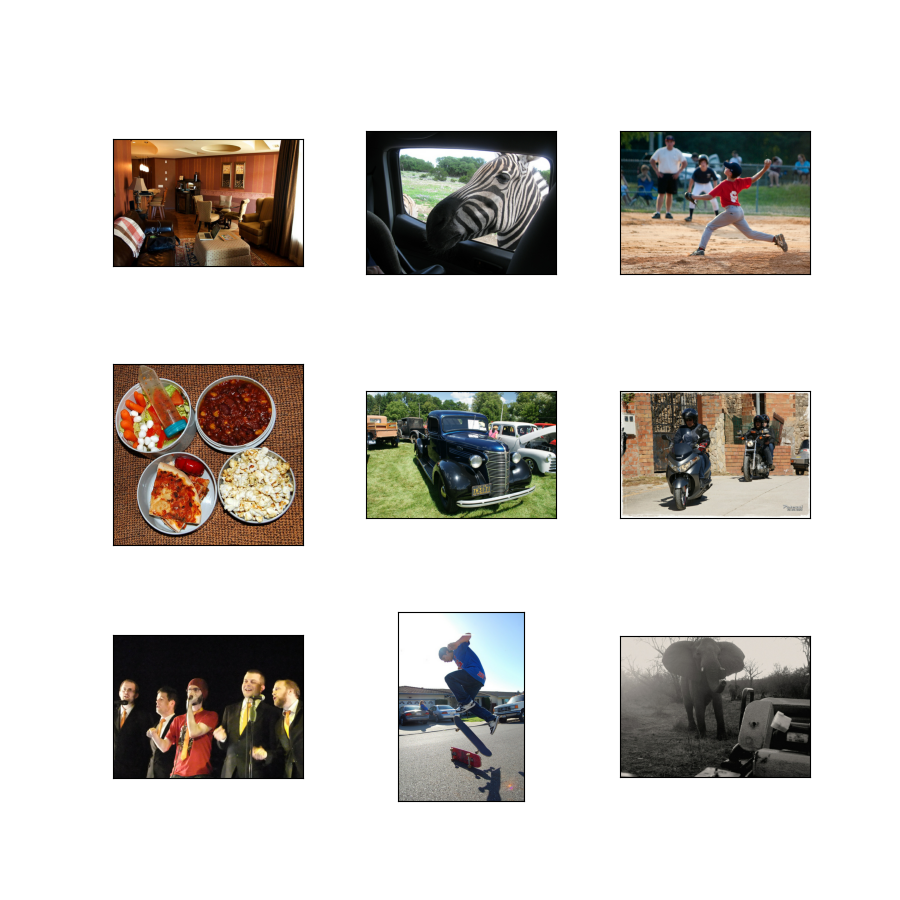

- Figura ( tfds.show_examples ):

- Ejemplos ( tfds.as_dataframe ):

ref_coco/refcocoplus_unc

Tamaño del conjunto de datos :

3.29 GiBDivisiones :

| Dividir | Ejemplos |

|---|---|

'testA' | 750 |

'testB' | 750 |

'train' | 16.992 |

'validation' | 1.500 |

- Figura ( tfds.show_examples ):

- Ejemplos ( tfds.as_dataframe ):

ref_coco/refcocog_google

Tamaño del conjunto de datos :

4.64 GiBDivisiones :

| Dividir | Ejemplos |

|---|---|

'train' | 24.698 |

'validation' | 4.650 |

- Figura ( tfds.show_examples ):

- Ejemplos ( tfds.as_dataframe ):

ref_coco/refcocog_umd

Tamaño del conjunto de datos :

4.08 GiBDivisiones :

| Dividir | Ejemplos |

|---|---|

'test' | 2.600 |

'train' | 21,899 |

'validation' | 1.300 |

- Figura ( tfds.show_examples ):

- Ejemplos ( tfds.as_dataframe ):