Phân tán `cập nhật` vào một tenxơ hiện có theo `chỉ số`.

Thao tác này tạo ra một tenxơ mới bằng cách áp dụng `cập nhật` thưa thớt cho dữ liệu được truyền trong `tensor`. Thao tác này rất giống với `tf.scatter_nd`, ngoại trừ việc các bản cập nhật được phân tán trên một tensor hiện có (ngược lại với tensor 0). Nếu bộ nhớ dành cho tensor hiện có không thể được sử dụng lại thì một bản sao sẽ được tạo và cập nhật.

Nếu `chỉ số` chứa các bản sao thì các cập nhật của chúng sẽ được tích lũy (tổng hợp).

CẢNH BÁO : Thứ tự áp dụng các bản cập nhật là không xác định, do đó đầu ra sẽ không xác định nếu `chỉ số` chứa các bản sao -- do một số vấn đề về xấp xỉ bằng số, các số được tính tổng theo thứ tự khác nhau có thể mang lại kết quả khác nhau.

`chỉ số` là một tensor số nguyên chứa các chỉ số thành một tensor mới có hình dạng `shape`. Chiều cuối cùng của `chỉ số` tối đa có thể là cấp `hình dạng`:

chỉ số.shape[-1] <= hình dạng.rank

Chiều cuối cùng của `indices` tương ứng với các chỉ mục thành các phần tử (nếu `indices.shape[-1] = shape.rank`) hoặc lát cắt (nếu `indices.shape[-1] < shape.rank`) dọc theo chiều `indices .shape[-1]` của `shape`. `updates` là một tensor có hình dạng

index.shape[:-1] + hình dạng[indices.shape[-1]:]

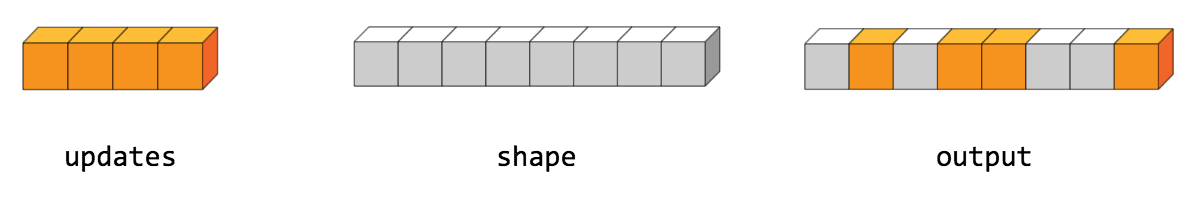

Hình thức phân tán đơn giản nhất là chèn các phần tử riêng lẻ vào một tensor theo chỉ số. Ví dụ: giả sử chúng ta muốn chèn 4 phần tử phân tán vào một tensor hạng 1 có 8 phần tử.

Trong Python, thao tác phân tán này sẽ trông như thế này:

>>> chỉ số = tf.constant([[4], [3], [1], [7]]) >>> cập nhật = tf.constant([9, 10, 11, 12]) >>> tensor = tf.ones([8], dtype=tf.int32) >>> print(tf.tensor_scatter_nd_update(tensor, chỉ số, cập nhật)) tf.Tensor([ 1 11 1 10 9 1 1 12], shape=(8 ,), dtype=int32)

Chúng ta cũng có thể chèn toàn bộ các lát cắt của tensor cấp cao hơn cùng một lúc. Ví dụ: nếu chúng ta muốn chèn hai lát cắt vào chiều thứ nhất của tensor hạng 3 với hai ma trận có giá trị mới.

Trong Python, thao tác phân tán này sẽ trông như thế này:

>>> chỉ số = tf.constant([[0], [2]]) >>> cập nhật = tf.constant([[[5, 5, 5, 5], [6, 6, 6, 6], ... [7, 7, 7, 7], [8, 8, 8, 8]], ... [[5, 5, 5, 5], [6, 6, 6, 6], .. . [7, 7, 7, 7], [8, 8, 8, 8]]]) >>> tensor = tf.ones([4, 4, 4], dtype=tf.int32) >>> print (tf.tensor_scatter_nd_update(tensor, chỉ mục, cập nhật).numpy()) [[[5 5 5 5] [6 6 6] [7 7 7 7] [8 8 8 8]] [[1 1 1 1] [1 1 1 1] [1 1 1 1] [1 1 1 1]] [[5 5 5 5] [6 6 6 6] [7 7 7 7] [8 8 8 8]] [[1 1 1 1] [1 1 1 1] [1 1 1 1] [1 1 1 1]]]

Lưu ý rằng trên CPU, nếu tìm thấy chỉ mục ngoài giới hạn, lỗi sẽ được trả về. Trên GPU, nếu tìm thấy chỉ mục ngoài giới hạn, chỉ mục đó sẽ bị bỏ qua.

Phương pháp công khai

| Đầu ra <T> | asOutput () Trả về phần điều khiển tượng trưng của một tenxơ. |

| tĩnh <T, U mở rộng Số> TensorScatterUpdate <T> | |

| Đầu ra <T> | đầu ra () Một tensor mới có hình dạng nhất định và các cập nhật được áp dụng theo các chỉ số. |

Phương pháp kế thừa

Phương pháp công khai

Đầu ra công khai <T> asOutput ()

Trả về phần điều khiển tượng trưng của một tenxơ.

Đầu vào của các hoạt động TensorFlow là đầu ra của một hoạt động TensorFlow khác. Phương pháp này được sử dụng để thu được một thẻ điều khiển mang tính biểu tượng đại diện cho việc tính toán đầu vào.

public static TensorScatterUpdate <T> tạo ( Phạm vi phạm vi, tensor toán hạng <T>, chỉ số toán hạng <U>, cập nhật toán hạng <T>)

Phương thức gốc để tạo một lớp bao bọc một thao tác TensorScatterUpdate mới.

Thông số

| phạm vi | phạm vi hiện tại |

|---|---|

| tenxơ | Tenor để sao chép/cập nhật. |

| chỉ số | Tenxơ chỉ số. |

| cập nhật | Cập nhật để phân tán vào đầu ra. |

Trả lại

- một phiên bản mới của TensorScatterUpdate

Đầu ra công khai đầu ra <T> ()

Một tensor mới có hình dạng nhất định và các cập nhật được áp dụng theo các chỉ số.